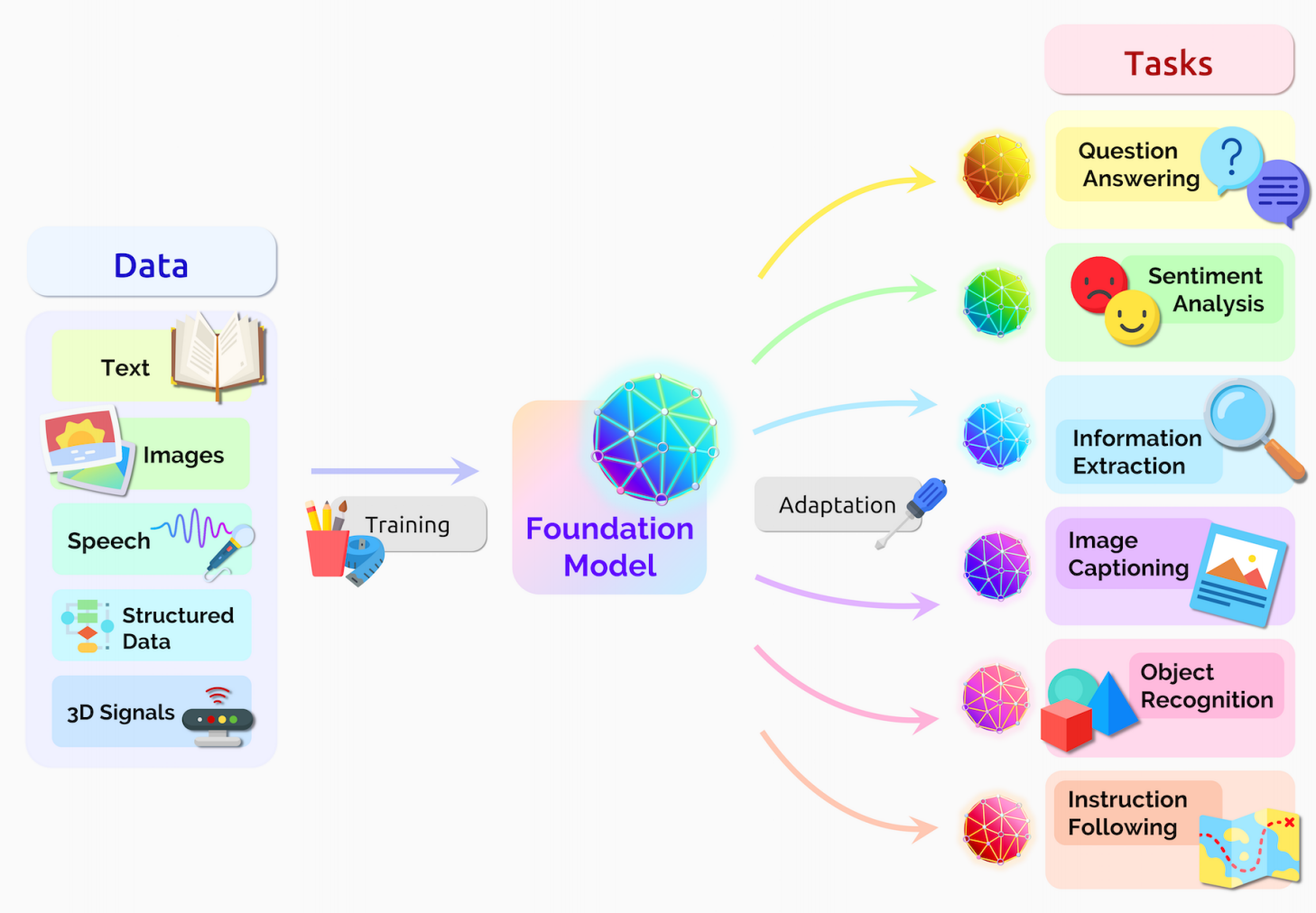

基礎模型(或稱為基礎預訓練模型)通常指的是經過大規模數據集預訓練、能夠在多種任務上執行基本功能的模型。這些模型通常是大規模神經網絡,經過預先訓練,可以在不同的應用中作為出發點進行微調(fine-tuning)或直接使用。基礎模型的關鍵特點是其廣泛的泛化能力和強大的適應能力,能夠為各種任務提供有效的初始表現。

預訓練(Pretraining):基礎模型通常在一個非常大的數據集上進行預訓練,這個數據集覆蓋了廣泛的主題和領域。例如,GPT 系列模型是在大量的文本數據上進行訓練的,包含了各類知識和語言模式。

通用性(Generality):基礎模型通常是通用的,不針對特定任務進行優化。這使得它能夠執行多種任務,但可能不會在任何一個任務上達到最優表現。

微調(Fine-Tuning):雖然基礎模型在很多情況下已經表現得相當好,但為了在特定任務上取得更好的效果,通常會對其進行微調。微調是基於特定任務的數據集對基礎模型進行再訓練,從而使模型能夠更好地適應該任務。

高效利用:基礎模型使得開發者不必從頭開始訓練一個新模型,而是可以在現有模型的基礎上進行優化。這節省了大量的計算資源和時間。

GPT(Generative Pre-trained Transformer):GPT 是一個基礎模型,通過在海量文本數據上進行預訓練,能夠生成連貫的文本、進行語言翻譯、回答問題等。開發者可以將其用於生成內容、客服對話等任務。

BERT(Bidirectional Encoder Representations from Transformers):BERT 也是一個基礎模型,擅長處理自然語言理解任務,比如問答、情感分析等。它通過雙向上下文理解來捕捉文本信息。

CLIP(Contrastive Language-Image Pretraining):CLIP 是一個可以同時理解文本和圖像的基礎模型,能夠執行如圖像搜索、圖像分類等任務。它通過在圖像和文本的聯合數據集上進行訓練,使得它能夠理解圖像和語言之間的關係。

減少訓練成本:訓練一個強大的深度學習模型需要大量的數據和計算資源,基礎模型通過共享一個通用的預訓練權重,降低了開發成本。

提升效率:開發人員可以直接在基礎模型的基礎上進行任務的微調,這樣可以大幅度縮短開發週期,同時提高效率。

增強模型性能:由於基礎模型通常是在大規模數據集上預訓練的,它能夠學到豐富的特徵表示,因此在許多任務中會展現出很好的性能,甚至能夠避免過擬合。

基礎模型是深度學習和人工智能領域的重要組成部分,它們通過在廣泛的數據集上進行預訓練,獲得了較強的通用性和適應性。通過微調,基礎模型可以應用於各種特定任務,節省了大量的計算資源和時間。