對於視頻創作者、AI 動畫開發者以及多語言教學者來說,口型同步一直是耗時又技術門檻高的環節。而現在,一項來自Sync Labs 的新技術,正在徹底改變這一局面。

近日,AI 技術公司Sync Labs正式發布了其最新力作—— Lipsync-2 。這是全球首個零-shot 嘴型同步模型,意味著用戶無需對目標人物進行任何訓練或微調,即可自動生成自然、準確的嘴型同步效果。

這項突破性技術,為創作流程帶來了前所未有的效率與自由度。

Lipsync-2 最大的亮點在於它的“零-shot 口型同步”能力。傳統模型往往需要對每位演講者進行單獨訓練,以捕捉其說話風格、口型習慣等特徵。而Lipsync-2 則完全跳過這一環節:

無需訓練,自動適應說話風格支持真人、動畫、AI 虛擬角色表現力與自然度全面提升

這一特性對於個人內容創作者和中小團隊來說,尤其具有革命意義。無論是製作教育視頻、翻譯講座,還是打造虛擬主播,Lipsync-2 都能極大地節省時間與成本。

除了核心技術升級,Lipsync-2 還引入了一項創作者必備的可控功能—— “溫度(Temperature)參數” 。

這個參數可以讓用戶調節嘴型同步的自然程度:

低溫度:嘴型貼近現實,適合正式場景如新聞、教學;

高溫度:嘴型更誇張有表現力,適合娛樂、動畫等富有創意的內容。

目前,該功能正逐步向付費用戶開放私人測試,未來有望成為內容個性化創作的重要工具。

Sync Labs 在4 月3 日發布的演示視頻中提出了一個引人注目的願景:

“讓每一場講座,都能以每種語言被呈現。”

這不僅僅是視頻翻譯的升級,更是一次對教育與傳播方式的革新。 Lipsync-2 的潛力正在以下領域迅速釋放:

多語言內容創作:將原語音同步至任意語言,提升全球觀眾體驗;

遊戲與動畫配音:角色嘴型更自然,打破傳統動畫製作瓶頸;

教育培訓視頻:講師無需重複拍攝,自動生成多語言版本;

AI 虛擬人設定:個性化嘴型,增強互動真實感。

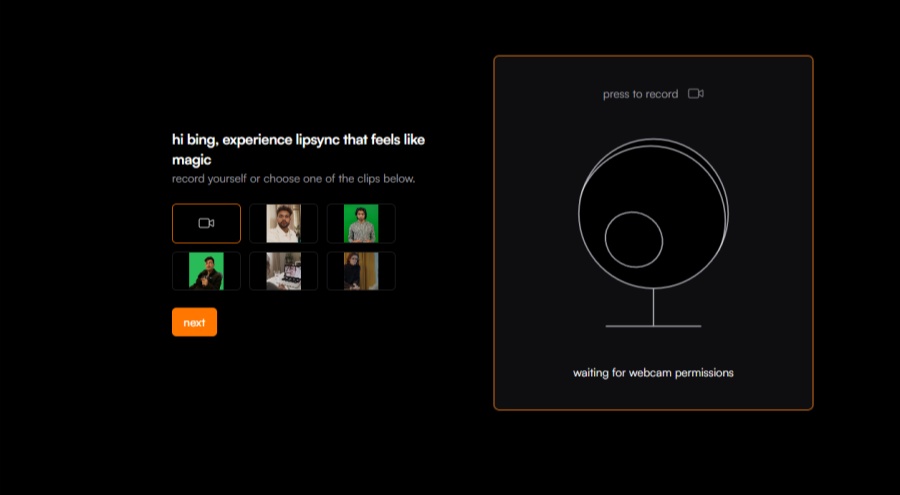

目前,Lipsync-2 已上線fal 模型平台,用戶可直接前往試用這一新工具。自4 月1 日發布以來,Twitter 上關於該技術的討論熱度持續攀升,許多業內人士表示:

“Lipsync-2 可能是AI 視頻創作領域的ChatGPT 時刻。”

而隨著該功能持續推廣、API 能力開放,它可能會成為未來內容創作平台的重要基礎能力之一。

Sync Labs 通過Lipsync-2,再次展現了其在AI 視頻技術領域的前沿地位。而這項“無需訓練即可自動生成嘴型”的技術,不僅僅是提升效率,更是在讓AI 成為內容創作的協作夥伴。

對於剛入門的AI 愛好者、視頻製作者、動畫師而言,現在正是了解和嘗試這一技術的好時機—— 它不再只是專家專屬的黑科技,而是真正“人人可用”的內容生產力工具。