MiniMax於2025年1月15日宣布開源其全新系列模型MiniMax-01,該系列包含基礎語言大模型MiniMax-Text-01和視覺多模態大模型MiniMax-VL-01。 MiniMax-01系列在架構上進行了大膽創新,首次大規模實現線性注意力機制,打破了傳統Transformer架構的限制。其參數量高達4560億,單次激活459億,綜合性能與海外頂尖模型相當,且能高效處理長達400萬token的上下文,這一長度是GPT-4o的32倍、Claude-3.5-Sonnet的20倍。

MiniMax認為2025年將是Agent高速發展的關鍵年份,無論是單Agent系統還是多Agent系統,都需要更長的上下文來支援持續記憶和大量通訊。 MiniMax-01系列模型的推出,正是為了滿足這項需求,踏出建立複雜Agent基礎能力的第一步。

得益於架構創新、效率優化以及集群訓推一體設計,MiniMax能夠以業內最低的價格區間提供文本和多模態理解的API服務,標準定價為輸入token1元/百萬token,輸出token8元/百萬token。 MiniMax開放平台及海外版已上線,供開發者體驗使用。

MiniMax-01系列模型已在GitHub開源,並將持續更新。在業界主流的文本和多模態理解評估中,MiniMax-01系列在多數任務上追平了海外公認的先進模型GPT-4o-1120和Claude-3.5-Sonnet-1022。特別是在長文任務上,與Google的Gemini模型相比,MiniMax-Text-01隨著輸入長度增加,效能衰減最慢,顯著優於Gemini。

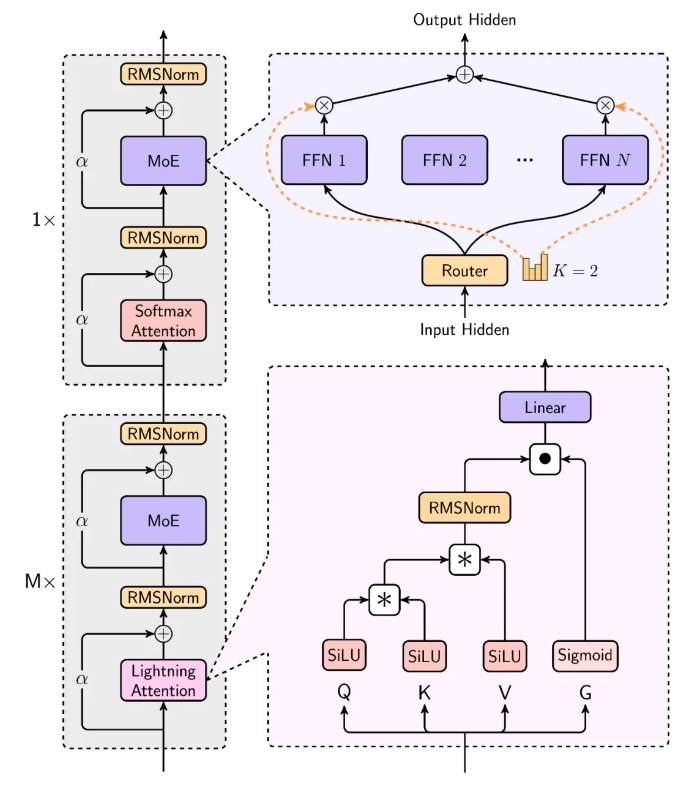

MiniMax的模型在處理長輸入時效率極高,接近線性複雜度。其結構設計中,每8層中有7層採用基於Lightning Attention的線性注意力,1層採用傳統SoftMax注意力。這是業界首次將線性注意力機制擴展到商用模型級別,MiniMax在Scaling Law、與MoE結合、結構設計、訓練優化和推理優化等方面進行了綜合考量,並重構了訓練和推理系統,包括更高效的MoE All-to-all通訊優化、更長序列優化以及推理層面線性注意力的高效Kernel實現。

在大部分學術集上,MiniMax-01系列取得了比肩海外第一梯隊的成果。在長上下文測評集上更是顯著領先,如在400萬的Needle-In-A-Haystack檢索任務上表現優異。除了學術資料集,MiniMax還建立了基於真實資料的助理場景測試集,MiniMax-Text-01在該場景中表現突出。在多模態理解測試集中,MiniMax-VL-01也較為領先。

開源位址: https://github.com/MiniMax-AI

AI課程適合對人工智能技術感興趣的人,包括但不限於學生、工程師、數據科學家、開發者以及AI技術的專業人士。

課程內容從基礎到高級不等,初學者可以選擇基礎課程,逐步深入到更複雜的算法和應用。

學習AI需要一定的數學基礎(如線性代數、概率論、微積分等),以及編程知識(Python是最常用的編程語言)。

將學習自然語言處理、計算機視覺、數據分析等領域的核心概念和技術,掌握使用AI工具和框架進行實際開發。

您可以從事數據科學家、機器學習工程師、AI研究員、或者在各行各業應用AI技術進行創新。