在多模態大語言模型(MLLMs)的推動下,影像和影片相關的任務取得了革命性的進展,包括視覺問答、敘事生成和互動式編輯等。然而,實現細粒度的影片內容理解仍面臨重大挑戰。這項挑戰涉及像素級的分割、帶有語言描述的跟踪,以及在特定視訊提示上進行視覺問答等任務。

儘管目前最先進的視訊感知模型在分割和追蹤任務上表現出色,但它們在開放式語言理解和對話能力方面仍顯不足。此外,視訊MLLMs 在視訊理解和問答任務上表現良好,但在處理感知任務和視覺提示方面依然力不從心。

現有的解決方案主要有兩種:多模態大語言模型(MLLMs)和引用分割系統。 MLLMs 最初致力於改進多模態融合方法和特徵提取器,逐漸發展為在LLMs 上進行指令調優的框架,如LLaVA。近期,研究人員嘗試將影像、視訊和多影像分析統一到單一框架中,如LLaVA-OneVision。同時,引用分割系統也經歷了從基本融合模組到整合分割和追蹤的變化。然而,這些解決方案在感知和語言理解能力的全面整合上仍有不足。

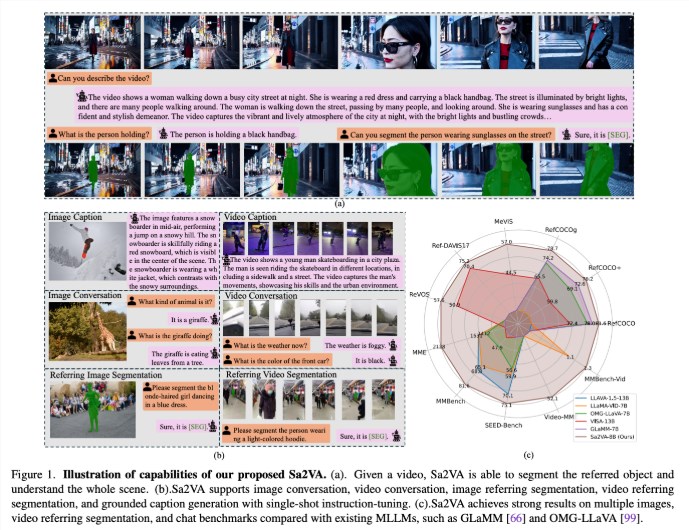

來自UC Merced、位元組跳動種子團隊、武漢大學和北京大學的研究人員提出了Sa2VA,這是一種開創性的統一模型,旨在實現圖像和視訊的密集基礎理解。該模型透過最小化一次性指令調優,支援廣泛的影像和視訊任務,克服了現有多模態大語言模型的限制。

Sa2VA 創新地將SAM-2與LLaVA 整合,將文字、圖像和視訊統一到共享的LLM 代幣空間中。此外,研究人員還推出了一個名為Ref-SAV 的廣泛自動標註資料集,包含超過72K 個複雜視訊場景中的物件表達,以及2K 個經過人工驗證的視訊對象,以確保穩健的基準能力。

Sa2VA 的架構主要由兩個部分組成:類似LLaVA 的模型和SAM-2,採用了一種新穎的解耦設計。 LLaVA-like 元件包括處理影像和視訊的視覺編碼器、視覺投影層以及用於文字令牌預測的LLM。該系統採用獨特的解耦方式,使得SAM-2在預訓練的LLaVA 模型旁邊運作,而不進行直接的令牌交換,從而保持計算效率,並允許與各種預訓練的MLLMs 進行插拔式功能連接。

研究結果表明,Sa2VA 在引用分割任務中取得了最先進的結果,其Sa2VA-8B 模型在RefCOCO、RefCOCO + 和RefCOCOg 上的cIoU 評分分別為81.6、76.2和78.9,超越了GLaMM-7B 等之前的系統。在對話能力方面,Sa2VA 在MME、MMbench 和SEED-Bench 上分別取得了2128、81.6和75.1的優異成績。

此外,Sa2VA 在視訊基準測試中的表現也顯著超過了先前的狀態- of-the-art VISA-13B,顯示其在圖像和視訊理解任務中的高效性與有效性。

論文:https://arxiv.org/abs/2501.04001

模型:https://huggingface.co/collections/ByteDance/sa2va-model-zoo-677e3084d71b5f108d00e093

AI課程適合對人工智能技術感興趣的人,包括但不限於學生、工程師、數據科學家、開發者以及AI技術的專業人士。

課程內容從基礎到高級不等,初學者可以選擇基礎課程,逐步深入到更複雜的算法和應用。

學習AI需要一定的數學基礎(如線性代數、概率論、微積分等),以及編程知識(Python是最常用的編程語言)。

將學習自然語言處理、計算機視覺、數據分析等領域的核心概念和技術,掌握使用AI工具和框架進行實際開發。

您可以從事數據科學家、機器學習工程師、AI研究員、或者在各行各業應用AI技術進行創新。