什麼是Exaone-3.5-24B-Instruct-Gguf?

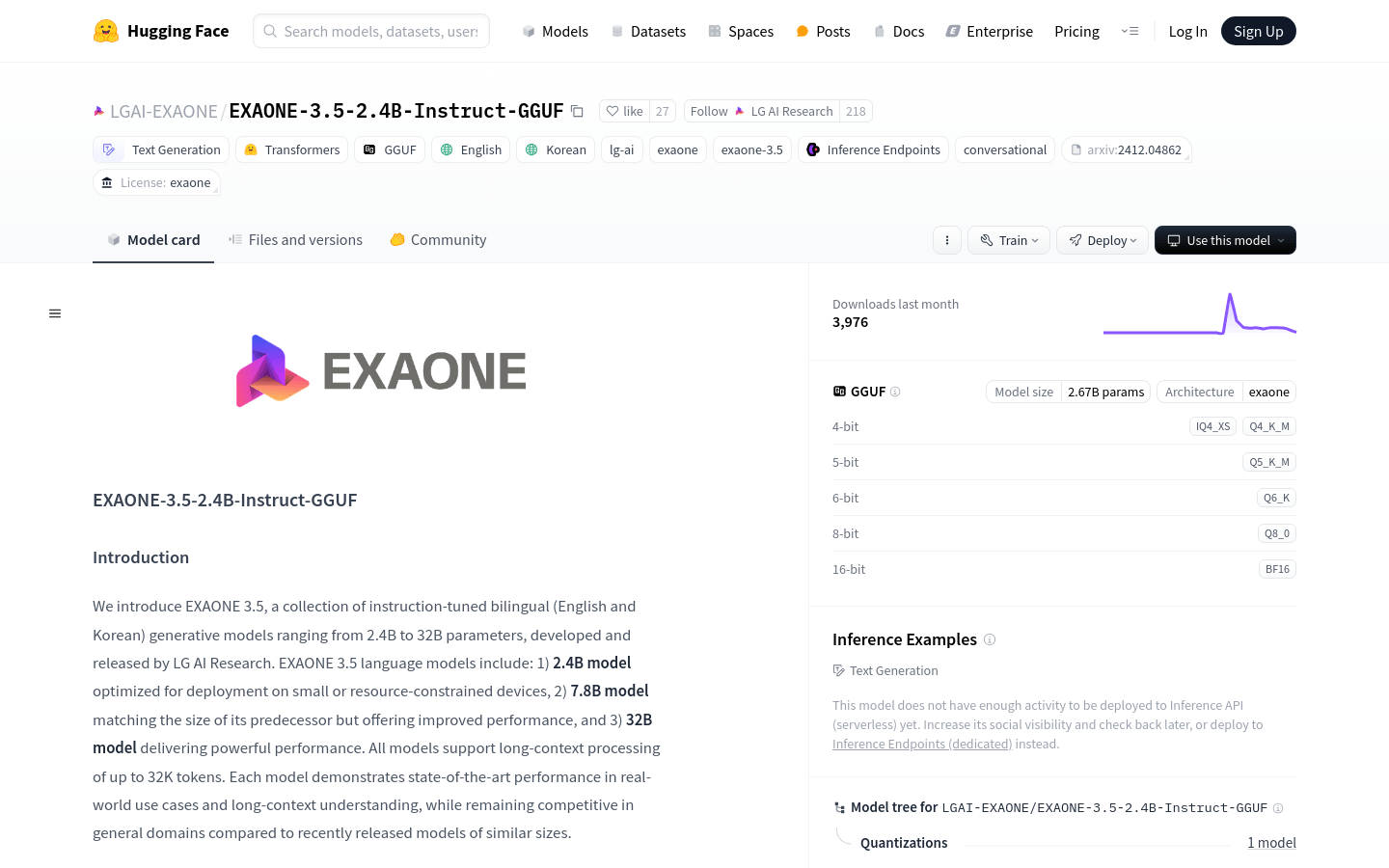

Exaone-3.5-24B-Instruct-Gguf是LG AI Research開發的一系列雙語(英語和韓語)指導調節的生成模型。這些模型的參數尺寸範圍從24億至320億個參數。他們支持長篇小說處理高達32K令牌,並在現實世界中表現出最先進的性能和長期以來的理解,同時與最近發布的類似尺寸的模型相比,在一般域中保持競爭性能。該模型已優化用於在小型或資源約束設備上部署,從而提供強大的性能。

誰能從使用Exaone-3.5-24B-Instruct-Gguf中受益?

該模型非常適合希望在資源有限設備上部署高性能語言模型的研究人員和開發人員,以及需要處理長文本和多語言文本生成的應用程序開發人員。它針對部署和穩健性能的優化,再加上對長篇小說理解和多語言功能的支持,使其特別有用。

在哪些情況下,可以使用3.5-24B-Instruct-Gguf?

研究人員可以利用Exaone-3.5-24B-Instruct-Gguf模型來用於涉及長文本的語義理解研究。

開發人員可以使用此模型在移動設備上實現實時多語言翻譯功能。

企業可以增強其客戶服務自動響應系統,從而提高此模型的效率和準確性。

Exaone-3.5-24B-Instruct-Gguf的關鍵特徵是什麼?

支持多達32K代幣的長上下文處理。

有三種不同的量表可供選擇:24億,78億和320億個參數,適合各種部署需求。

在現實世界應用中展示了領先的性能。

支持雙語(英語和韓語)文本生成。

優化以更好地理解和執行。

提供多個量化版本,以符合不同的計算和存儲要求。

可以在包括Tensorrt-LLM,VLLM和SGLANG在內的各種框架中部署。

您如何使用Exaone-3.5-24B-Instruct-Gguf?

安裝Llama.cpp,按照GitHub存儲庫中提供的Llama.cpp的安裝指南。

下載Exaone 3.5型號的GGUF格式文件。

使用HuggingFace-CLI工具將特定的模型文件下載到本地目錄。

使用Llama-CLI工具和設置系統提示來運行該模型,例如“您是LG AI研究的Exaone模型,有用的助手”。

根據您的需求選擇適當的量化版本進行部署和推理。

將模型部署到用於實際應用的受支持的框架中。

監視生成的文本,以確保符合LG AI的道德準則。

要進行進一步的優化和性能增強,請參閱GitHub上的技術報告,博客和說明。