GLM-4-Voice

GLM-4-Voice提供創新的人工智慧工具,可輕鬆且有效率地創建沉浸式語音驅動的網路體驗。

什麼是GLM-4-Voice ?

GLM-4-Voice是清華大學開發的先進的端對端語音模型。它可以理解並產生中英文語音,實現即時語音對話。該模型採用尖端的語音辨識和合成技術,實現語音到文字、再到語音的無縫轉換。它提供低延遲和高智慧對話功能,並針對情緒表達和語音合成進行了優化。

目標用戶:

GLM-4-Voice的目標受眾包括開發人員、企業以及需要即時語音互動的個人或組織。對於開發人員來說,它提供了建立語音互動應用程式的強大工具。對於企業來說,可以提高客戶服務效率和品質。對於個人用戶來說,它提供了一種新形式的語音互動體驗。

範例場景:

用輕柔的聲音引導使用者放鬆。

用興奮的聲音解說足球比賽。

用悲切的聲音講鬼故事。

主要特點:

語音辨識:將連續語音輸入轉換為離散標記。

語音合成:將離散語音標記轉換為連續語音輸出。

情緒控制:根據使用者指示調整語音情緒、語調、速度和方言。

流式推理:支援文字和語音交替流輸出,減少端對端會話延遲。

預訓練能力:經過數百萬小時的音訊和數十億的文字標記進行訓練,具有強大的音訊理解和建模能力。

多語言支援:可以直接理解並產生中英文語音進行即時對話。

入門指南:

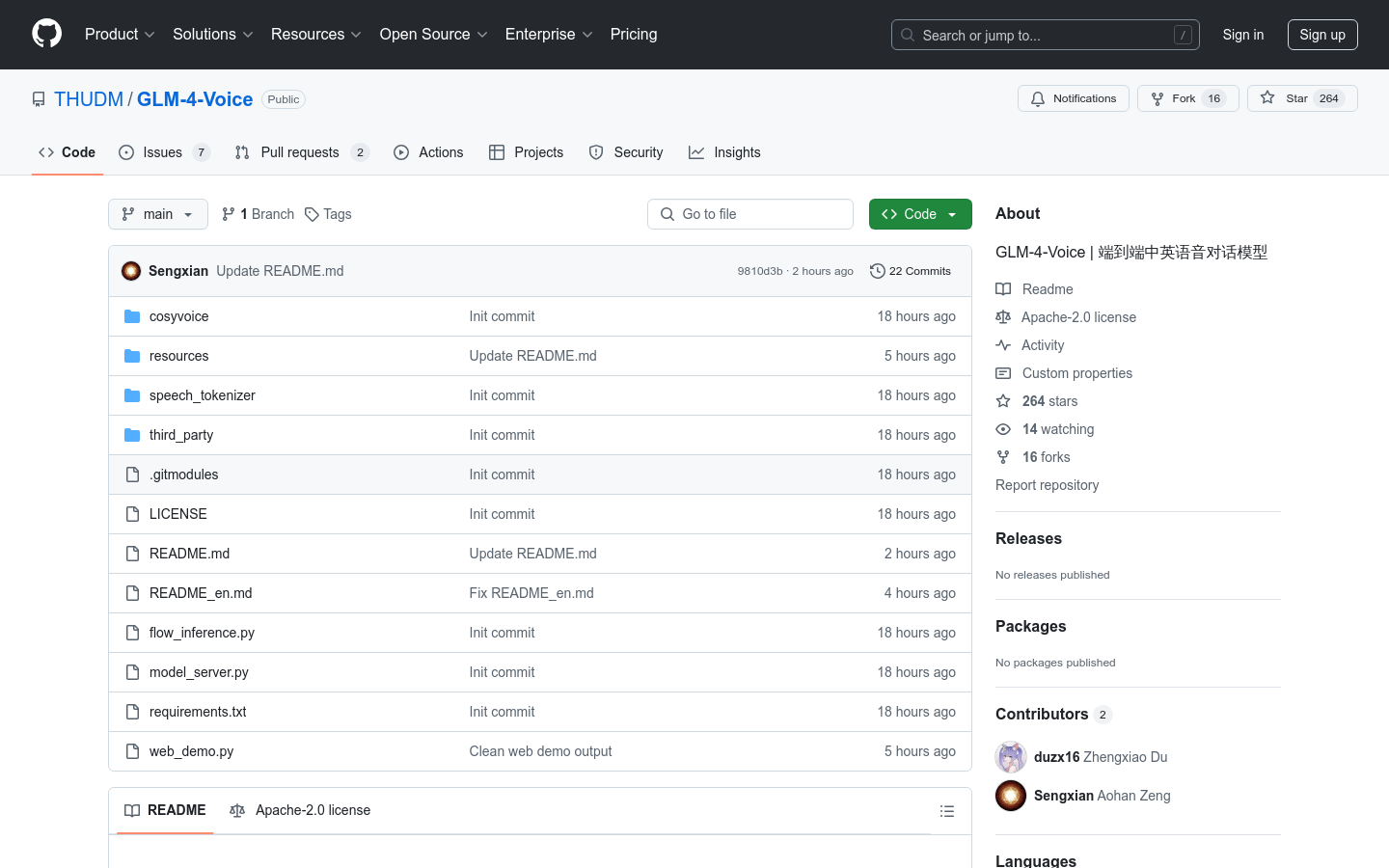

1. 使用 Git 指令克隆儲存庫。

2. 使用requirements.txt 安裝Python 相依性。

3. 根據專案指南下載所需的語音模型和分詞器。

4. 透過執行 model_server.py 啟動模型服務。

5. 透過執行 web_demo.py 啟動 Web 演示。

6. 在瀏覽器中存取 Web 演示:http://127.0.0.1:8888。