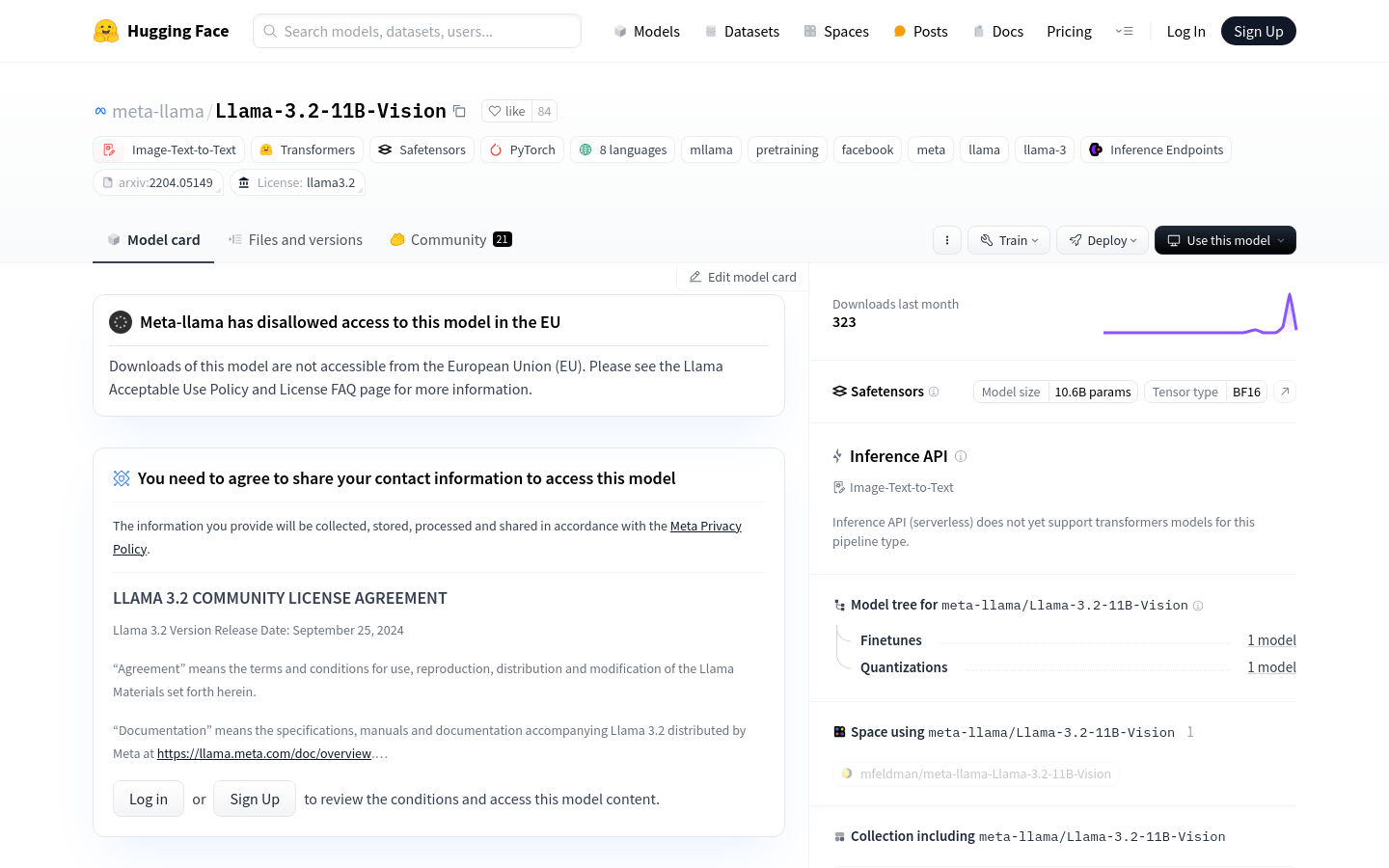

Llama-3.2-11B-Vision

Llama-3.2-11B-Vision提供先進的人工智慧來創建和增強視覺內容,使用戶可以輕鬆產生高品質的圖像和圖形。

Llama-3.2-11B-Vision

Llama-3.2-11B-Vision是Meta發布的多模態大型語言模型,它融合了圖像和文字處理能力,旨在提升視覺識別、圖像推理、圖像描述以及圖像相關問題的解答能力。此模型在多個產業基準測試中表現優於眾多開源及閉源多模態模型。

目標用戶

研究人員開發者企業用戶他們需要結合圖像和文字提升AI系統效能。

使用場景

視覺問答用戶上傳圖片並提問,模型給出答案。

文件視覺問答模型理解文件文字和佈局,並回答圖像相關問題。

圖像描述自動生成社交媒體圖片的描述性文字。

圖像文字檢索可協助使用者找到與上傳圖片內容相符的文字描述。

產品特性

視覺辨識優化模型辨識影像中的物件和場景。

圖像推理模型理解圖像內容並進行邏輯推理。

圖像描述產生描述圖像內容的文字。

圖像問答理解圖像並回答使用者基於圖像的問題。

多語言支援圖像文字應用程式僅支援英文,但文字任務支援英語德語法語義大利語葡萄牙語印地語西班牙語和泰語。

許可協議使用Llama 3.2社區許可協議。

負責任部署遵循Meta最佳實踐,確保模型安全性和實用性。

使用教程

1 安裝transformers庫確保已安裝並更新transformers庫至最新版本。

2 載入模型使用transformers庫中的MllamaForConditionalGeneration和AutoProcessor類別來載入模型和處理器。

3 準備輸入將圖像和文字提示組合成模型可接受的輸入格式。

4 產生文字呼叫模型的generate方法產生基於輸入圖像和提示的文字。

5 輸出處理解碼並展示產生的文字。

6 遵守許可使用模型時,遵守Llama 3.2社區許可協議條款。