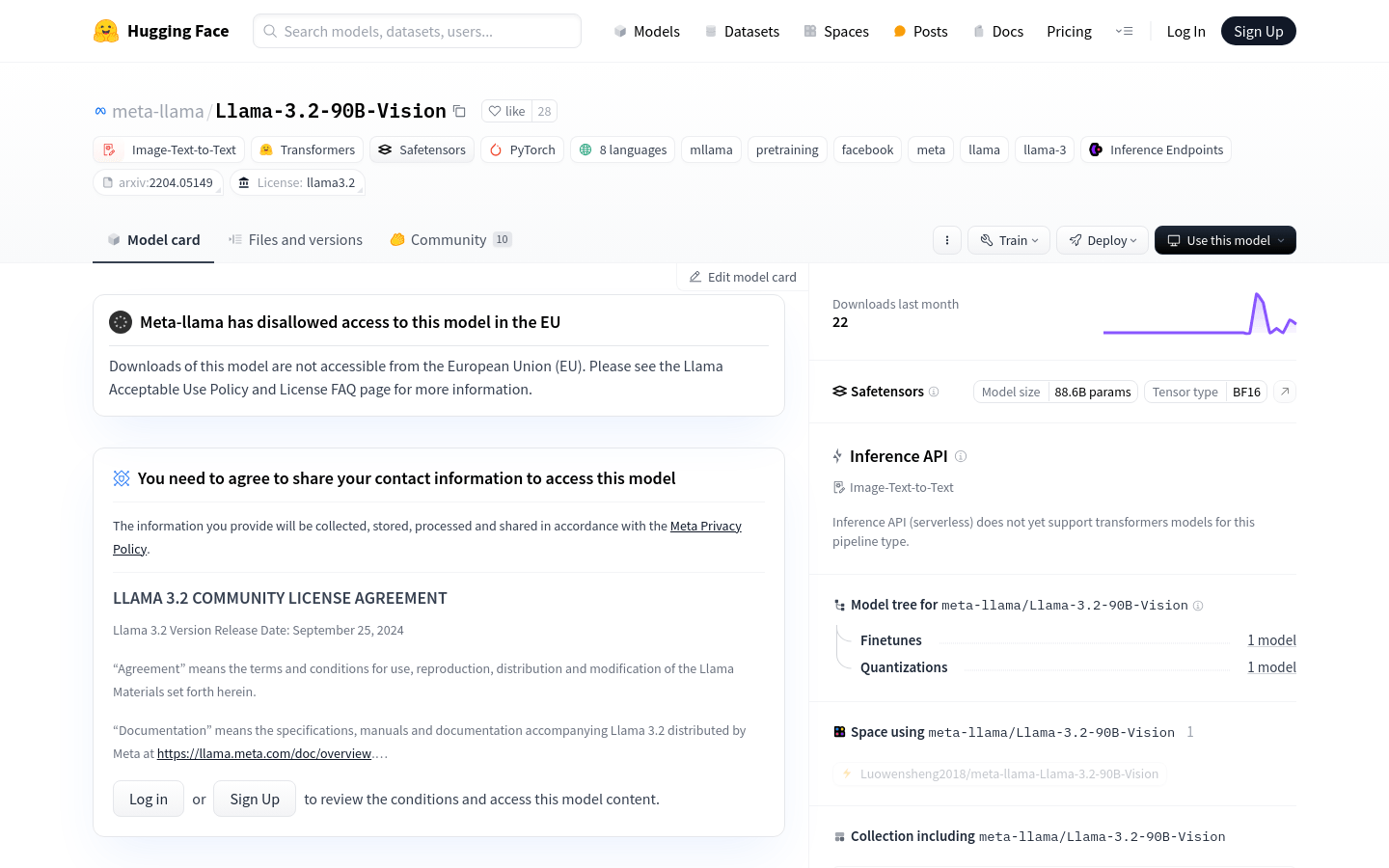

Llama-3.2-90B-Vision

Llama-3.2-90B-Vision為開發人員提供了強大、高效、多功能的視覺語言任務大語言模型,實現了尖端的AI應用。

Llama-3.2-90B-Vision是Meta公司發布的多模態大型語言模型(LLM),專注於視覺識別、圖像推理、圖片描述和回答有關圖片的一般問題。該模型在常見的行業基準測試中超越了許多現有的開源和封閉的多模態模型。

需求人群:

"目標受眾包括研究人員、開發者、企業用戶以及對人工智慧和機器學習領域感興趣的個人。此模型適合需要進行影像處理和理解的高級應用,如自動內容生成、影像分析、智慧助理開發等。

使用場景範例:

使用模型為電子商務網站產生產品圖片的描述。

整合到智慧助理中,提供基於影像的問答服務。

用於教育領域,幫助學生理解複雜圖表和圖解。

產品特色:

視覺辨識:優化模型以識別圖片中的物件和場景。

圖像推理:根據圖片內容進行邏輯推理並回答相關問題。

圖片描述:產生描述圖片內容的文字。

助手式聊天:結合圖片和文字進行對話,提供類似助手的互動體驗。

視覺問答(VQA):理解圖片內容並回答有關問題。

文件視覺問答(DocVQA):理解文件佈局和文本,然後回答相關問題。

圖像-文字檢索:將圖片與描述性文字配對。

視覺定位:理解語言如何引用圖片的特定部分,使AI模型能夠根據自然語言描述定位物體或區域。

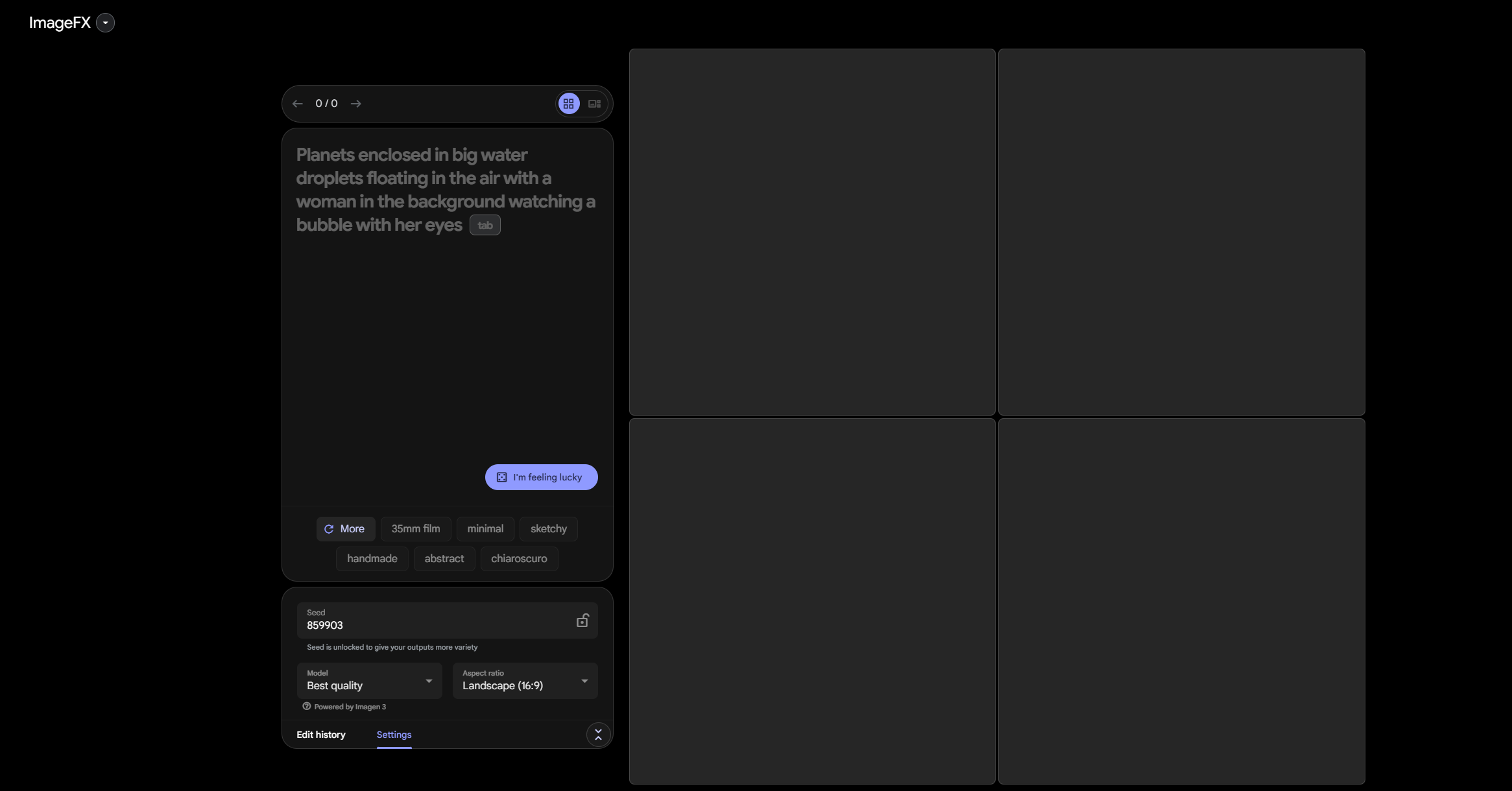

使用教學:

1. 安裝必要的函式庫,如transformers和torch。

2. 使用Hugging Face的模型識別碼載入Llama-3.2-90B-Vision模型。

3. 準備輸入數據,包括圖片和文字提示。

4. 使用模型的處理器處理輸入資料。

5. 將處理後的資料輸入模型並產生輸出。

6. 解碼模型輸出,取得文字結果。

7. 根據需要進一步處理或展示結果。