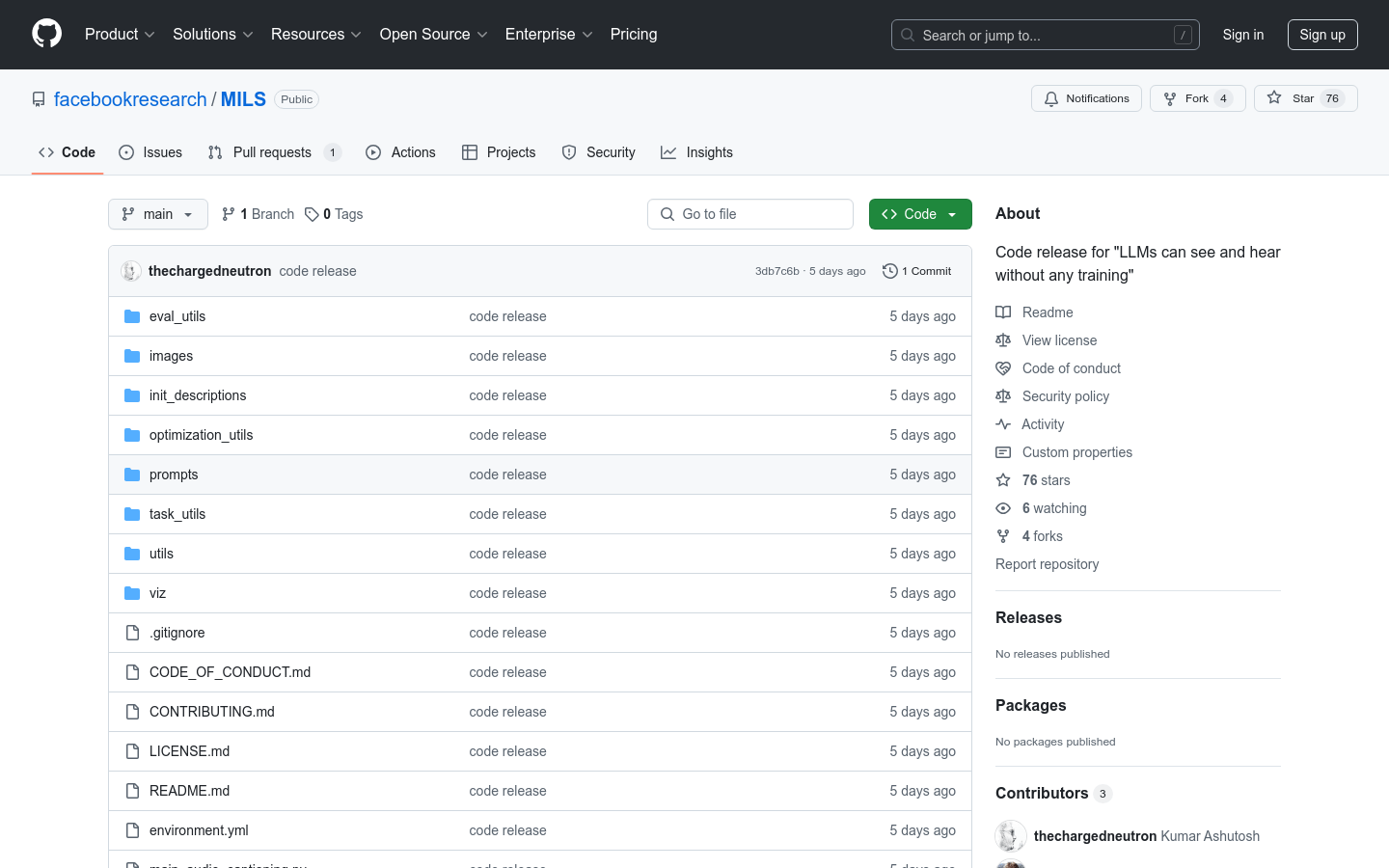

MILS

MILS使用預訓練的模型為圖像,音頻和視頻生成描述,非常適合探索多語言任務的研究人員和開發人員。

什麼是MILS ?

MILS是Facebook Research的一個開源項目,它展示了大型語言模型可以在沒有特定培訓的情況下處理視覺和聽覺任務。該項目使用預訓練的模型和優化算法來自動為圖像,音頻和視頻生成描述。它代表了多模式AI的重大進步,證明了大語言模型在跨模式任務中的潛力。該技術針對有興趣探索多模式AI新應用的研究人員和開發人員。

誰可以從MILS中受益?

該產品非常適合人工智能研究人員,開發人員和對多模式生成任務感興趣的專業人員。它為研究人員提供了一種強大的工具,可以探索和開發新的多模式應用程序,並為開發人員提供現成的代碼和模型,以快速實施相關功能。

示例用法方案

使用MILS在MS-Coco數據集中為圖像生成描述。

在Clotho數據集中生成音頻文件的描述。

在MSR-VTT數據集中為視頻創建描述。

MILS的關鍵特徵

支持圖像,音頻和視頻的自動描述生成。

使用預訓練的模型優化不同模式的性能。

為各種任務提供示例代碼,例如圖像,音頻和視頻字幕。

支持多GPU並行處理以提高效率。

提供詳細的安裝和使用指南,以便於入職。

開始使用MILS

1。通過運行conda env create -f環境來安裝所需的依賴項並激活環境。

2。將必要的數據集(圖像,音頻和視頻)下載到指定的目錄。

3。更新路徑文件中的路徑以設置數據集和輸出目錄的位置。

4。根據您的任務選擇適當的腳本並運行它。例如,使用mainimagecaption.py進行圖像描述生成。

5。使用計算BLEU和流星等性能指標的腳本評估生成的結果。