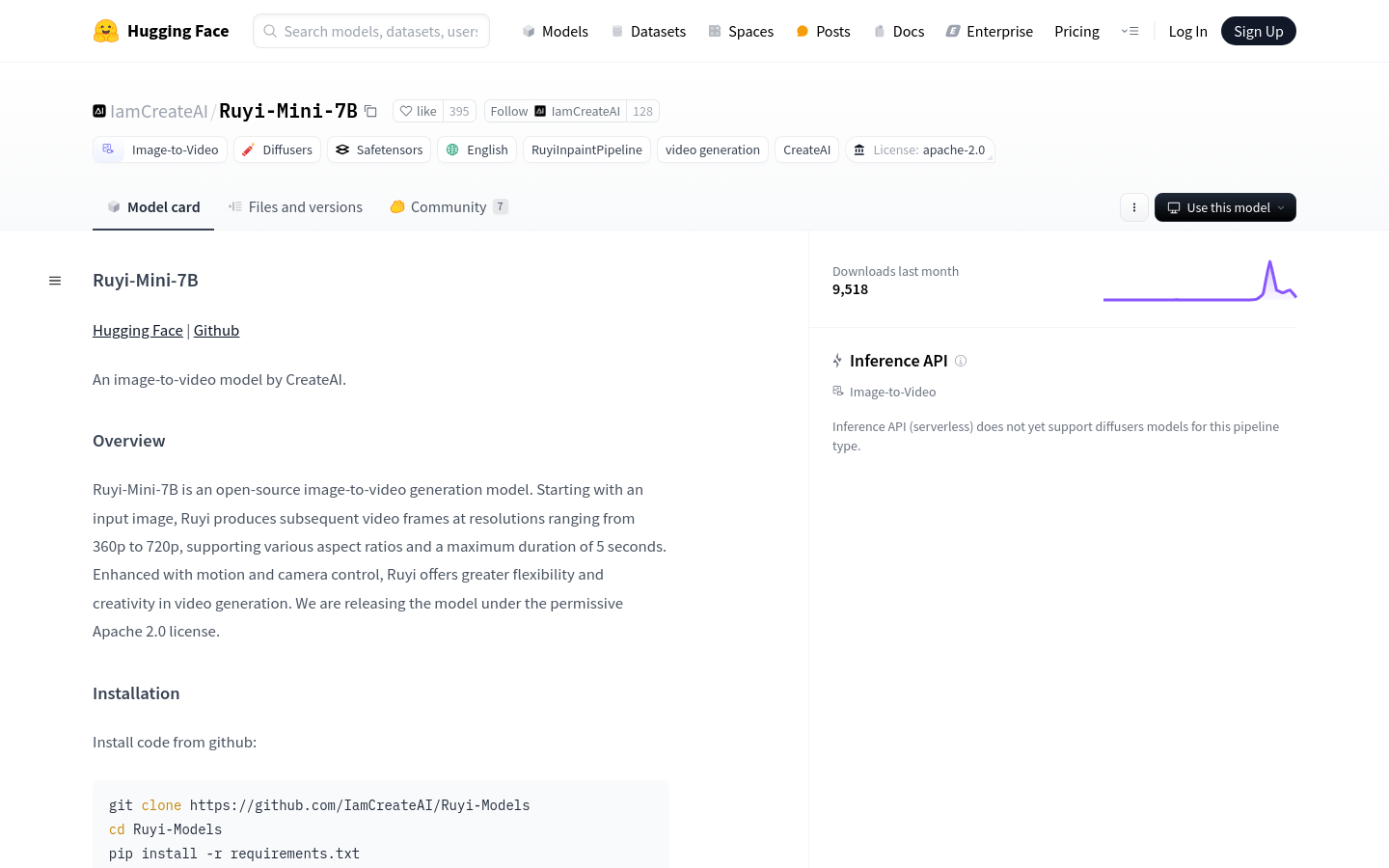

Ruyi-Mini-7B是由CreateAI團隊開發的開源圖像到視頻生成模型,具有約71億參數,能夠從輸入圖像生成360p到720p分辨率的視頻幀,最長5秒。模型支持不同寬高比,並增強了運動和相機控制功能,提供更大的靈活性和創造力。該模型在Apache 2.0許可下發布,意味著用戶可以自由使用和修改。

需求人群:

"目標受眾包括視頻製作者、動畫師、遊戲開發者和研究人員。 Ruyi-Mini-7B適合他們因為它提供了一種創新的方式來從靜態圖像生成動態視頻內容,這可以用於製作動畫、遊戲背景、廣告和其他多媒體內容。"

使用場景示例:

- 視頻製作者使用Ruyi-Mini-7B從靜態圖像生成動畫背景。

- 遊戲開發者利用模型為遊戲角色創建動態背景。

- 廣告製作者使用模型生成吸引人的廣告視頻內容。

產品特色:

- 視頻壓縮與解壓:Casual VAE模塊,將空間分辨率降低到1/8,時間分辨率降低到1/4。

- 3D全注意力視頻數據生成:Diffusion Transformer模塊,使用2D Normalized-RoPE處理空間維度,Sin-cos位置嵌入處理時間維度,DDPM模型訓練。

- 語義特徵提取:利用CLIP模型從輸入圖像中提取語義特徵,引導整個視頻生成過程。

- 多分辨率支持:模型能夠處理從360p到720p不同分辨率的視頻生成。

- 運動和相機控制:增強視頻生成的靈活性和創造力。

- 開源許可:Apache 2.0許可,用戶可以自由使用和修改模型。

- 高效視頻生成:模型能夠快速生成長達5秒的視頻內容。

使用教程:

1. 從GitHub克隆Ruyi-Models代碼庫。

2. 進入Ruyi-Models目錄。

3. 使用pip安裝requirements.txt中列出的依賴。

4. 使用python3 predict_i2v.py運行模型。

5. 或者使用GitHub倉庫中的ComfyUI包裝器運行模型。

6. 輸入圖像並等待模型生成視頻。

7. 根據需要調整運動和相機控制參數以優化視頻效果。

8. 導出生成的視頻內容。