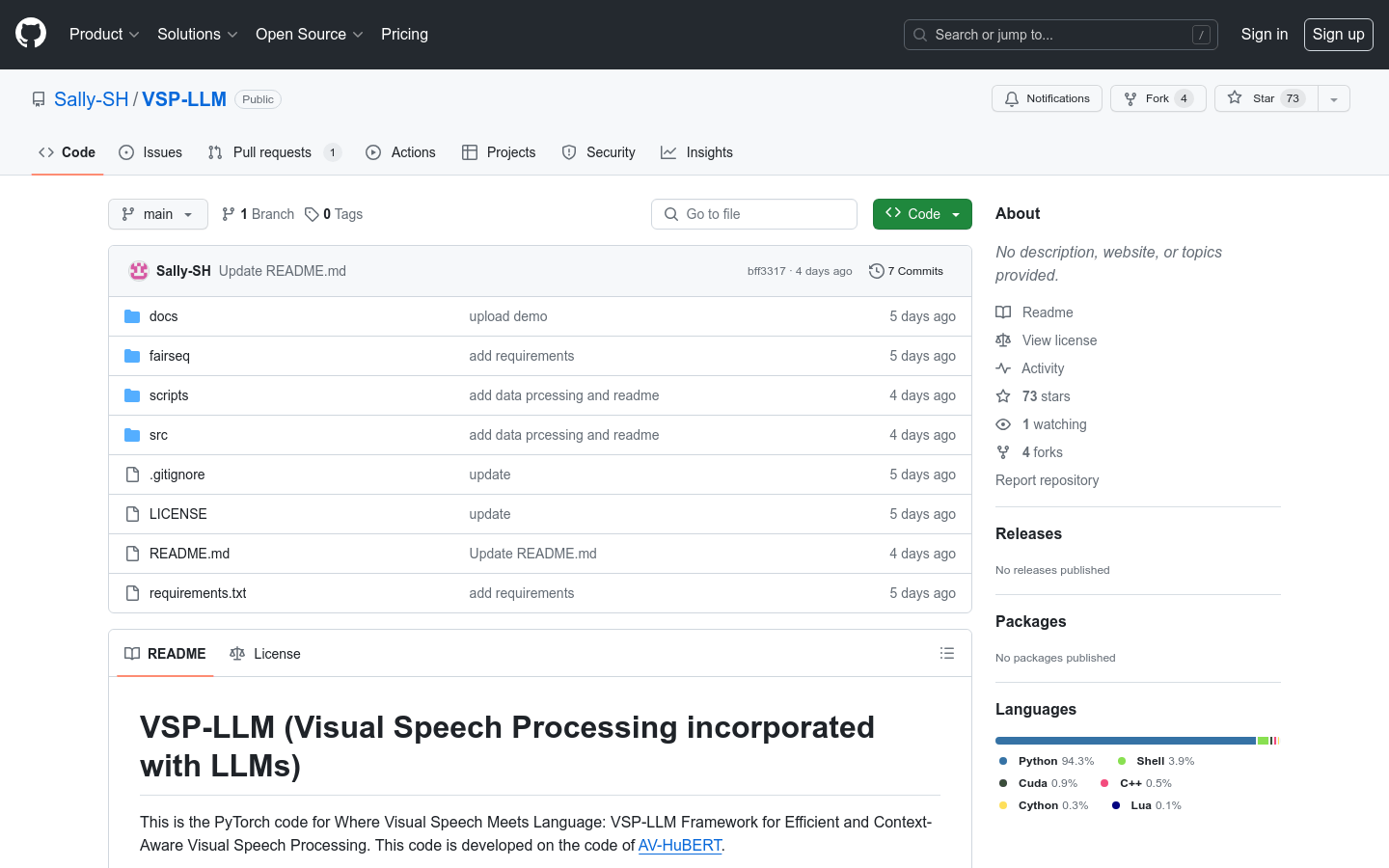

VSP-LLM

結合視覺語音處理與大模型,實現多語言語音識別、跨語言視頻理解,提昇實時翻譯與內容分析效率。

什麼是VSP-LLM ?

VSP-LLM是一個創新的AI 框架,它將視覺語音處理(Visual Speech Processing)與大型語言模型(LLMs)相結合,旨在通過LLMs 的強大能力提升上下文建模效果。簡單來說, VSP-LLM能夠通過分析視頻中的視覺和語音信息,實現多語言語音識別、翻譯以及視頻內容理解等任務。

需求人群:

多語言語音識別:需要準確識別多種語言語音的用戶。

跨語言視頻內容理解:希望從視頻中提取關鍵信息並理解內容的人。

實時語音翻譯:在多語言環境中需要即時翻譯服務的用戶。

使用場景示例:

1. 多語言會議:在跨國會議中,使用VSP-LLM進行實時語音翻譯,確保溝通無障礙。

2. 視頻內容分析:利用VSP-LLM分析視頻,提取關鍵信息並生成簡潔的摘要。

3. 語言學習:在教育場景中,使用VSP-LLM輔助語言學習,提高語音識別的準確性。

產品特色:

視覺語音識別:通過分析視頻中的視覺和語音信息,實現高精度語音識別。

視覺語音翻譯:支持多語言實時翻譯,打破語言障礙。

自監督學習:無需大量標註數據,模型能夠自主學習並優化性能。

高效訓練:採用去重方法和低秩適配器(LoRA),顯著提升訓練效率。

VSP-LLM不僅功能強大,還非常實用,特別適合需要處理多語言語音和視頻內容的用戶。無論是商務會議、教育場景還是日常溝通,它都能提供高效、準確的解決方案。