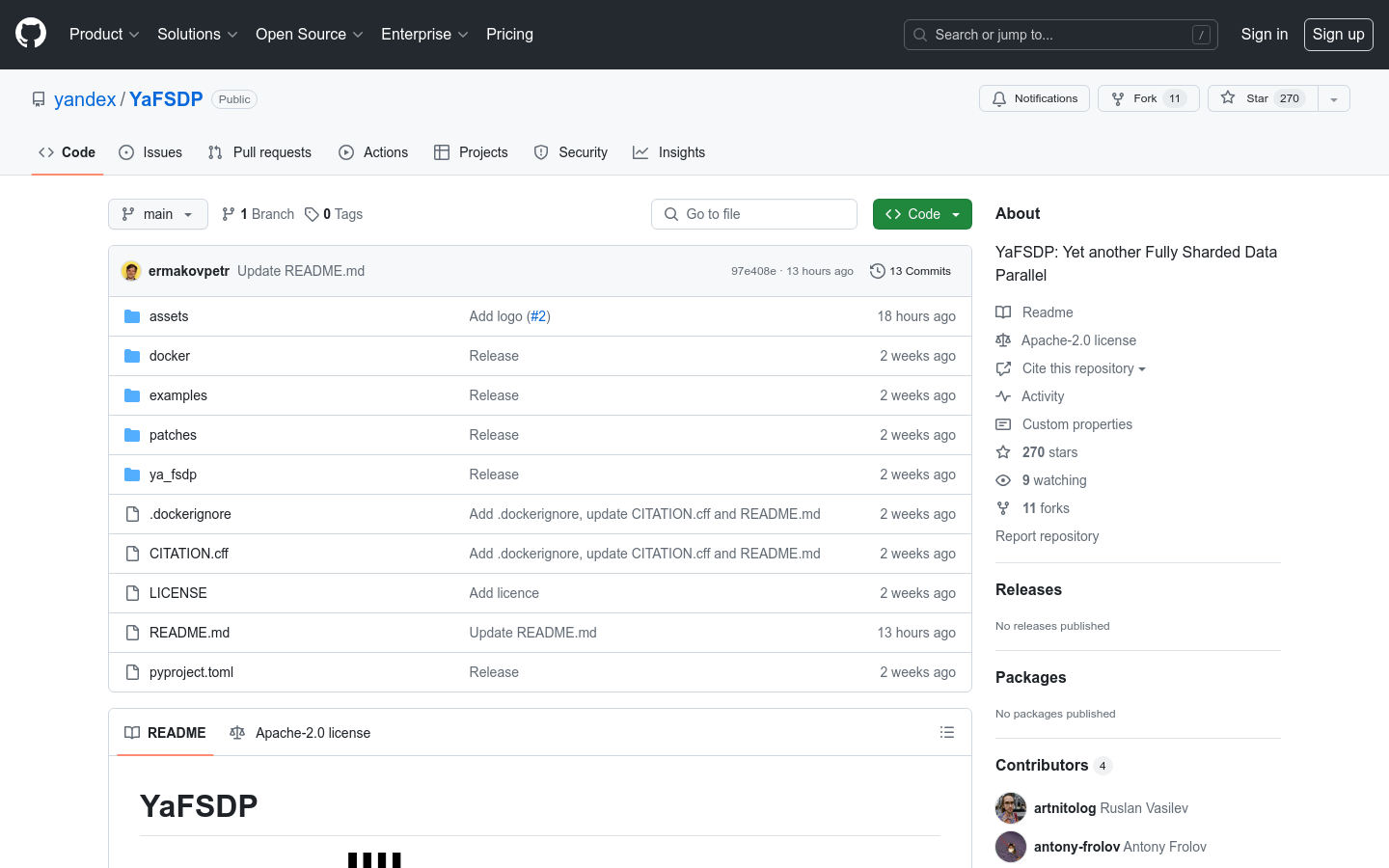

YaFSDP

YaFSDP為尋求高效、可擴展方法來建立和管理高效能網站的開發人員提供強大、易於使用的解決方案。

YaFSDP是一個分散式資料並行框架,專門設計用於與transformer 類神經網路結構良好協作。它在預訓練大型語言模型(LLMs)時比傳統FSDP 快20%,並且在高記憶體壓力條件下表現更佳。

需求人群:

YaFSDP框架適用於需要處理大規模資料和模型的機器學習研究人員和工程師。它特別適合那些需要在高記憶體壓力環境下進行深度學習模型訓練的場景,例如大型語言模型的預訓練和微調。

使用場景範例:

使用YaFSDP進行7B 至70B 參數規模的語言模型預訓練。

在64 至256 個設備上應用YaFSDP進行模型訓練,以提高效率。

利用YaFSDP進行2048 至8192 個token 序列的模型訓練。

產品特色:

支援大規模語言模型的高效預訓練。

優化了記憶體和通訊操作,提高了訓練效率。

提供了詳細的使用範例,包括因果預訓練和監督微調。

基於NVIDIA PyTorch 映像構建,整合了必要的補丁庫。

支援自訂事件通知,便於開發者根據需要接收更新。

在A100 80G 叢集上進行了效能評估,確保了框架的高效能。

使用教學:

1. 複製YaFSDP的GitHub 倉庫到本地環境。

2. 根據範例資料夾中的指導文件設定Docker 環境。

3. 執行docker/build.sh 腳本來建置所需的Docker 映像。

4. 根據特定的訓練需求,選擇合適的範例腳本進行模型訓練。

5. 監控訓練過程中的記憶體和通訊開銷,確保系統穩定運作。

6. 依需求調整YaFSDP的配置參數,優化模型訓練性能。