DeepSeek是最近人工智能領域備受矚目的一個語言模型系列,其在不同版本的發布過程中,逐步加強了對多種任務的處理能力。本文將詳細介紹DeepSeek的各版本,從版本的發佈時間、特點、優勢以及不足之處,為廣大AI技術愛好者和開發者提供一份參考指南。

DeepSeek-V1是DeepSeek的起步版本,這裡不過多贅述,主要分析它的優缺點。

1.發佈時間:

2024年1月

2.特點:

DeepSeek-V1是DeepSeek系列的首個版本,預訓練於2TB的標記數據,主打自然語言處理和編碼任務。它支持多種編程語言,具有強大的編碼能力,適合程序開發人員和技術研究人員使用。

3.優勢:

強大編碼能力:支持多種編程語言,能夠理解和生成代碼,適合開發者進行自動化代碼生成與調試。

高上下文窗口:支持高達128K標記的上下文窗口,能夠處理較為複雜的文本理解和生成任務。

4.缺點:

多模態能力有限:該版本主要集中在文本處理上,缺少對圖像、語音等多模態任務的支持。

推理能力較弱:儘管在自然語言處理和編碼方面表現優異,但在復雜邏輯推理和深層次推理任務中,表現不如後續版本。

作為DeepSeek的早期版本,DeepSeek-V2的性能比DeepSeek-V1提升了太多,其差距和ChatGPT的首個版本和ChatGPT3.5相比一樣。

1.發佈時間:

2024年上半年

2.特點:

DeepSeek-V2系列搭載了2360億個參數,是一個高效且強大的版本。它具有高性能和低訓練成本的特點,支持完全開源和免費商用,極大地促進了AI應用的普及。

3.優勢:

高效的性能與低成本:訓練成本僅為GPT-4-Turbo的1%,大幅降低了開發門檻,適合科研和商業化應用。

開源與免費商用:與前一個版本相比,V2支持完全開源,並且用戶可以自由進行商用,這使得DeepSeek的生態更加開放和多樣化。

4.缺點:

推理速度較慢:儘管參數量龐大,但在推理速度方面,DeepSeek-V2相較於後續版本依然較慢,影響了實時任務的表現。

多模態能力局限:與V1類似,V2版本在處理非文本任務(如圖像、音頻)時的表現並不出色。

1.發佈時間:

2024年9月

下面是官方對於V2.5版本的更新日誌:

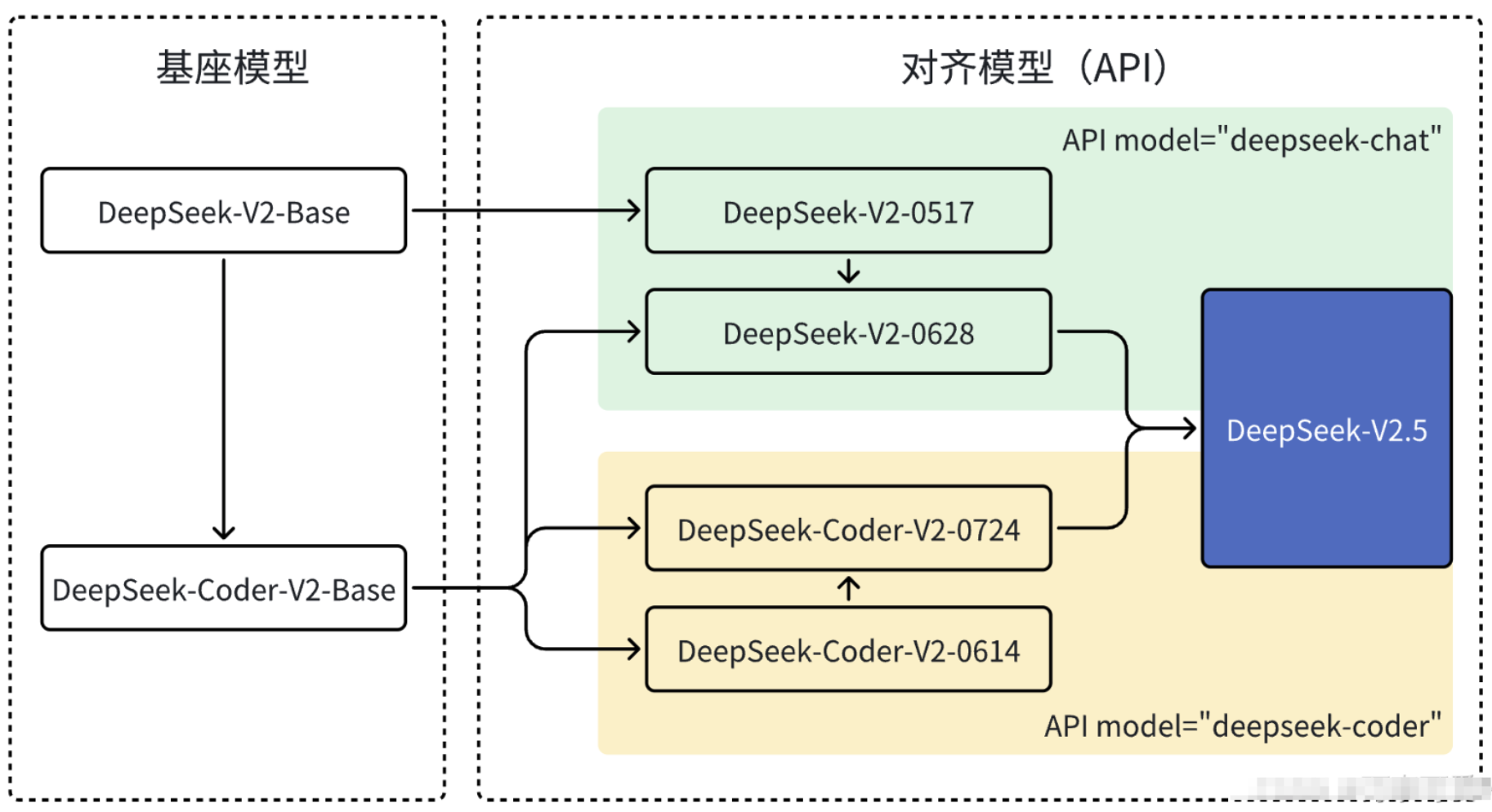

DeepSeek 一直專注於模型的改進和優化。在6 月份,我們對DeepSeek-V2-Chat 進行了重大升級,用Coder V2

的Base 模型替換原有的Chat 的Base 模型,顯著提升了其代碼生成和推理能力,並發布了

DeepSeek-V2-Chat-0628 版本。緊接著,DeepSeek-Coder-V2 在原有Base

模型的基礎上,通過對齊優化,大大提升通用能力後推出了DeepSeek-Coder-V2 0724 版本。最終,我們成功將Chat 和

Coder 兩個模型合併,推出了全新的DeepSeek-V2.5 版本。

可以看出官方在這次更新中融合了Chat和Coder兩個模型,使得DeepSeek-V2.5能夠輔助開發者處理更高難度的任務。

Chat模型:專門為對話系統(聊天機器人)設計和優化,用於生成自然語言對話,能夠理解上下文並生成連貫且有意義的回复,常見應用如聊天機器人、智能助手等。

Coder模型:是一種基於深度學習技術,經過大量代碼數據訓練,能夠理解、生成和處理代碼的人工智能模型。

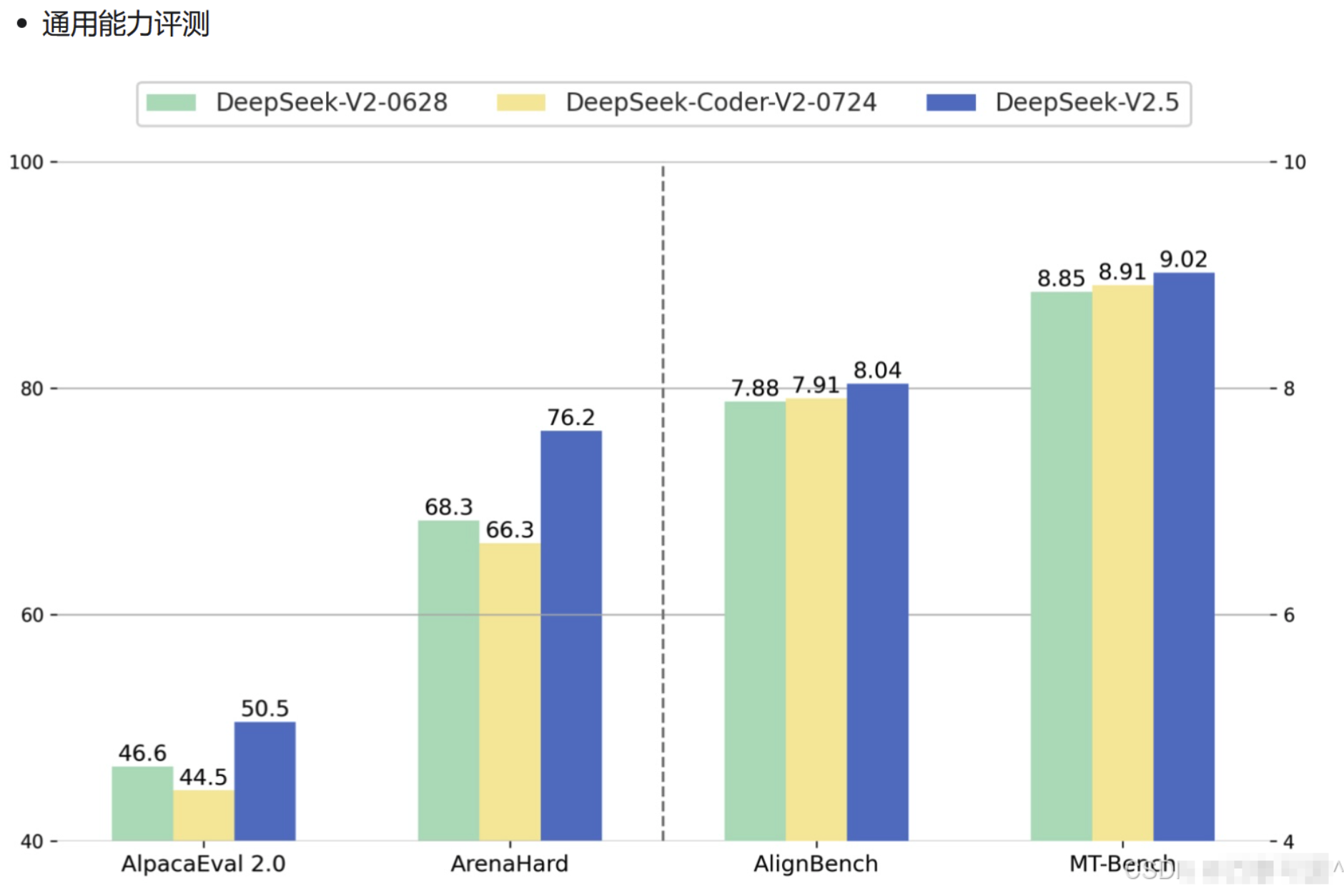

並且從官方發布的數據來看,V2.5在通用能力(創作、問答等)等問題中表現對比V2模型來說,有了顯著得提升。

下面用一張圖來對比一下DeepSeek - V2 和DeepSeek - V2.5 兩個版本模型分別與ChatGPT4o - latest 和ChatGPT4o mini的通用能力對比測試。

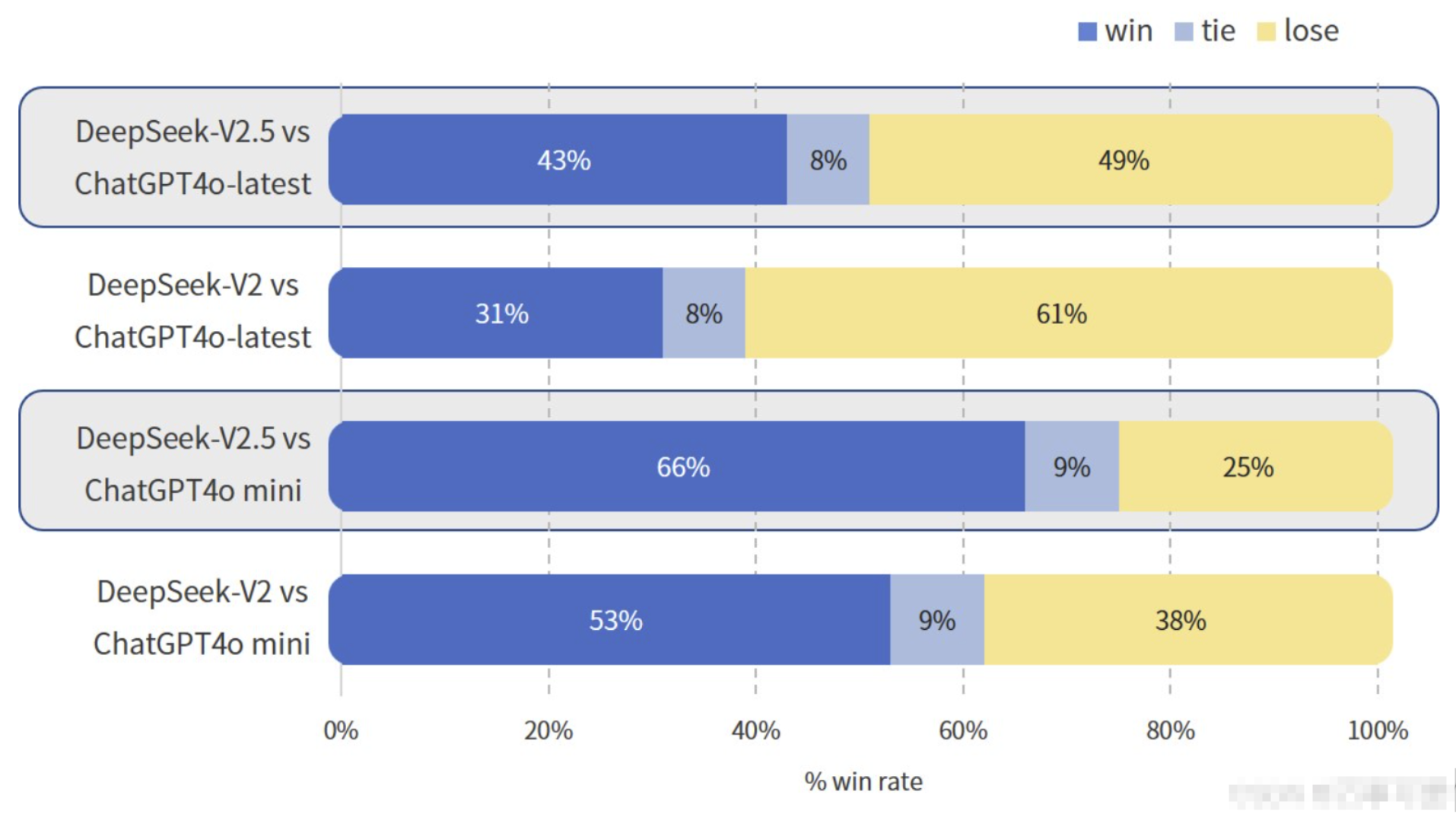

在這張圖中我們可以看出DeepSeek - V2和DeepSeek - V2.5兩個版本模型分別與ChatGPT4o - latest和ChatGPT4o mini進行對比測試的勝率、平局率和敗率情況:

DeepSeek - V2.5 vs ChatGPT4o - latest:DeepSeek - V2.5的勝率為43%,平局率為8%,敗率為49% 。

DeepSeek - V2 vs ChatGPT4o - latest:DeepSeek - V2的勝率為31%,平局率為8%,敗率為61% 。

DeepSeek - V2.5 vs ChatGPT4o mini:DeepSeek - V2.5的勝率為66%,平局率為9%,敗率為25% 。

DeepSeek - V2 vs ChatGPT4o mini:DeepSeek - V2的勝率為53%,平局率為9%,敗率為38% 。

在與ChatGPT4o系列模型的對比中,DeepSeek - V2.5整體表現優於DeepSeek - V2;DeepSeek - V2.5和DeepSeek - V2在與ChatGPT4o mini的對比中勝率相對較高,而與ChatGPT4o - latest對比時勝率相對較低。

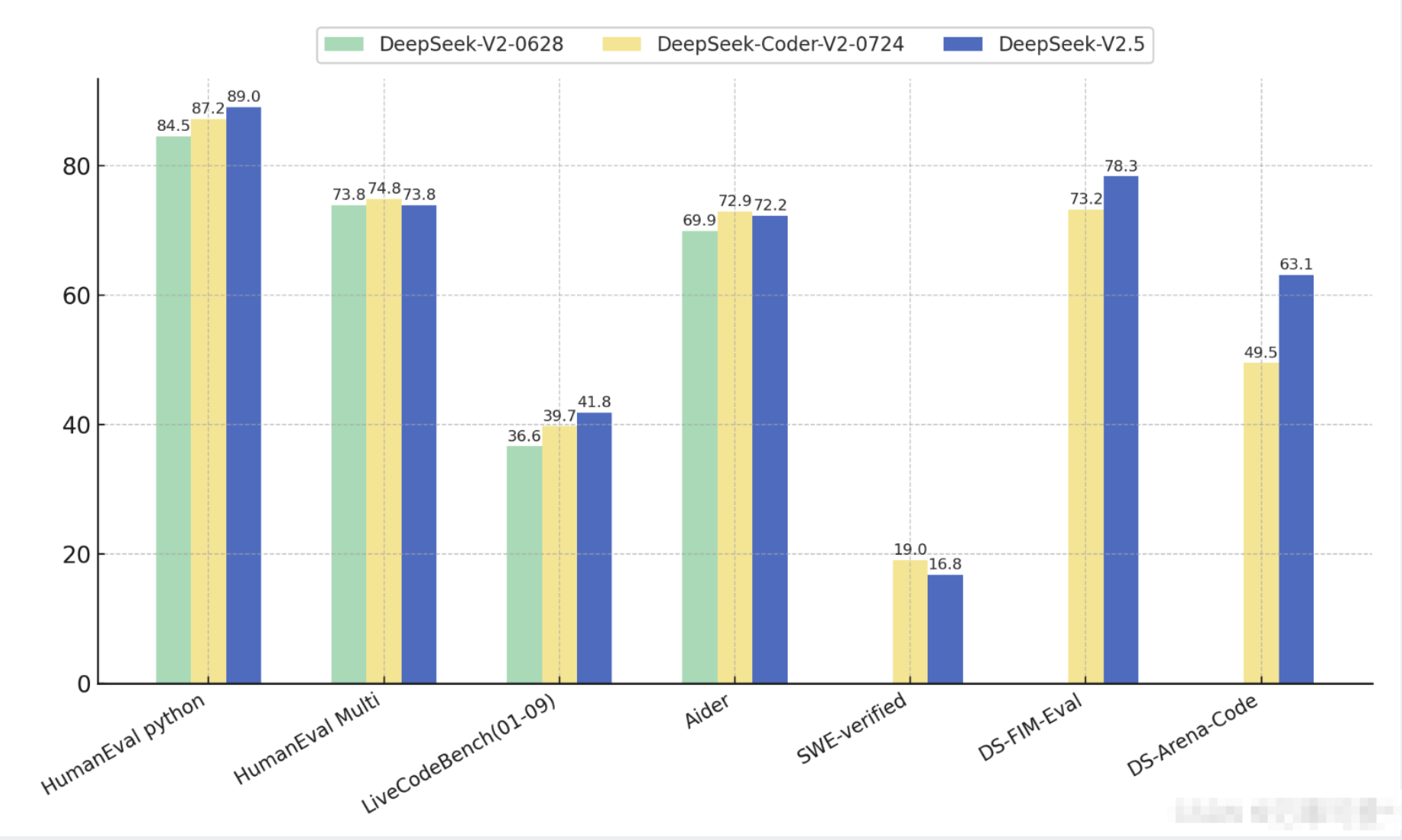

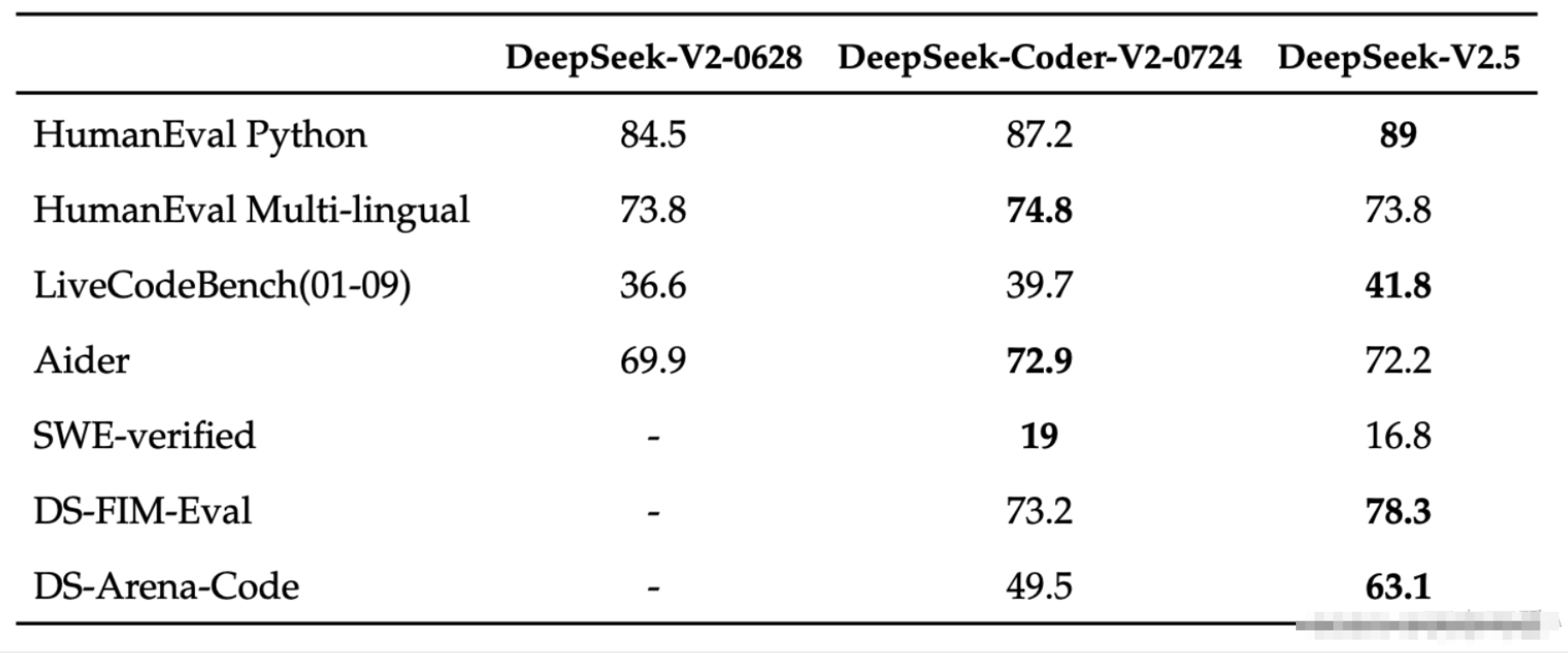

在代碼方面,DeepSeek-V2.5 保留了DeepSeek-Coder-V2-0724 強大的代碼能力。在HumanEval

Python 和LiveCodeBench(2024 年1 月- 2024 年9 月)測試中,DeepSeek-V2.5

顯示了較為顯著的改進。在HumanEval Multilingual 和Aider 測試中,DeepSeek-Coder-V2-0724

略勝一籌。在SWE-verified

測試中,兩個版本的表現都較低,表明在此方面仍需進一步優化。另外,在FIM補全任務上,內部評測集DS-FIM-Eval的評分提升了

5.1%,可以帶來更好的插件補全體驗。

另外,DeepSeek-V2.5對代碼常見場景進行了優化,以提昇實際使用的表現。在內部的主觀評測DS-Arena-Code

中,DeepSeek-V2.5 對戰競品的勝率(GPT-4o 為裁判)取得了顯著提升。

2.特點:

DeepSeek-V2.5在前一個版本的基礎上進行了一些關鍵性改進,尤其是在數學推理和寫作領域,表現得更加優異。同時,該版本加入了聯網搜索功能,能夠實時分析海量網頁信息,增強了模型的實時性和數據豐富度。

3.優勢:

數學和寫作能力提升:在復雜的數學問題和創作寫作方面,DeepSeek-V2.5表現優異,能夠輔助開發者處理更高難度的任務。

聯網搜索功能:通過聯網,模型可以抓取最新的網頁信息,對當前互聯網資源進行分析和理解,提升模型的實時性和信息廣度。

4.缺點:

API限制:雖然具備聯網搜索能力,但API接口不支持該功能,影響了一些用戶的實際應用場景。

多模態能力依然有限:儘管在多方面有所改進,但V2.5在多模態任務上仍然存在局限性,無法與專門的多模態模型媲美。

DeepSeek-V2.5 現已開源到了HuggingFace:

https://huggingface.co/deepseek-ai/DeepSeek-V2.5

1.發佈時間:

2024年11月20日

不得不說DeepSeek版本的迭代速度很快,同年11月劃歷史意義的R1-Lite模型發布。作為R1模型的前置版本,雖然沒有R1模型那樣備受矚目,但是其作為對標OpenAI o1的國產推理模型,表現也是可圈可點的,DeepSeek-R1-Lite 預覽版模型在美國數學競賽(AMC)中難度等級最高的AIME 以及全球頂級編程競賽(codeforces)等權威評測中,均取得了卓越的成績,大幅超越了GPT-4o 等知名模型。

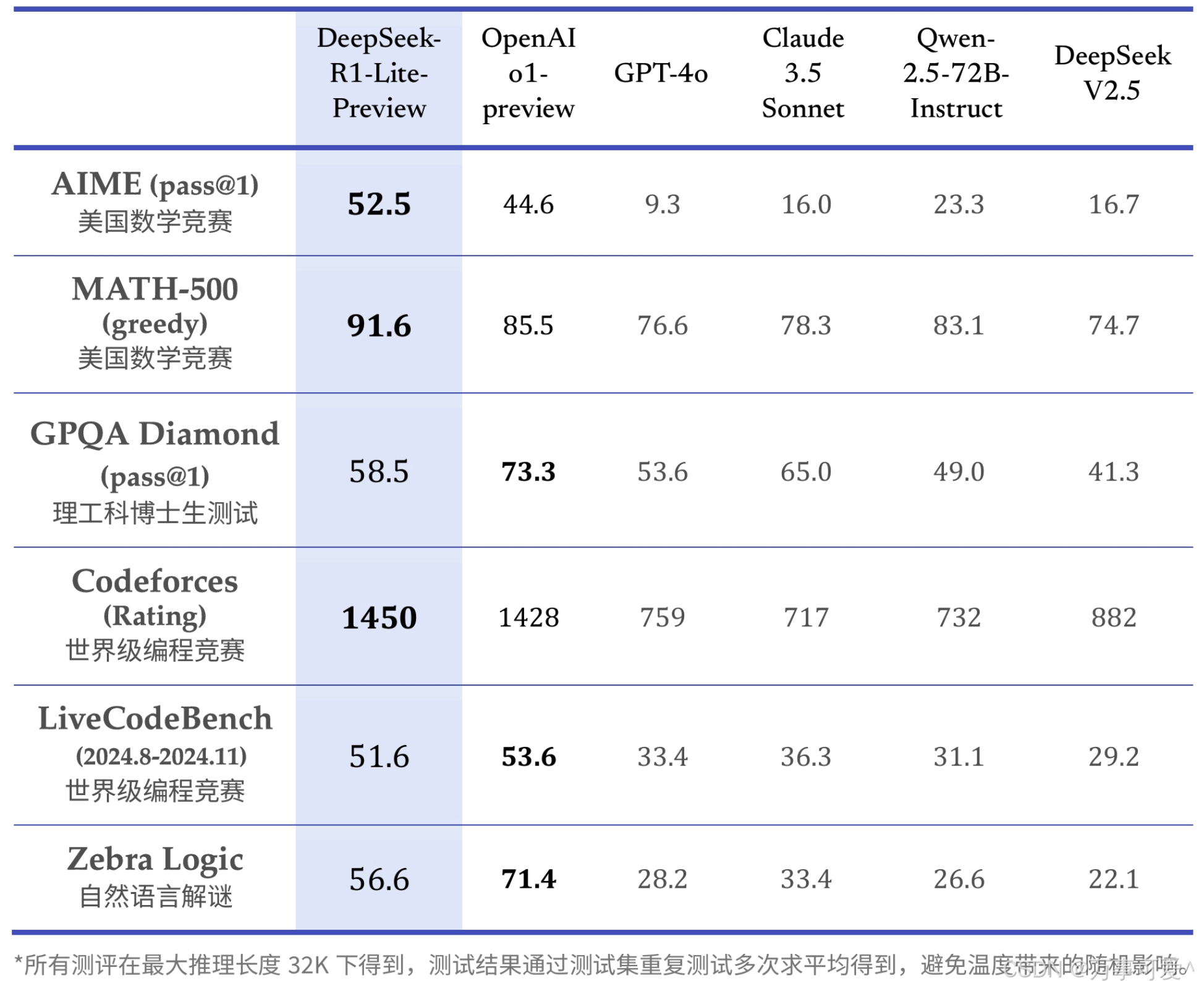

下表為DeepSeek-R1-Lite 在各項相關評測中的得分結果:

DeepSeek - R1 - Lite - Preview 在數學競賽(AIME、MATH - 500)和世界級編程競賽(Codeforces)的測試任務中表現突出,在理工科博士生測試、另一世界級編程競賽和自然語言解謎任務中也有不錯表現,但在理工科博士生測試、自然語言解謎等任務中,OpenAI o1 - preview 得分更優,這也是DeepSeek - R1 - Lite沒有得到太多關注的原因。

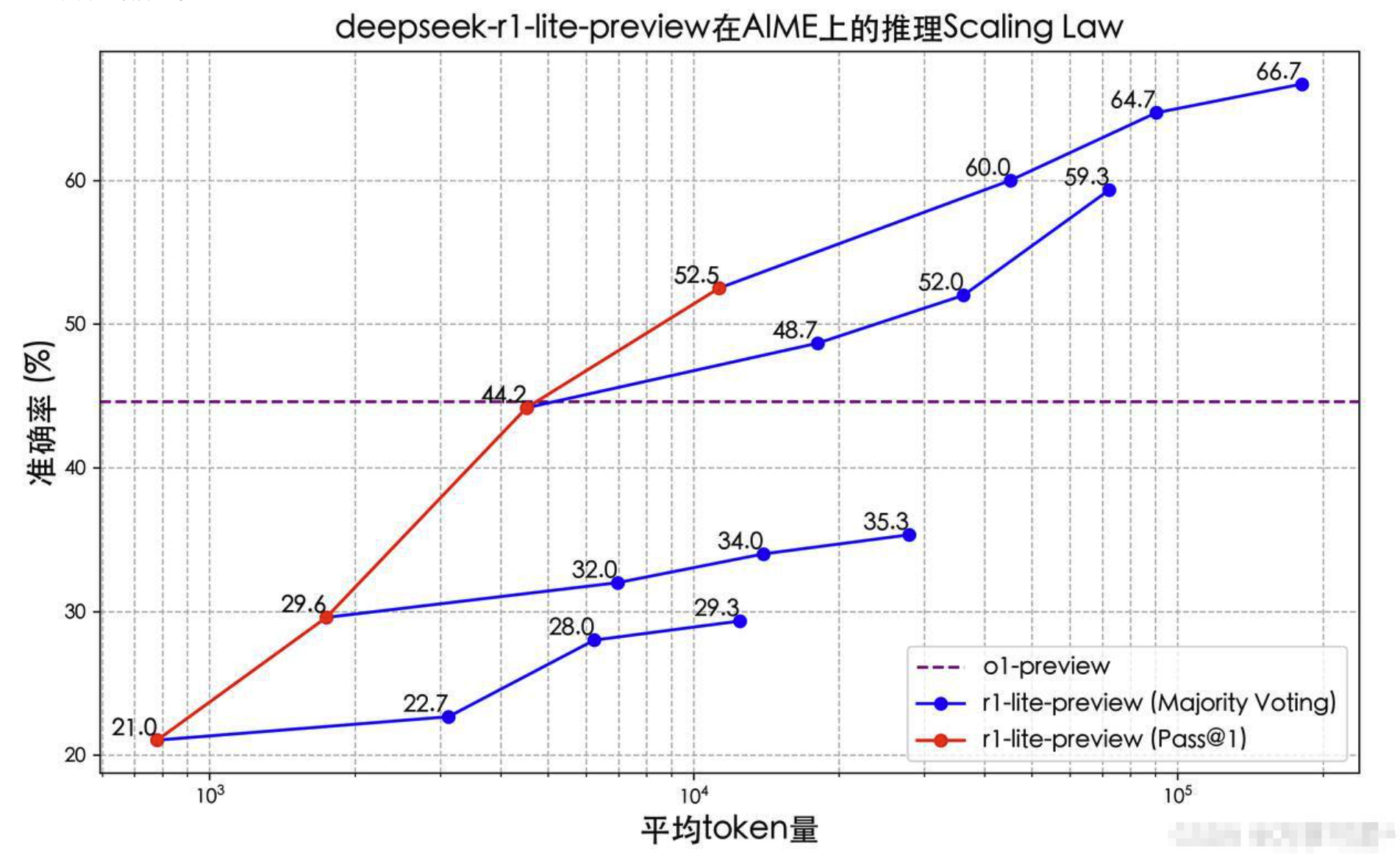

根據官網消息,DeepSeek-R1-Lite 的推理過程長,並且包含了大量的反思和驗證。下圖展示了模型在數學競賽上的得分與測試所允許思考的長度緊密相關。

由上圖可以看出:

DeepSeek - R1 - Lite - Preview 的準確率隨著平均token

量的增加而顯著提升,在採用多數投票法時,提升效果更為明顯,最終超過OpenAI o1 - preview 的表現。

在一次通過(Pass@1)情況下,DeepSeek - R1 - Lite - Preview 在平均token量達到一定程度時,準確率也高於OpenAI o1 - preview 的44.2% 。

2.特點

使用強化學習訓練,推理過程包含大量反思和驗證,思維鍊長度可達數万字,在數學和編程等需要長邏輯鏈條的任務中具備優勢;在數學、代碼以及各種複雜邏輯推理任務上,取得了媲美o1的推理效果,並展現了o1未公開的完整思考過程,目前在DeepSeek官網上免費可用。

3.優點

推理能力強:在一些高難度的數學和代碼任務中表現優異,在美國數學競賽(AMC)和全球編程競賽(codeforces)等測試中,超越了現有的頂級模型,甚至在某些任務上超過了OpenAI的o1 。例如在密碼解密測試中,成功破解了一個依賴複雜邏輯的密碼,而o1 - preview則未能正確解答。

思考過程詳細:在答題時不僅提供答案,還會附上詳細的思考過程和反向思考的驗證過程,顯示出邏輯推理的嚴謹性。

性價比高:所屬公司DeepSeek產品以開源為主,其模型訓練成本遠低於行業主流模型,性價比具有顯著優勢。

4.缺點

代碼生成表現不穩定:在生成一些相對簡單的代碼時表現不如預期。

知識引用能力不足:在處理一些需要現代知識引用的複雜測試時,未能達到令人滿意的效果。

語言交互問題:使用過程中可能出現中英文思考、輸出混亂的問題。

1.發佈時間:

2024年12月26日

作為深度求索公司自主研發的首款混合專家(MoE)模型,其擁有6710億參數,激活370億,在14.8萬億token上完成了預訓練。

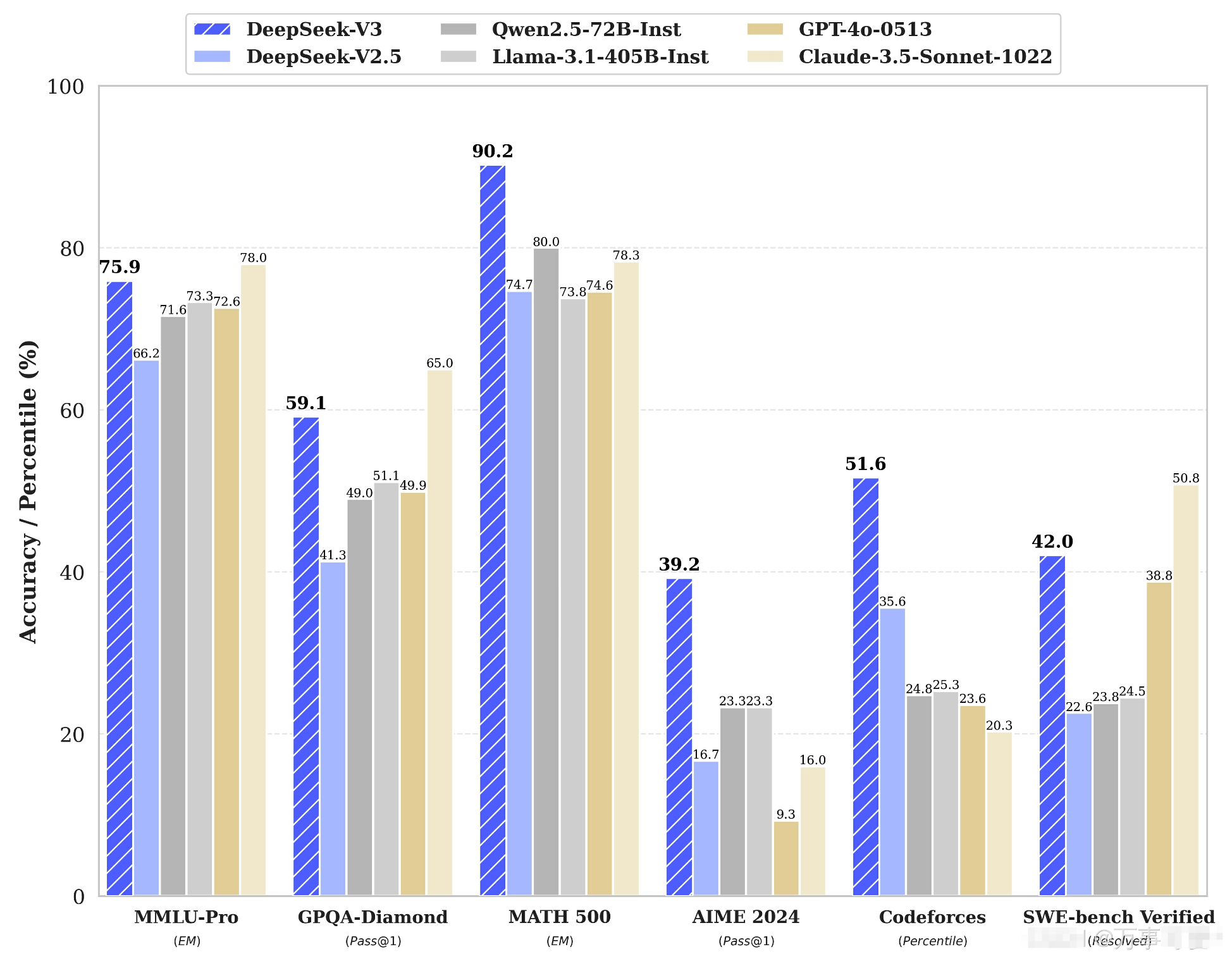

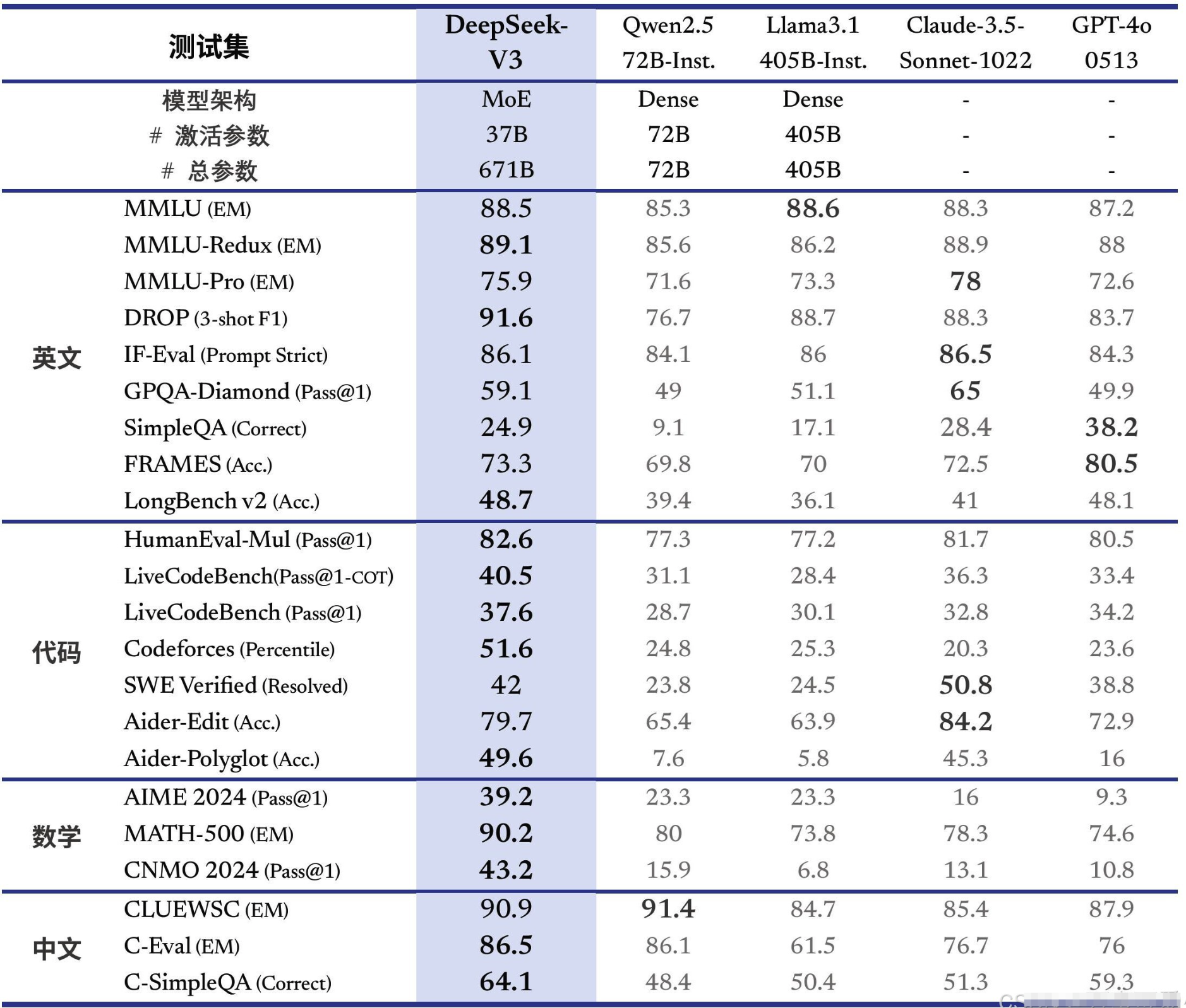

DeepSeek-V3 多項評測成績超越了Qwen2.5-72B 和Llama-3.1-405B 等其他開源模型,並在性能上和世界頂尖的閉源模型GPT-4o 以及Claude-3.5-Sonnet 不分伯仲。

DeepSeek - V3 在MMLU - Pro、MATH 500、Codeforces 任務測試中表現突出,準確率領先;在GPQA Diamond、SWE - bench Verified 任務中也有不錯表現,但在AIME 2024 任務中,GPT - 4o - 0513 準確率更優。

由上面表格可以看出,這項對比涉及DeepSeek - V3、Qwen2.5 - 72B - Inst、Llama3.1 - 405B - Inst、Claude - 3.5 - Sonnet - 1022、GPT - 4o - 0513等模型,從模型架構、參數及各測試集表現等方面分析得出:

模型架構與參數

DeepSeek - V3:採用MoE架構,激活參數37B,總參數671B。

Qwen2.5 - 72B - Inst:Dense架構,激活參數72B,總參數72B。

Llama3.1 - 405B - Inst:Dense架構,激活參數405B,總參數405B。

其他兩個模型未公開當前信息。

英文測試集表現

MMLU相關:DeepSeek - V3在MMLU - EM、MMLU - Redux EM、MMLUPro - EM測試中,成績分別為88.5、89.1、75.9 ,在部分測試中與其他模型表現接近。

DROP:DeepSeek - V3得分為91.6,領先於其他模型。

IF - Eval:DeepSeek - V3為86.1,和其他模型成績相當。

GPQA - Diamond:DeepSeek - V3得分59.1,僅次於Claude - 3.5 - Sonnet - 1022的65。

SimpleQA等:在SimpleQA、FRAMES、LongBench v2等測試中,DeepSeek - V3表現有差異,如SimpleQA得分為24.9,FRAMES為73.3 。

代碼測試集表現

HumanEval - Mul:DeepSeek - V3得分為82.6,表現較好。

LiveCodeBench:在LiveCodeBench (Pass@1 - COT)和LiveCodeBench (Pass@1)測試中,DeepSeek - V3分別為40.5、37.6 。

Codeforces等:在Codeforces Percentile測試中DeepSeek - V3得分為51.6,在SWE - bench Verified (Resolved)中得分為42 。

數學測試集表現

AIME 2024:DeepSeek - V3得分為39.2,高於Qwen2.5 - 72B - Inst、Llama3.1 - 405B - Inst、Claude - 3.5 - Sonnet - 1022 。

MATH - 500:DeepSeek - V3得分為90.2,優勢明顯。

中文測試集表現

CLUEWSC:DeepSeek - V3得分為90.9,和其他模型成績接近。

C - Eval等:在C - Eval、C - SimpleQA測試中,DeepSeek - V3分別為86.5、64.1 。

總體來看,DeepSeek - V3在多個測試集上有不錯表現,在DROP、MATH - 500等測試中優勢明顯,在不同語言和領域的測試集中各模型有不同程度的優勢與不足。

2.特點:

DeepSeek-V3是該系列中的一個里程碑版本,擁有6710億參數,專注於知識類任務和數學推理,性能大幅度提升。 V3引入了原生FP8權重,支持本地部署,並且推理速度大幅提升,生成吐字速度從20TPS提升至60TPS,適應了大規模應用的需求。

3.優勢:

強大的推理能力:憑藉6710億參數,DeepSeek-V3在知識推理和數學任務方面展現出卓越的表現。

高生成速度:每秒生成60個字符(TPS)的速度使得V3能夠滿足對響應速度要求高的應用場景。

本地部署支持:通過FP8權重的開源,用戶可以在本地部署,降低對雲服務的依賴,提升數據隱私性。

4.缺點:

高訓練資源需求:雖然推理能力大幅提升,但V3需要大量的GPU資源進行訓練,這使得其部署和訓練的成本較高。

多模態能力不強:和前面版本一樣,V3在多模態任務(如圖像理解)方面未做專門優化,仍有一定的短板。

下面附上V3模型的論文鏈接,供大家參考學習。

論文鏈接:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

1.發佈時間:

2025年1月20日

作為一經發布就備受矚目的DeepSeek-R1來說,真正的是經歷了很多磨難才誕生走到現在,而DeepSeek-R1發布以來就秉持這開源的原則,遵循MIT License,允許用戶通過蒸餾技術借助R1 訓練其他模型。

這將有一下兩方面的影響:

開源協議層面

MIT License是一種寬鬆的開源軟件許可協議。這意味著DeepSeek - R1以非常開放的姿態面向廣大開發者和用戶。在遵循MIT License相關規定的前提下,用戶擁有極大的自由:

使用自由:可以在任何個人項目、商業項目等各種場景中自由使用DeepSeek - R1模型,無需擔心因使用場景而產生的法律問題。

修改自由:能夠對DeepSeek - R1的代碼、模型架構等進行修改和定制,以滿足特定的業務需求或研究目的。

分發自由:可以將基於DeepSeek - R1修改或未修改的版本進行分發,無論是免費分發還是伴隨商業產品一起分發都是被允許的。

模型訓練與技術應用層面

允許用戶通過蒸餾技術借助R1訓練其他模型,這具有很高的技術價值和應用潛力:

模型輕量化:蒸餾技術可以將大型的DeepSeek - R1模型的知識遷移到小型模型上。開發者能夠訓練出更輕量級、運行效率更高的模型,比如在資源受限的設備(如移動設備、嵌入式設備等)上部署模型,以實現實時的推理和應用,而無需依賴強大的計算資源來運行大型的DeepSeek - R1原模型。

個性化定制:用戶可以根據自身特定的任務需求,比如特定領域的文本分類、特定類型的圖像識別等,以DeepSeek - R1為基礎,通過蒸餾訓練出更適配該任務的模型,從而在性能和資源消耗之間取得更好的平衡,提升模型在特定場景下的表現。

促進技術創新:這種方式為研究人員和開發者提供了一個強大的工具和起點,鼓勵更多人基於DeepSeek - R1進行探索和創新,加速人工智能技術在各個領域的應用和發展,推動整個行業的技術進步。

並且DeepSeek-R1 上線API,對用戶開放思維鏈輸出,通過設置model='deepseek-reasoner' 即可調用,這無疑極大的方便了很多對於大模型感興趣的個體用戶。

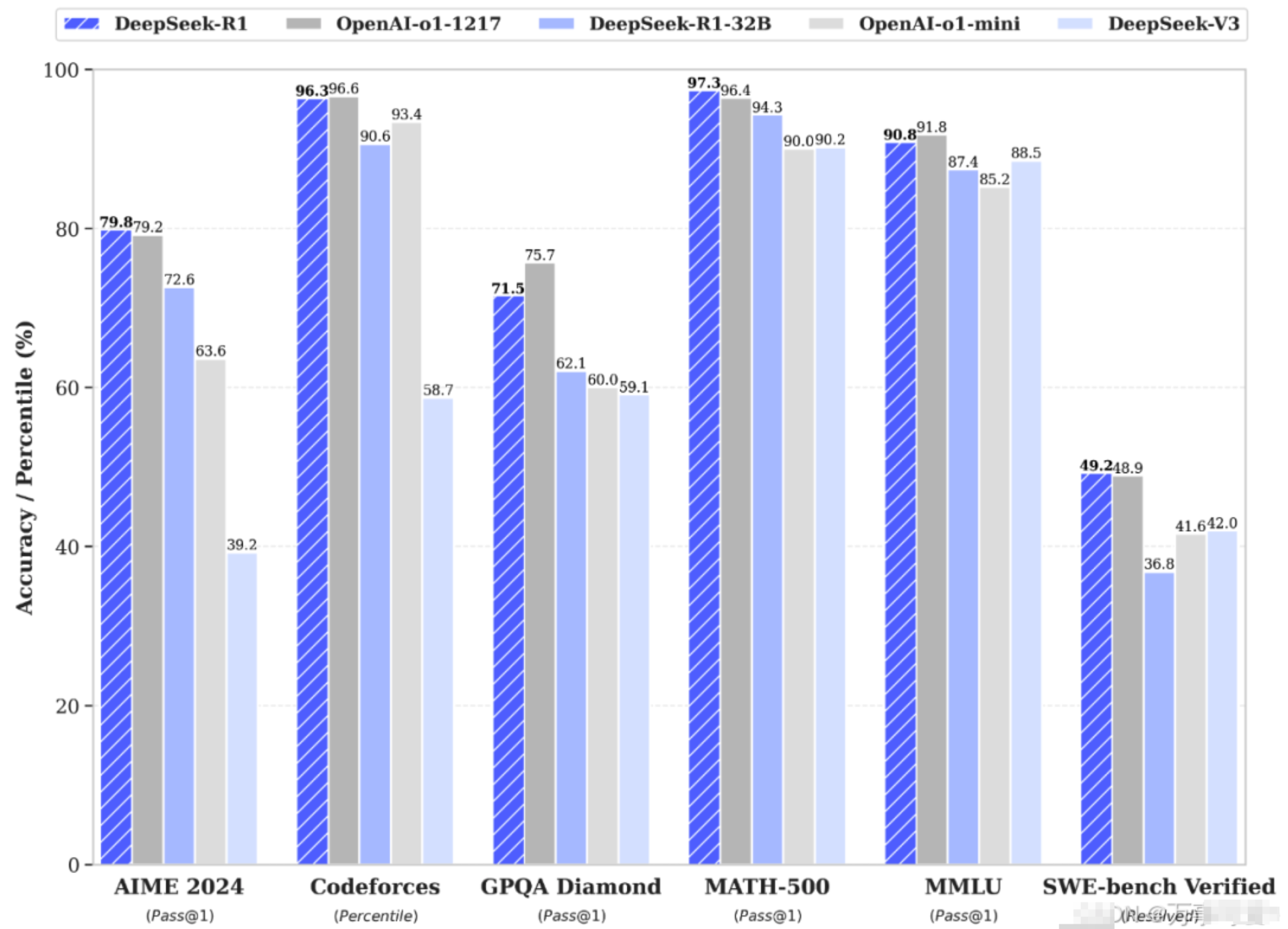

據官網信息透漏,DeepSeek-R1 在後訓練階段大規模使用了強化學習技術,在僅有極少標註數據的情況下,極大提升了模型推理能力。在數學、代碼、自然語言推理等任務上,性能比肩OpenAI o1 正式版。

從上圖可以看出,在Codeforces、MATH - 500、SWE - bench Verified 測試中,DeepSeek - R1 或DeepSeek - R1 - 32B 表現突出;在AIME 2024、GPQA Diamond、MMLU 測試中,OpenAI - o1 - 1217 表現較好。

但是在蒸餾小模型的對比上,R1模型超越OpenAI o1-mini。

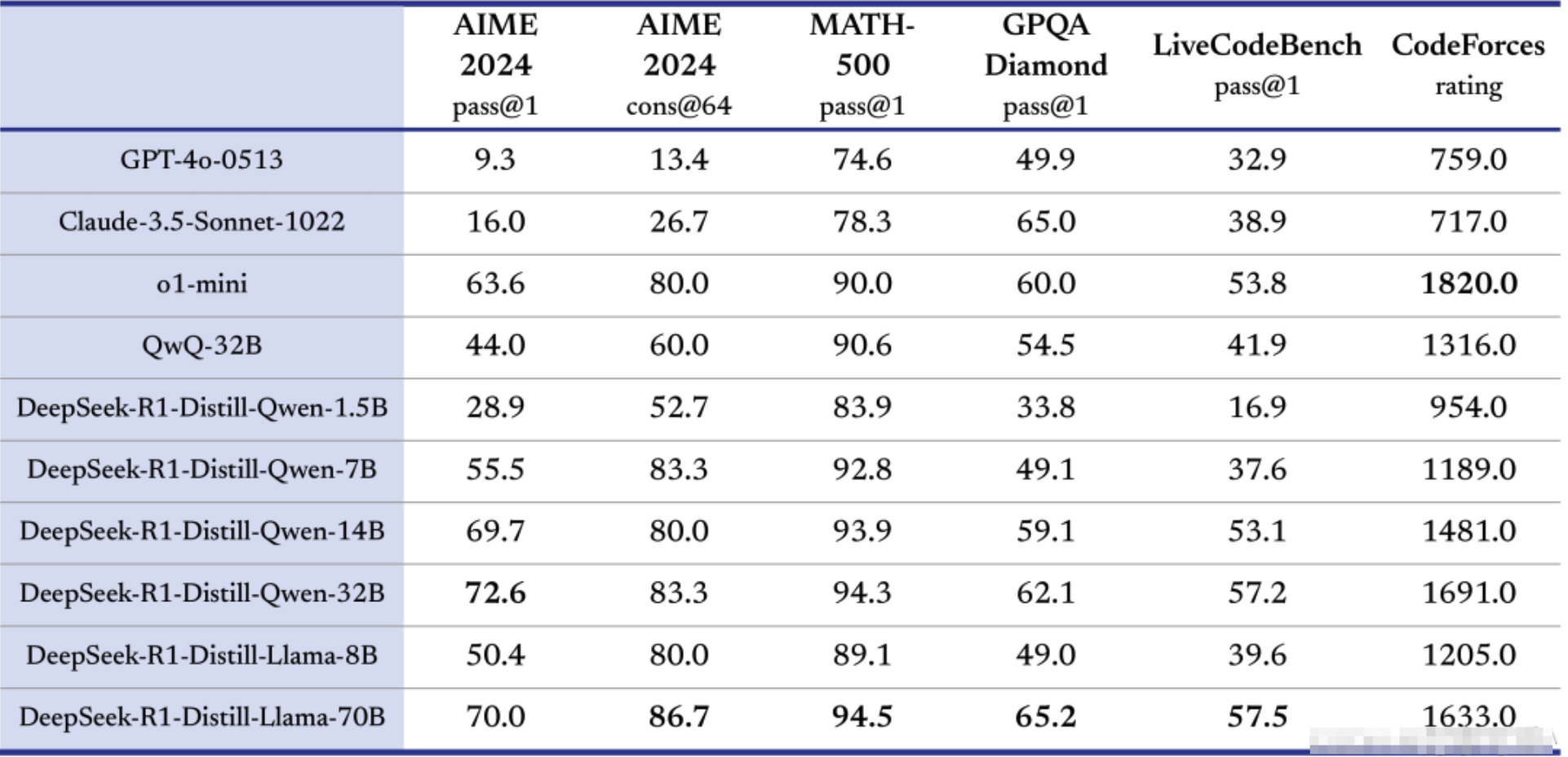

在官方在開源的數據中DeepSeek-R1-Zero 和DeepSeek-R1 兩個660B 模型的同時,通過DeepSeek-R1 的輸出,蒸餾了6 個小模型開源給社區,其中32B 和70B 模型在多項能力上實現了對標OpenAI o1-mini 的效果。

上表為對比不同模型在多項測試集上表現的表格,測試集包括AIME 2024、MATH - 500等,模型有GPT - 4o - 0513、Claude - 3.5 - Sonnet - 1022等,還涉及基於DeepSeek - R1蒸餾的系列模型,具體詳情如下的分析:

模型及表現

GPT - 4o - 0513:在各測試集得分相對均衡,如在AIME 2024 pass@1得分為9.3 ,在CodeForces rating為759.0 。

Claude - 3.5 - Sonnet - 1022:在各測試表現較穩定,如AIME 2024 pass@1得16.0,CodeForces rating為717.0 。

o1 - mini:在多個測試集表現突出,尤其在CodeForces rating達到1820.0 。

QwQ - 32B:在不同測試集有一定表現,如MATH - 500 pass@1得90.6 。

DeepSeek - R1 - Distill - Qwen系列:隨著參數增大(從1.5B到32B),在多數測試集成績總體提升,如DeepSeek - R1 - Distill - Qwen - 32B在MATH - 500 pass@1得94.3,超過DeepSeek - R1 - Distill - Qwen - 1.5B的83.9 。

DeepSeek - R1 - Distill - Llama系列:在多項測試表現不錯,DeepSeek - R1 - Distill - Llama - 70B在MATH - 500 pass@1得94.5 。

總結

從表格看,o1 - mini在CodeForces競賽評分上優勢明顯;DeepSeek - R1蒸餾的大參數模型(如DeepSeek - R1 - Distill - Qwen - 32B、DeepSeek - R1 - Distill - Llama - 70B)在數學和編程相關測試集表現較好,反映出DeepSeek - R1蒸餾技術對模型性能有提升作用,不同模型在各測試集有不同優勢。

2.特點:

DeepSeek-R1是系列中的最新版本,通過強化學習(RL)技術,優化了模型的推理能力。 R1版本推理能力接近OpenAI的O1,並且遵循MIT許可證,支持模型蒸餾,進一步促進開源生態的健康發展。

3.優勢:

強化學習優化推理能力:利用強化學習技術,R1能夠在推理任務中展現出比其他版本更強的表現。

開源支持與科研應用:R1完全開源,支持科研人員、技術開發者進行二次開發,推動AI技術的快速進步。

4.缺點:

多模態能力不足:儘管在推理能力上有顯著提升,但在多模態任務的支持方面仍未得到充分優化。

應用場景受限:R1主要面向科研、技術開發和教育領域,其在商業化應用和實際操作中的適用場景相對較窄。

DeepSeek系列的不斷迭代和升級,體現了其在自然語言處理、推理能力和應用生態等方面的持續進步。每個版本都有其獨特的優勢和適用場景,用戶可以根據自身需求選擇最適合的版本。隨著技術的不斷發展,未來DeepSeek可能會在多模態支持、推理能力等方面繼續取得突破,值得期待。