你們有沒有覺得,辛辛苦苦用海量數據餵養出來的圖像模型,在生成高質量圖片時,總像蝸牛爬樹般慢吞吞?別急,Luma AI 最近開源了一項名為Inductive Moment Matching (IMM)的圖像模型預訓練技術,據說能讓模型以前所未有的“閃電”速度生成高質量圖像,簡直是煉丹爐裡的渦輪增壓!

近年來,AI 社區普遍感受到,生成式預訓練似乎遇到了瓶頸。儘管數據量持續攀升,但算法創新卻相對停滯。 Luma AI 認為,這並非數據不夠,而是算法沒能充分挖掘數據的潛力,這如同手握金礦卻只會用鋤頭挖土,效率實在堪憂。

為了打破這個“算法天花板”,Luma AI 將目光投向了高效的推理時計算擴展。他們認為,與其在模型容量上“內捲”,不如想想如何在推理階段提速。於是,IMM 這位“速度型選手”應運而生!

那麼,IMM 這項技術究竟有何獨到之處,能實現如此驚人的提速呢?

關鍵在於它從推理效率的角度反向設計預訓練算法。傳統的擴散模型,就像精雕細琢的藝術家,需要一步一個腳印地進行精細的調整,即使模型再強大,也需要大量的步驟才能得到最佳結果。而IMM 則不同,它好比一個擁有“瞬間移動”技能的畫師,在推理過程中,網絡不僅關注當前的時間步,還會考慮“目標時間步” 。

你可以想像一下,傳統的擴散模型在生成圖像時,就像在迷宮裡一步步摸索前進。而IMM 呢?它直接看到了迷宮的出口,能夠更靈活地“跳躍”過去,大大減少了所需的步驟。這種巧妙的設計,讓每一次迭代都更具表達能力,不再被線性插值所限制。

更令人稱讚的是,IMM 還引入了最大平均差異(maximum mean discrepancy)這種成熟的矩匹配技術,這就像給“跳躍”增加了一個精準的導航系統,確保模型能夠準確地朝著高質量的目標前進。

實踐是檢驗真理的唯一標準。 Luma AI 用一系列實驗證明了IMM 的強大實力:

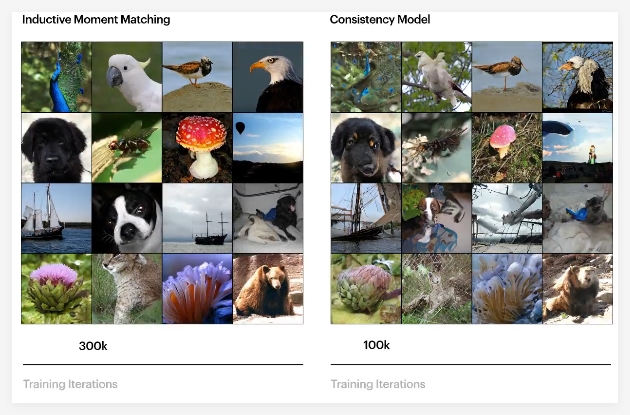

除了速度快,IMM 在訓練穩定性方面也表現出色。相比之下,Consistency Models 在預訓練時容易出現不穩定的情況,需要特殊的超參數設計. 而IMM 則更加“省心”,能夠在各種超參數和模型架構下穩定訓練。

值得注意的是,IMM並沒有依賴於擴散模型所依賴的去噪分數匹配或基於分數的隨機微分方程。 Luma AI 認為,真正的突破不僅僅在於矩匹配本身,更在於他們以推理為先的視角。這種思路讓他們能夠發現現有預訓練範式的局限性,並設計出能夠突破這些限制的創新算法.

Luma AI 對IMM 的未來充滿信心,他們相信這僅僅是一個開始,預示著邁向超越現有界限的多模態基礎模型的新範式。他們希望能夠徹底釋放創造性智能的潛力。

GitHub 倉庫:https://github.com/lumalabs/imm