聽說過壕無人性的OpenAI Sora 吧?動輒幾百萬美元的訓練成本,簡直就是視頻生成界的“勞斯萊斯”。現在,潞晨科技宣布開源視頻生成模型Open-Sora2.0 !

僅僅花費了區區20萬美元(相當於224張GPU 的投入),就成功訓練出了一個擁有110億參數的商業級視頻生成大模型。

性能直追“OpenAI Sora”

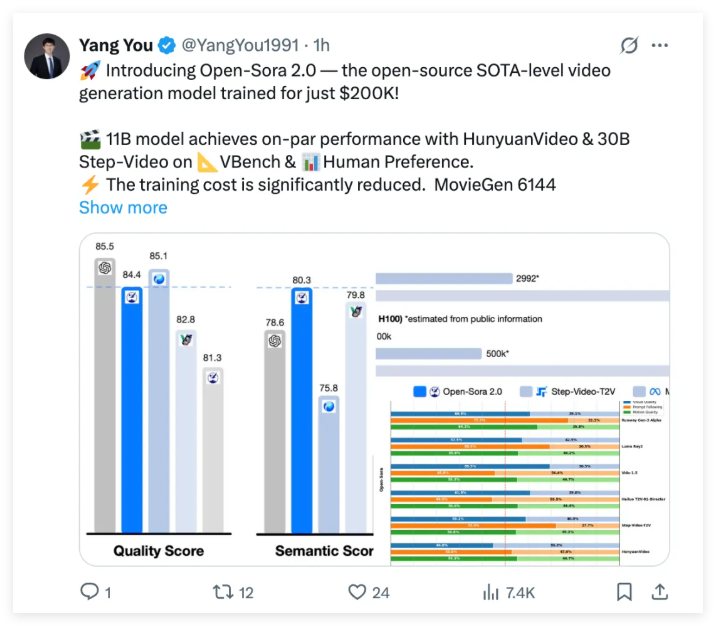

別看Open-Sora2.0成本不高,實力可一點都不含糊。它可是敢於叫板行業標杆HunyuanVideo 和擁有300億參數的Step-Video 的狠角色。在權威評測VBench 和用戶偏好測試中,Open-Sora2.0的表現都令人刮目相看,多項關鍵指標上都能夠媲美那些動輒花費數百萬美元訓練的閉源模型。

更令人激動的是,Open-Sora2.0在VBench 的評測中,與OpenAI Sora 之間的性能差距竟然從之前的4.52%大幅縮小至僅僅0.69% !這幾乎可以說是性能上的全面追平了!

而且,Open-Sora2.0在VBench 中的得分甚至超過了騰訊的HunyuanVideo,真可謂是“長江後浪推前浪”,以更低的成本實現了更高的性能,為開源視頻生成技術樹立了新的標杆!

在用戶偏好評測中,Open Sora 在視覺表現、文本一致性和動作表現這三個關鍵維度上,至少有兩個指標都超越了開源SOTA 模型HunyuanVideo 以及商業模型Runway Gen-3Alpha 等。

大家肯定好奇,Open-Sora2.0是如何做到以如此低的成本實現如此高性能的?這背後可有不少秘密武器。首先,Open Sora 團隊在模型架構上延續了Open-Sora1.2的設計思路,繼續採用3D 自編碼器和Flow Matching 訓練框架。同時,他們還引入了3D 全注意力機制,進一步提升了視頻生成質量。

為了追求極致的成本優化,Open-Sora2.0從多個方面入手:

據估計,市面上10B 以上的開源視頻模型,單次訓練成本動輒上百萬美元,而Open Sora2.0將這個成本降低了5-10倍。這簡直是視頻生成領域的福音,讓更多人有機會參與到高質量視頻生成的研發中來。

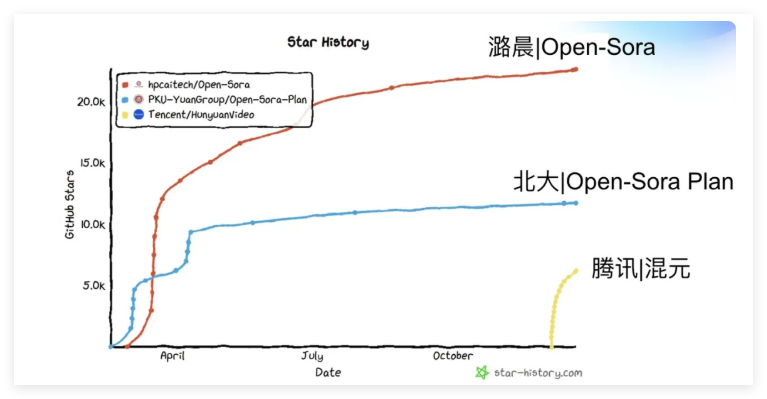

更令人稱讚的是,Open-Sora 不僅開源了模型代碼和權重,還開源了全流程訓練代碼,這無疑將極大地促進整個開源生態的發展。正如第三方技術平台統計,Open-Sora 的學術論文引用量在半年內就獲得了近百引用,在全球開源影響力排名中穩居首位,成為全球影響力最大的開源視頻生成項目之一。

Open-Sora 團隊還積極探索高壓縮比視頻自編碼器的應用,以大幅降低推理成本。他們訓練了一款高壓縮比(4×32×32)的視頻自編碼器,將單卡生成768px、5秒視頻的推理時間從近30分鐘縮短至3分鐘以內,速度提升了10倍! 這意味著未來我們能夠更快地生成高質量的視頻內容。

潞晨科技推出的開源視頻生成模型Open-Sora2.0,以其低成本、高性能、全面開源的特性,無疑給視頻生成領域帶來了一股強勁的“平價”風。它的出現,不僅縮小了與頂級閉源模型之間的差距,更降低了高質量視頻生成的門檻,讓更多開發者能夠參與其中,共同推動視頻生成技術的發展。

? GitHub 開源倉庫:https://github.com/hpcaitech/Open-Sora

?技術報告:https://github.com/hpcaitech/Open-Sora-Demo/blob/main/paper/Open_Sora_2_tech_report.pdf