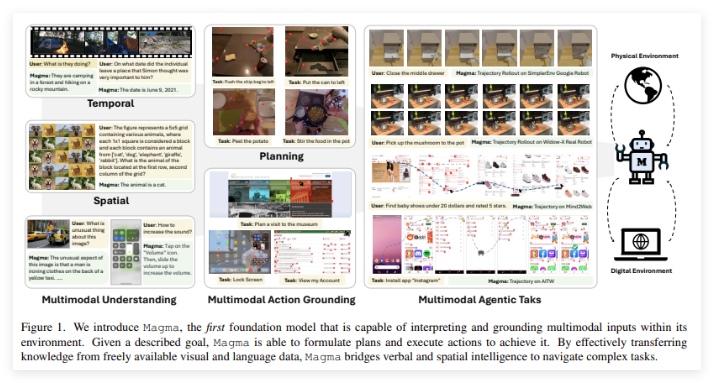

近日,微軟研究團隊聯合多所高校的研究人員,發布了一款名為“Magma” 的多模態AI 模型。這款模型的設計旨在處理和整合圖像、文本和視頻等多種數據類型,以便在數字和物理環境中執行複雜任務。隨著科技的不斷進步,多模態AI 代理正在被廣泛應用於機器人技術、虛擬助手和用戶界面自動化等領域。

以往的AI 系統通常專注於視覺- 語言理解或機器人操作,難以將這兩種能力結合成一個統一的模型。許多現有模型雖然在特定領域內表現良好,但在不同應用場景中的泛化能力較差。例如,Pix2Act 和WebGUM 模型在UI 導航方面表現優異,而OpenVLA 和RT-2則更適合機器人操控,但它們往往需要分別進行訓練,難以跨越數字和物理環境的界限。

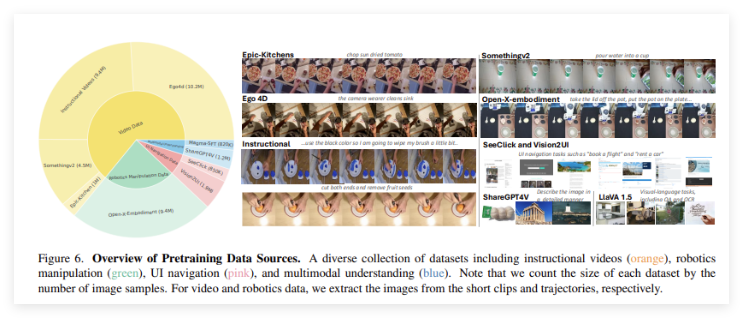

“Magma” 模型的推出,正是為了克服這些局限性。它通過引入一套強大的訓練方法,整合多模態理解、動作定位和規劃能力,旨在讓AI 代理在各種環境中無縫運行。 Magma 的訓練數據集包含了3900萬樣本,包括圖像、視頻和機器人動作軌跡。此外,該模型還採用了兩項創新技術:“可標記集”(Set-of-Mark,SoM)和“軌跡標記”(Trace-of-Mark,ToM)。前者使模型能夠標記UI 環境中的可操作視覺對象,後者則使其能夠追踪物體隨時間的移動,提升未來行動的規劃能力。

“Magma” 採用了先進的深度學習架構和大規模的預訓練技術,以優化其在多個領域的表現。模型使用ConvNeXt-XXL 視覺主幹處理圖像和視頻,LLaMA-3-8B 語言模型負責處理文本輸入。這種架構使“Magma” 能夠高效整合視覺、語言與動作執行。經過全面的訓練,模型在多個任務上都取得了優異的成績,顯示出強大的多模態理解和空間推理能力。

項目入口:https://microsoft.github.io/Magma/