美國程序員就業人數因AI衝擊降至1980年以來新低

419

近日,艾倫人工智能研究所(AI2)發布了最新的大型語言模型—— OLMo232B 。這款模型以“完全開放”的姿態,公開了所有數據、代碼、權重及訓練過程,與閉源模型形成鮮明對比。 AI2希望通過開放協作,推動全球研究人員共同創新。

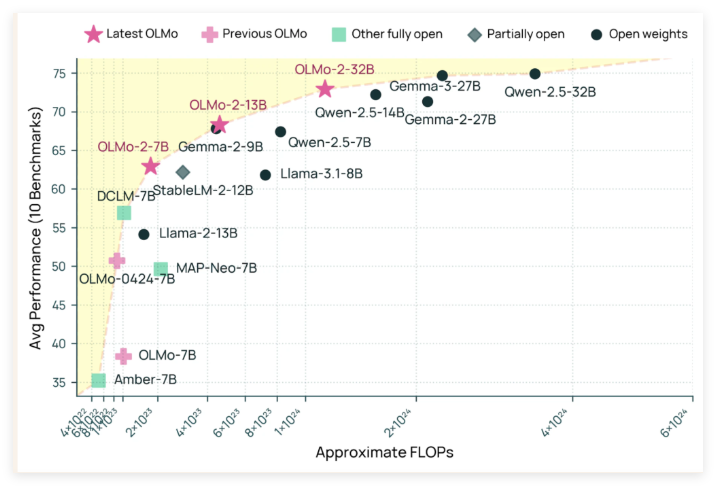

OLMo232B擁有320億參數,在多項學術基準測試中表現優異,甚至超越了GPT-3.5Turbo和GPT-4o mini 。其訓練過程分為預訓練和中期訓練兩個階段,分別使用了約3.9萬億tokens的廣泛數據集和專注於高質量內容的Dolmino數據集,確保了模型的紮實語言功底。

此外,OLMo232B在訓練效率上表現出色,達到與領先模型相當的性能水平時,僅使用了約三分之一的計算資源,體現了AI2在資源高效AI開發方面的投入。

OLMo232B的發布標誌著開放和可訪問AI發展的重要里程碑,為全球研究人員和開發者提供了強大的開源工具,推動人工智能領域的進步。

github:https://github.com/allenai/OLMo-core

huggingface:https://huggingface.co/allenai/OLMo-2-0325-32B-Instruct