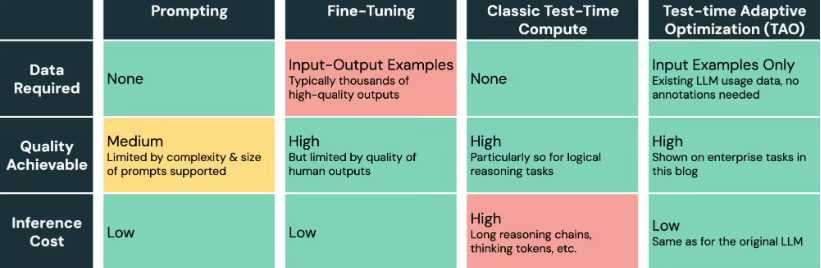

近日,數據智能公司Databricks 推出了一種全新的大語言模型微調方法——TAO(Test-time Adaptive Optimization),這一技術的出現為開源模型的發展帶來了新的希望。通過運用無標註數據和強化學習,TAO 不僅在降低企業成本方面表現出色,更是在一系列基準測試中取得了令人矚目的成績。

根據科技媒體NeoWin 的報導,TAO 微調後的Llama3.370B 模型在金融文檔問答和SQL 生成等任務中,展現出了優於傳統標註微調方法的性能,甚至逼近了OpenAI 的頂級閉源模型。這一成果標誌著開源模型在與商用AI 產品競爭中的又一次重大突破。

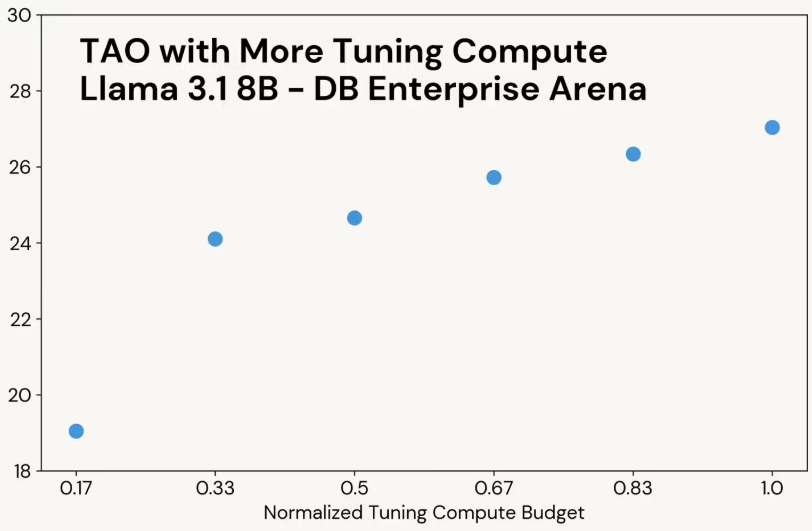

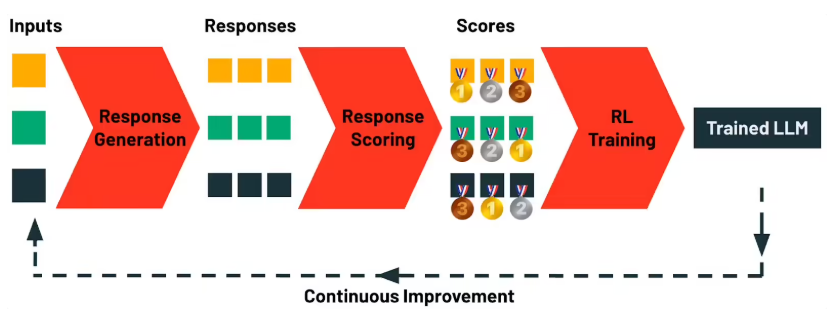

TAO 方法的核心在於其獨特的“測試時計算” 理念,能夠自動探索任務的多樣性,同時結合強化學習來優化模型,從而避免了傳統微調所需的人工標註成本。在多項企業基準測試中,TAO 微調的Llama 模型成績斐然:

- 在FinanceBench 基準測試中,該模型在7200道SEC 文檔問答中取得了85.1的高分,超過了傳統標註微調(81.1)和OpenAI 的o3-mini(82.2)的成績。

- 在BIRD-SQL 測試中,TAO 微調的Llama 模型得分為56.1,接近GPT-4o 的58.1,遠超傳統標註微調(54.9)。

- 在DB Enterprise Arena 中,TAO 模型得分為47.2,雖然略低於GPT-4o 的53.8,但仍然顯示了強勁的競爭力。

TAO 技術為開源模型的持續進化打開了一扇新的大門。隨著用戶使用量的增加,模型將通過反饋數據進行自我優化。目前,Databricks 已在Llama 模型上開始了私測,企業可通過申請參與這一創新的體驗。

這一新技術的推出,不僅是開源AI 領域的一次創新突破,也是對未來大語言模型發展的重要指引。隨著更多企業的參與,TAO 微調方法有望進一步推動開源模型的性能提升,讓開源AI 在商業化應用中展現更大潛力。