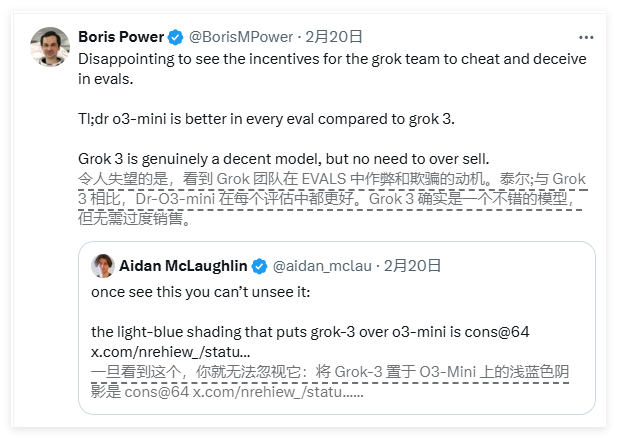

近期,關於人工智能基準測試的爭論在公眾視野中愈演愈烈。 OpenAI 的一名員工指責馬斯克創辦的AI 公司xAI 發布了誤導性的Grok3基準測試結果,而xAI 的聯合創始人伊戈爾・巴布申金則堅稱公司沒有問題。

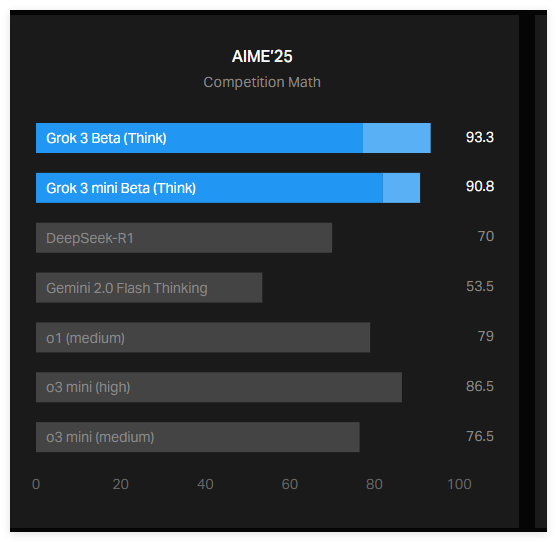

事件的起因是xAI 在其博客上發布了一張圖表,展示了Grok3在AIME2025測試中的表現。 AIME2025是最近一場數學邀請賽中的一系列挑戰性數學問題的集合。雖然一些專家對AIME 作為AI 基準的有效性表示懷疑,但它仍然被廣泛用來評估模型的數學能力。

xAI 的圖表顯示,Grok3的兩個變體——Grok3Reasoning Beta 和Grok3mini Reasoning 在AIME2025的表現上超過了OpenAI 當前最佳模型o3-mini-high。然而,OpenAI 的員工很快指出,xAI 的圖表沒有包含o3-mini-high 在AIME2025上以“cons@64” 計算的分數。

那麼,什麼是cons@64呢?它是“consensus@64” 的縮寫,簡單來說,它給模型提供64次嘗試回答每個問題的機會,並將生成答案中最常見的答案作為最終答案。可以想像,cons@64的評分機制會顯著提升模型的基準分數,因此如果在圖表中省略這一數據,可能會讓人誤以為一個模型的表現超過了另一個模型,但實際上情況並非如此。

Grok3Reasoning Beta 和Grok3mini Reasoning 在AIME2025的“@1” 分數,即模型首次嘗試獲得的分數,實際上低於o3-mini-high 的分數。而Grok3Reasoning Beta 的表現也略遜於OpenAI 的o1模型。儘管如此,xAI 仍將Grok3宣傳為“世界上最聰明的AI”。

巴布申金在社交媒體上回應稱,OpenAI 過去也發布過類似的誤導性基準圖表,主要是對比自身模型的表現。而一位中立的專家則將各種模型的表現整理成一張更“準確” 的圖表,引發了更廣泛的討論。

此外,AI 研究者納森・蘭伯特指出,一個更為重要的指標卻仍然不明朗:各模型取得最佳分數所需的計算(和財務)成本。這也表明,當前大多數AI 基準測試所傳達的信息對於模型的局限性及其優勢仍顯得有限。