在人工智能領域,訓練大型語言模型(LLMs)已成為推動技術進步的重要方向。然而,隨著模型規模和數據集的不斷擴大,傳統的優化方法—— 特別是AdamW—— 逐漸顯露出其局限性。研究人員面臨著計算成本高、訓練不穩定等一系列挑戰,包括梯度消失或爆炸、參數矩陣更新不一致及分佈式環境下的資源需求高等問題。因此,迫切需要更高效、更穩定的優化技術來應對這些複雜性。

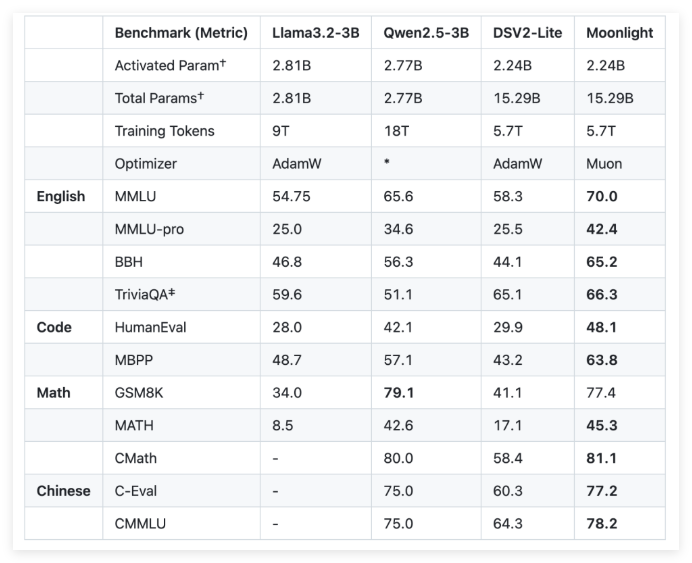

為了解決這些挑戰,Moonshot AI (月之暗面)與加州大學洛杉磯分校(UCLA)聯合開發了Moonlight,一個使用Muon 優化器的Mixture-of-Expert(MoE)模型。 Moonlight 提供兩種配置:一種是激活參數為30億,另一種為總參數為160億,訓練使用了5.7萬億個標記。 Muon 優化器的創新在於利用牛頓- 舒爾茨迭代法進行矩陣正交化,確保梯度更新在模型參數空間中的均勻性。這種改進為傳統的AdamW 提供了一個有前景的替代方案,提高了訓練效率和穩定性。

在技術細節上,Moonlight 對Muon 優化器進行了兩項關鍵調整。首先,引入了權重衰減技術,以控制大模型和大量標記訓練時權重的增長。其次,針對每個參數的更新幅度進行了校準,使其根據權重矩陣的最大維度的平方根進行縮放,從而實現更新的一致性。

通過對Moonlight 的實證評估,研究人員發現其在中間檢查點的表現優於傳統的AdamW 訓練模型。例如,在語言理解任務中,Moonlight 在MMLU 基準測試上獲得了更高的分數。在代碼生成任務中,性能提升更加明顯,表明Muon 的優化機制對任務表現有積極貢獻。

Moonlight 項目的成功實施將為大型語言模型的訓練帶來新的標準。 Muon 優化器的開源實現以及預訓練模型和中間檢查點的發布,預期將促進對可擴展優化技術的進一步研究。

github:https://github.com/MoonshotAI/Moonlight?tab=readme-ov-file

huggingface:https://huggingface.co/moonshotai/Moonlight-16B-A3B

論文:https://github.com/MoonshotAI/Moonlight/blob/master/Moonlight.pdf