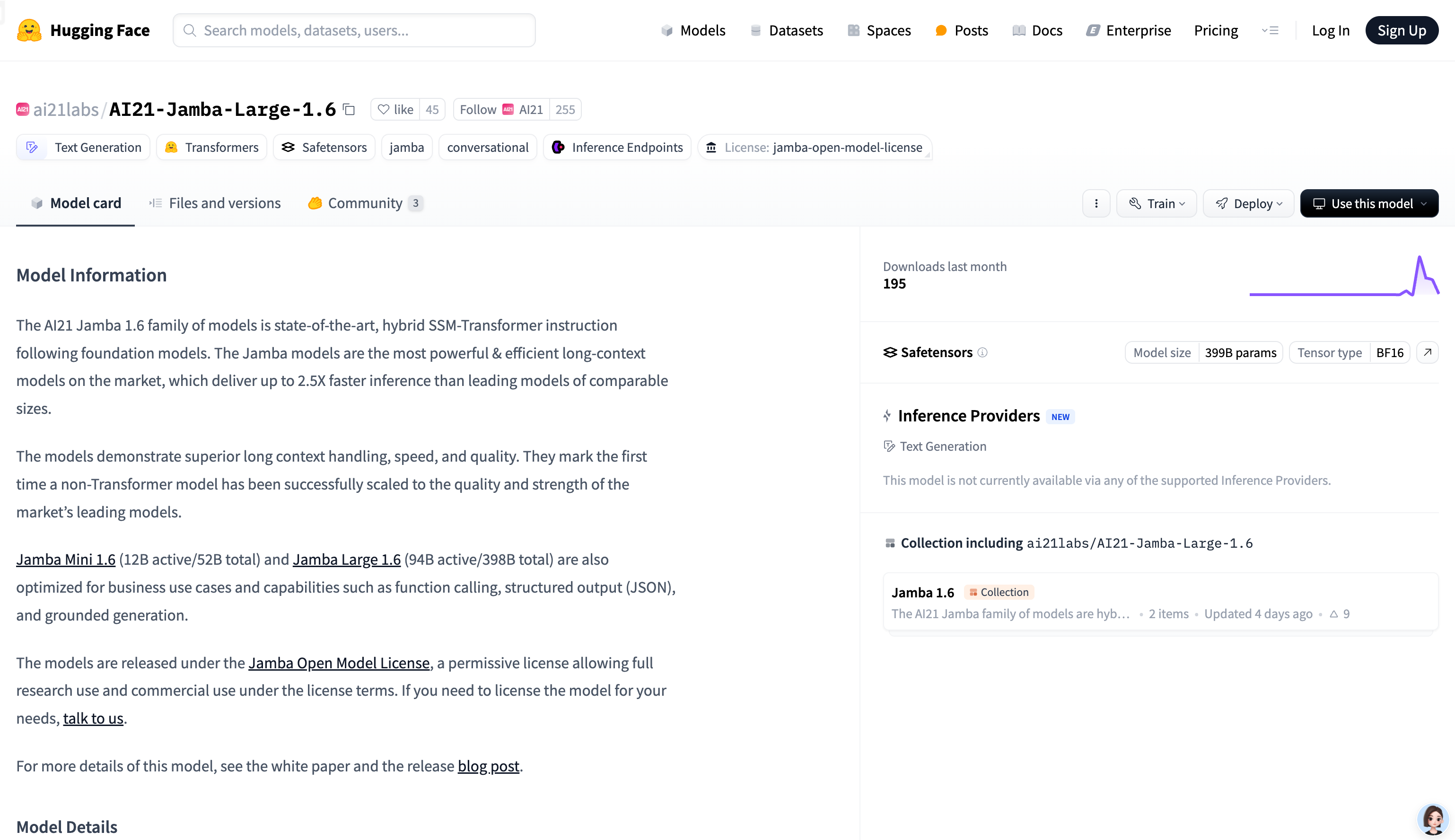

AI21-Jamba-Large-1.6是由AI21 Labs 開發的混合SSM-Transformer 架構基礎模型,專為長文本處理和高效推理而設計。該模型在長文本處理、推理速度和質量方面表現出色,支持多種語言,並具備強大的指令跟隨能力。它適用於需要處理大量文本數據的企業級應用,如金融分析、內容生成等。該模型採用Jamba Open Model License 授權,允許在許可條款下進行研究和商業使用。

需求人群:

"該模型適用於需要高效處理長文本數據的企業和開發者,如金融、法律、內容創作等領域。它能夠快速生成高質量文本,支持多語言和復雜任務處理,適合需要高性能和高效率的商業應用。"

使用場景示例:

在金融領域,用於分析和生成金融報告,提供準確的市場預測和投資建議。

在內容創作中,幫助生成文章、故事或創意文案,提高創作效率。

在客服場景中,作為聊天機器人回答用戶問題,提供準確且自然的語言回复。

產品特色:

支持長文本處理(上下文長度達256K),適合處理長文檔和復雜任務

推理速度快,比同類模型快2.5 倍,顯著提高效率

支持多種語言,包括英語、西班牙語、法語等,適用於多語言應用場景

具備指令跟隨能力,能夠根據用戶指令生成高質量文本

支持工具調用,可與外部工具結合,擴展模型功能

使用教程:

1. 安裝必要的依賴,如mamba-ssm、causal-conv1d 和vllm(推薦使用vllm 進行高效推理)。

2. 使用vllm 加載模型,設置合適的量化策略(如ExpertsInt8)以適應GPU 資源。

3. 使用transformers 庫加載模型,結合bitsandbytes 進行量化,以優化推理性能。

4. 準備輸入數據,使用AutoTokenizer 對文本進行編碼。

5. 調用模型生成文本,通過設置參數(如溫度、最大生成長度)控制生成結果。

6. 對生成的文本進行解碼,提取模型輸出的內容。

7. 如需使用工具調用功能,將工具定義嵌入到輸入模板中,並處理模型返回的工具調用結果。