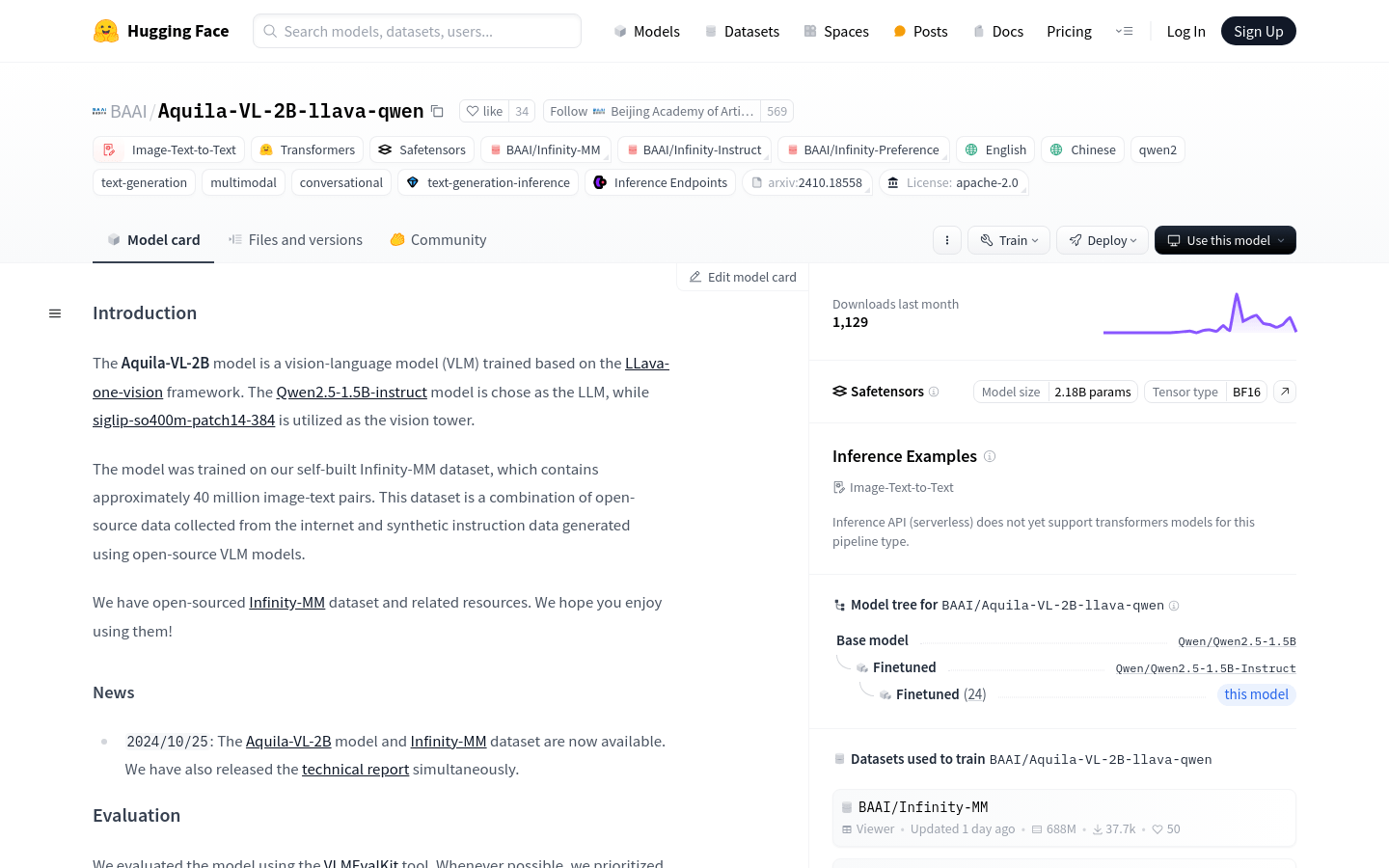

Aquila-VL-2B模型是一個基於LLava-one-vision框架訓練的視覺語言模型(VLM),選用Qwen2.5-1.5B-instruct模型作為語言模型(LLM),並使用siglip-so400m-patch14-384作為視覺塔。該模型在自建的Infinity-MM數據集上進行訓練,包含約4000萬圖像-文本對。該數據集結合了從互聯網收集的開源數據和使用開源VLM模型生成的合成指令數據。 Aquila-VL-2B模型的開源,旨在推動多模態性能的發展,特別是在圖像和文本的結合處理方面。

需求人群:

"目標受眾為研究人員、開發者和企業,他們需要處理和分析大量的圖像與文本數據,進行智能決策和信息提取。Aquila-VL-2B模型能夠提供強大的視覺語言理解和生成能力,幫助他們提高數據處理效率和準確性。"

使用場景示例:

案例一:使用Aquila-VL-2B模型對社交媒體上的圖片進行內容分析和描述生成。

案例二:在電子商務平台中,利用該模型為商品圖片自動生成描述性文本,提升用戶體驗。

案例三:在教育領域,通過圖像和文本的結合,為學生提供更直觀的學習材料和互動體驗。

產品特色:

• 支持圖像-文本到文本的轉換(Image-Text-to-Text)

• 基於Transformers和Safetensors庫構建

• 支持多種語言,包括中文和英文

• 支持多模態和對話生成

• 支持文本生成推理

• 兼容推理端點(Inference Endpoints)

• 支持大規模圖像-文本數據集

使用教程:

1. 安裝必要的庫:使用pip安裝LLaVA-NeXT庫。

2. 加載預訓練模型:通過llava.model.builder中的load_pretrained_model函數加載Aquila-VL-2B模型。

3. 準備圖像數據:使用PIL庫加載圖像,並使用llava.mm_utils中的process_images函數處理圖像數據。

4. 構建對話模板:根據模型選擇合適的對話模板,並構建問題。

5. 生成提示:將問題和對話模板結合,生成模型的輸入提示。

6. 編碼輸入:使用tokenizer將提示問題編碼為模型可理解的輸入格式。

7. 生成輸出:調用模型的generate函數,生成文本輸出。

8. 解碼輸出:使用tokenizer.batch_decode函數將模型輸出解碼為可讀文本。