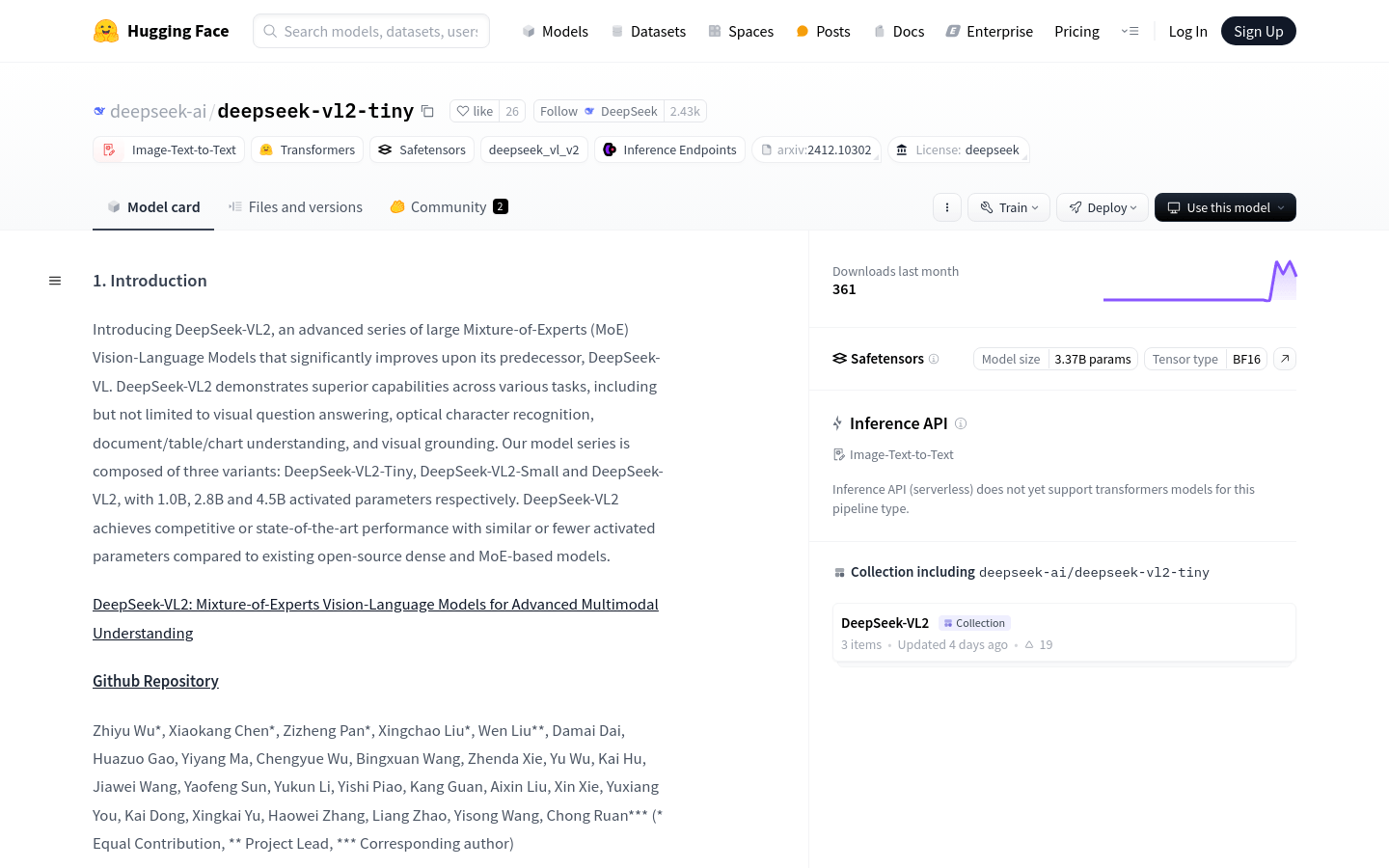

什麼是 DeepSeek-VL2?

DeepSeek-VL2 是一系列先進的大規模混合專家 (MoE) 視覺語言模型,其性能顯著優於其前身 DeepSeek-VL。此模型系列在視覺問答、光學字元辨識、文件/表格/圖表理解和視覺基礎等任務方面表現出色。

DeepSeek-VL2 系列包括三個變體: DeepSeek-VL2-Tiny 、DeepSeek-VL2-Small 和 DeepSeek-VL2,分別具有 1.0B、2.8B 和 4.5B 活化參數。與現有的開源密集模型和基於 MoE 的模型相比,即使具有相似或更少的活化參數,這些模型也能實現具有競爭力或最先進的性能。

目標受眾:

該產品非常適合需要影像理解和視覺語言處理的企業和研究機構,例如自動駕駛汽車公司、安全監控公司和智慧助理開發人員。他們可以利用DeepSeek-VL2深度分析和理解影像內容,增強產品的視覺辨識和互動能力。

範例場景:

在零售業,DeepSeek-VL2 可以分析監視影片來辨識顧客的行為模式。

在教育領域,它可以解析教科書圖像以提供互動式學習體驗。

在醫學影像中,它可以對醫學影像中的病理特徵進行識別和分類。

主要特點:

視覺問答:理解並回答與圖像相關的問題。

光學字元辨識:辨識影像中的文字資訊。

文件/表格/圖表理解:解析和理解文件、表格和圖表中的內容。

視覺基礎:辨識影像中的特定物件或元素。

多模態理解:結合視覺和語言訊息以實現更深入的內容理解。

模型變體:提供不同的規模以適應各種應用程式和計算資源。

商業用途支援:DeepSeek-VL2支援商業用途。

入門指南:

1. 安裝依賴:在 Python 環境(版本 >= 3.8)中,執行 pip install -e 。安裝依賴項。

2.導入庫:導入torch、transformers以及相關的DeepSeek-VL2模組。

3.指定模型路徑:將模型路徑設定為deepseek-ai/deepseek-vl2-small。

4.載入模型和處理器:使用DeepseekVLV2Processor和AutoModelForCausalLM從指定路徑載入模型。

5. 準備輸入資料:載入並準備用於輸入的對話內容和影像。

6. 運行響應模型:使用模型的生成方法根據輸入嵌入和注意遮罩產生響應。

7. 解碼並輸出結果:對編碼後的模型輸出解碼並列印結果。