什么是 Diffusion-Vas?

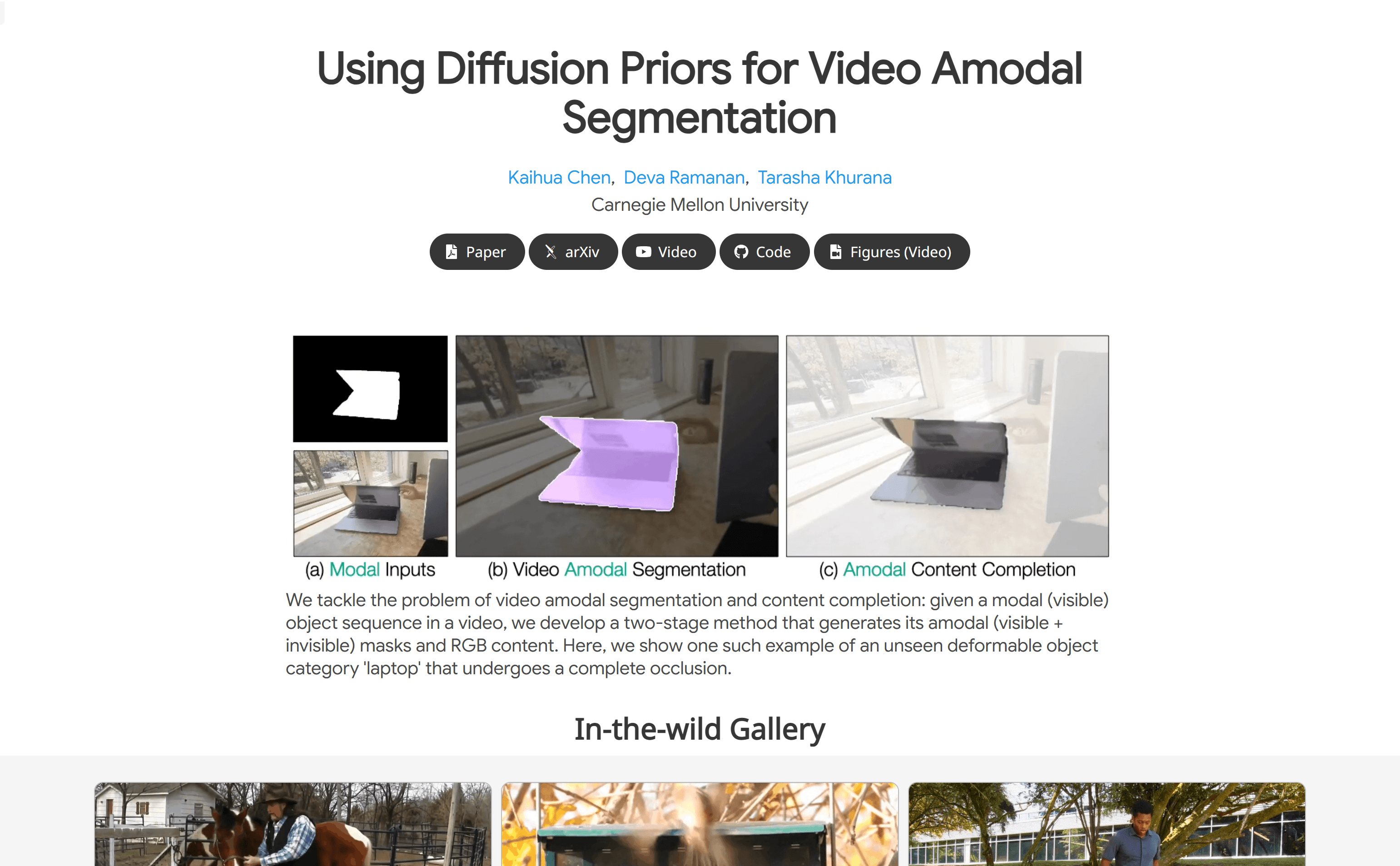

Diffusion-Vas 是由卡内基梅隆大学开发的一种先进视频处理模型,专门用于解决视频中物体被遮挡的问题。它能够智能地识别和分割视频中被遮挡的物体,并自动补全这些物体的缺失部分,从而恢复物体的完整外观。这项技术对于提升视频分析的准确性和可靠性具有重要意义。

需求人群:

Diffusion-Vas 主要面向计算机视觉领域的研究人员和开发者,特别是那些专注于视频内容分析、物体分割和场景理解的专业人士。无论你是从事监控系统开发、电影后期制作,还是自动驾驶技术研究,Diffusion-Vas 都能为你提供强大的技术支持,帮助你更好地处理视频中的遮挡问题。

使用场景示例:

1. 监控视频分析:在复杂的监控场景中,Diffusion-Vas 可以识别并分割出被遮挡的行人或车辆,显著提高监控系统的安全性和效率。

2. 电影后期制作:在电影制作过程中,该模型可以用来修复或补全因拍摄角度问题而被遮挡的场景部分,提升影片的视觉效果。

3. 自动驾驶:在自动驾驶领域,Diffusion-Vas 能够帮助系统更好地理解复杂交通场景中的遮挡物体,提高驾驶安全性和决策准确性。

产品特色:

智能物体分割:能够精确识别并分割视频中被遮挡的物体部分,即使在高度遮挡的情况下也能保持高准确性。

内容补全:自动填充被遮挡的物体区域,恢复物体的完整外观,确保视频内容的连贯性。

先进的3D UNet网络:采用3D UNet骨干网络,显著提高了分割和补全的准确性。

多数据集验证:在多个数据集上进行了广泛测试,性能表现优异,特别是在物体被遮挡区域的非可见分割上,性能提升高达13%。

零样本学习能力:即使在仅在合成数据上训练的情况下,模型也能很好地泛化到真实世界场景,展现出强大的适应能力。

无需额外输入:模型不依赖相机姿态或光流等额外输入,保持了高度的鲁棒性和易用性。

使用教程:

1. 准备视频数据:确保视频数据质量良好,且包含需要分割和补全的物体。

2. 运行模型:将视频数据输入到 Diffusion-Vas 模型中,模型将自动处理并生成非可见物体掩码。

3. 内容补全:使用模型的第二阶段对被遮挡区域进行内容补全,恢复物体的完整外观。

4. 结果评估:对比模型输出的非可见物体掩码和实际的物体掩码,评估分割的准确性。

5. 应用场景:根据实际应用场景,将模型的输出应用到相应的系统中,如监控、电影后期制作或自动驾驶。

6. 性能优化:根据实际使用反馈,对模型进行调整和优化,以适应不同的视频内容和场景。

通过以上步骤,你可以充分利用 Diffusion-Vas 的强大功能,提升视频处理的效果和效率。无论你是初学者还是专业人士,Diffusion-Vas 都能为你提供可靠的技术支持,帮助你在计算机视觉领域取得更大的突破。