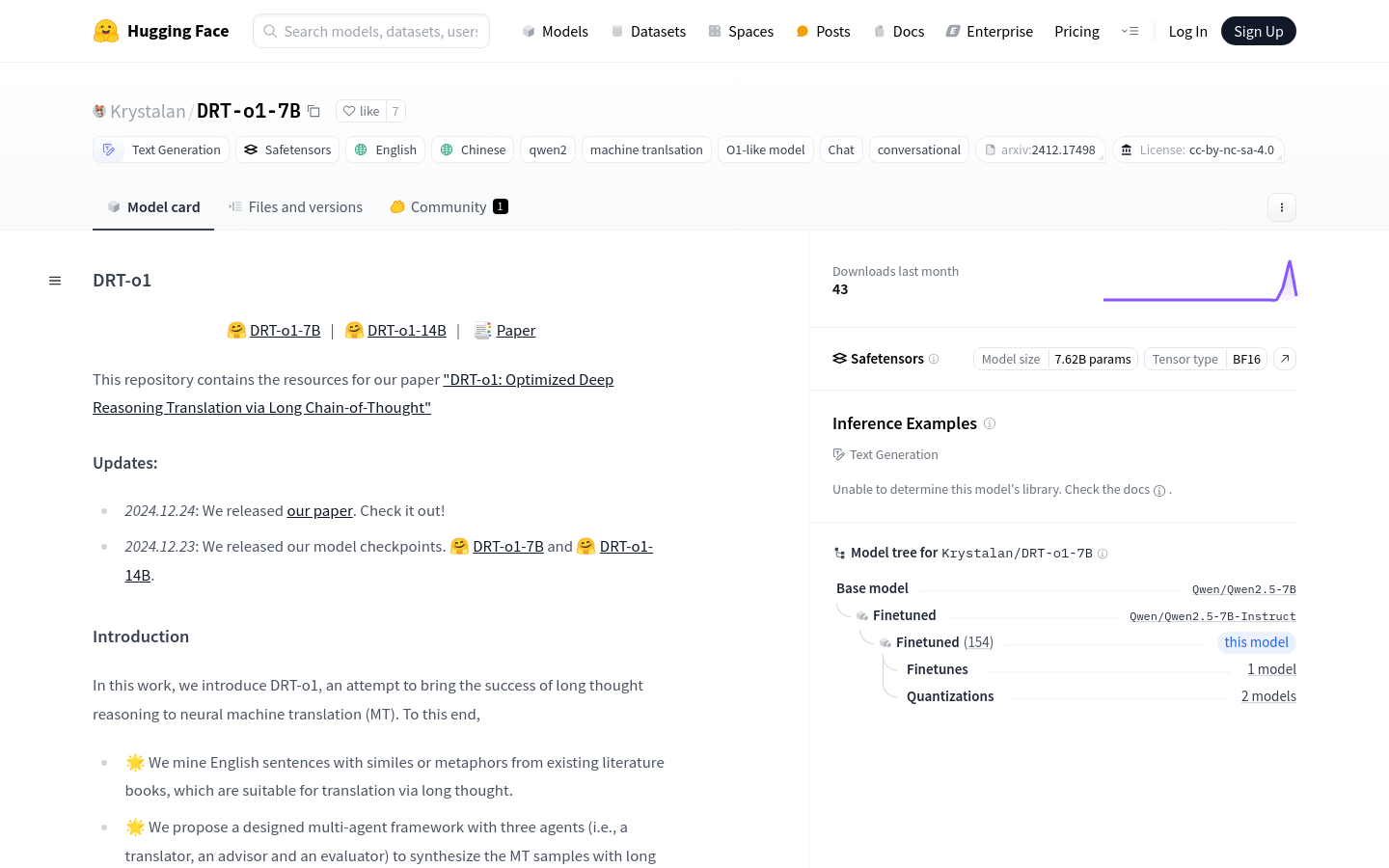

DRT-o1-7B是一個致力於將長思考推理成功應用於神經機器翻譯(MT)的模型。該模型通過挖掘適合長思考翻譯的英文句子,並提出了一個包含翻譯者、顧問和評估者三個角色的多代理框架來合成MT樣本。 DRT-o1-7B和DRT-o1-14B使用Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct作為骨幹網絡進行訓練。該模型的主要優點在於其能夠處理複雜的語言結構和深層次的語義理解,這對於提高機器翻譯的準確性和自然性至關重要。

需求人群:

" DRT-o1-7B模型的目標受眾是自然語言處理領域的研究者、開發者以及機器翻譯服務提供商。該模型適合他們因為它提供了一種新的、基於深度推理的方法來提高機器翻譯的質量,尤其是在處理複雜語言結構時。此外,它還能夠促進對長思考推理在機器翻譯中應用的研究。"

使用場景示例:

案例1:使用DRT-o1-7B模型將含有隱喻的英文文學作品翻譯成中文。

案例2:將DRT-o1-7B應用於跨文化交流平台,提供高質量的自動翻譯服務。

案例3:在學術研究中使用DRT-o1-7B模型來分析和比較不同機器翻譯模型的性能。

產品特色:

• 長思考推理應用於機器翻譯:通過長鏈思考來提升翻譯質量。

• 多代理框架設計:包含翻譯者、顧問和評估者三個角色,以合成MT樣本。

• 基於Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct訓練:使用先進的預訓練模型作為基礎。

• 支持英文和中文翻譯:能夠處理中英文之間的機器翻譯任務。

• 適用於復雜語言結構:能夠處理含有比喻或隱喻的複雜句子。

• 提供模型檢查點:方便研究者和開發者使用和進一步研究。

• 支持Huggingface Transformers和vllm部署:易於集成和使用。

使用教程:

1. 訪問Huggingface官網並導航至DRT-o1-7B模型頁面。

2. 根據頁面提供的代碼示例,導入必要的庫和模塊。

3. 設置模型名稱為'Krystalan/ DRT-o1-7B ',並加載模型和分詞器。

4. 準備輸入文本,例如需要翻譯的英文句子。

5. 使用分詞器將輸入文本轉換為模型可接受的格式。

6. 將轉換後的文本輸入模型,並設置生成參數,如最大新令牌數。

7. 模型生成翻譯結果後,使用分詞器解碼生成的令牌以獲取翻譯文本。

8. 輸出並評估翻譯結果,根據需要進行後續處理。