Gemma-2B-10M

Gemma-2B-10M提供強大的 AI 工具,用於創建和設計既引人入勝又易於使用的創新網路體驗。

適用於需要處理大量文字資料的研究人員和開發者。

適合進行長文本生成、摘要、翻譯等語言任務。

對於追求高效能和資源優化的企業用戶具有吸引力。

使用Gemma 2B - 10M Context產生《哈利波特》系列書籍的摘要。

在教育領域中,學術論文自動產生概要。

在商業領域,為產品描述和市場分析自動產生文字內容。

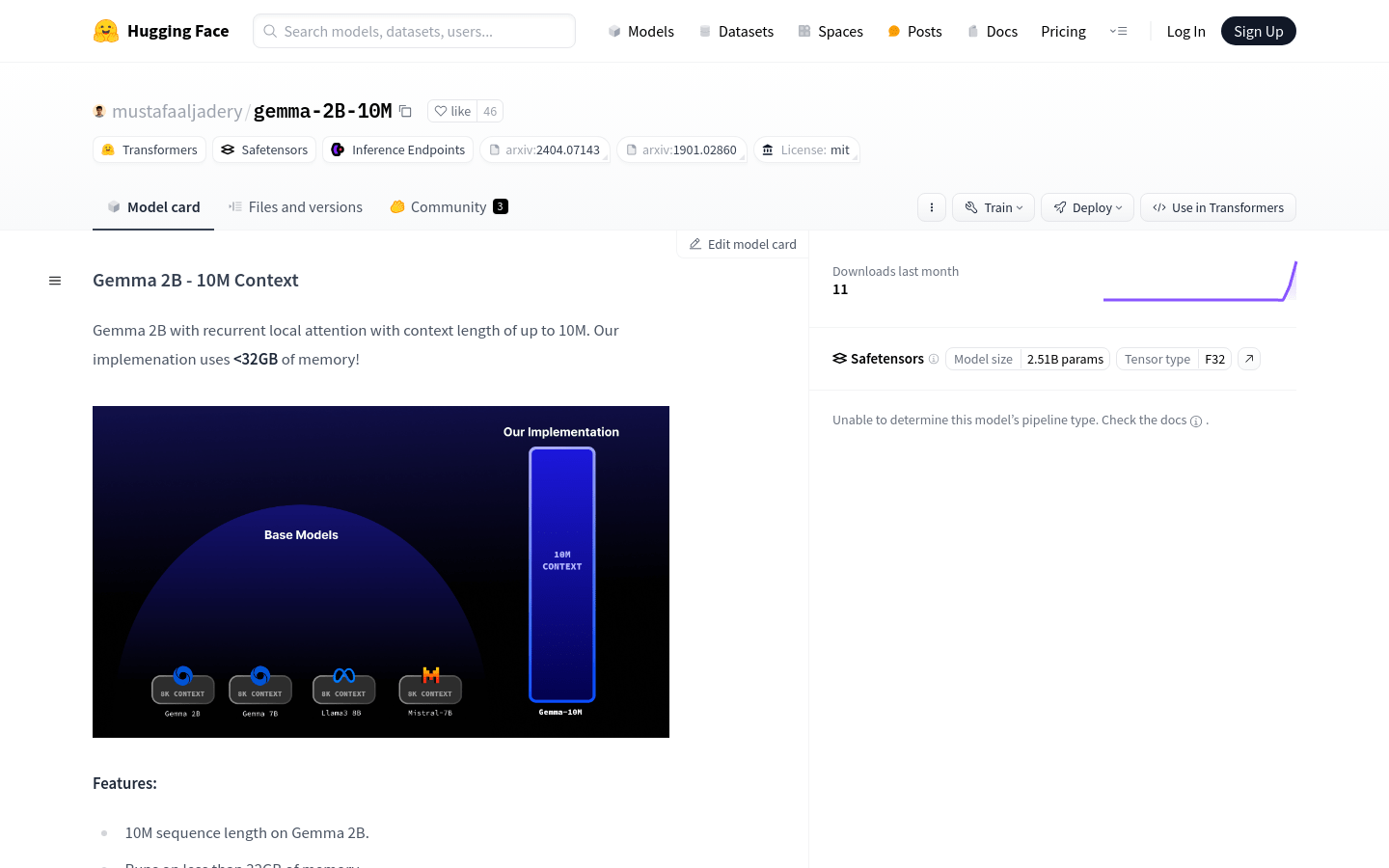

支援10M序列長度的文字處理能力。

在低於32GB記憶體下運行,優化資源使用。

專為CUDA優化的原生推理效能。

循環局部注意力實現O(N)記憶體複雜度。

200步早期檢查點,計畫訓練更多token以提升效能。

使用AutoTokenizer和GemmaForCausalLM進行文字產生。

步驟1: 安裝模型,從huggingface取得Gemma 2B - 10M Context模型。

步驟2: 修改main.py中的推理程式碼以適應特定的提示文字。

步驟3: 使用AutoTokenizer.from_pretrained載入模型的分詞器。

步驟4: 使用GemmaForCausalLM.from_pretrained載入模型並指定資料類型為torch.bfloat16。

步驟5: 設定提示文本,例如'Summarize this harry potter book... '。

步驟6: 在不計算梯度的情況下,使用generate函數產生文字。

步驟7: 列印產生的文字以查看結果。