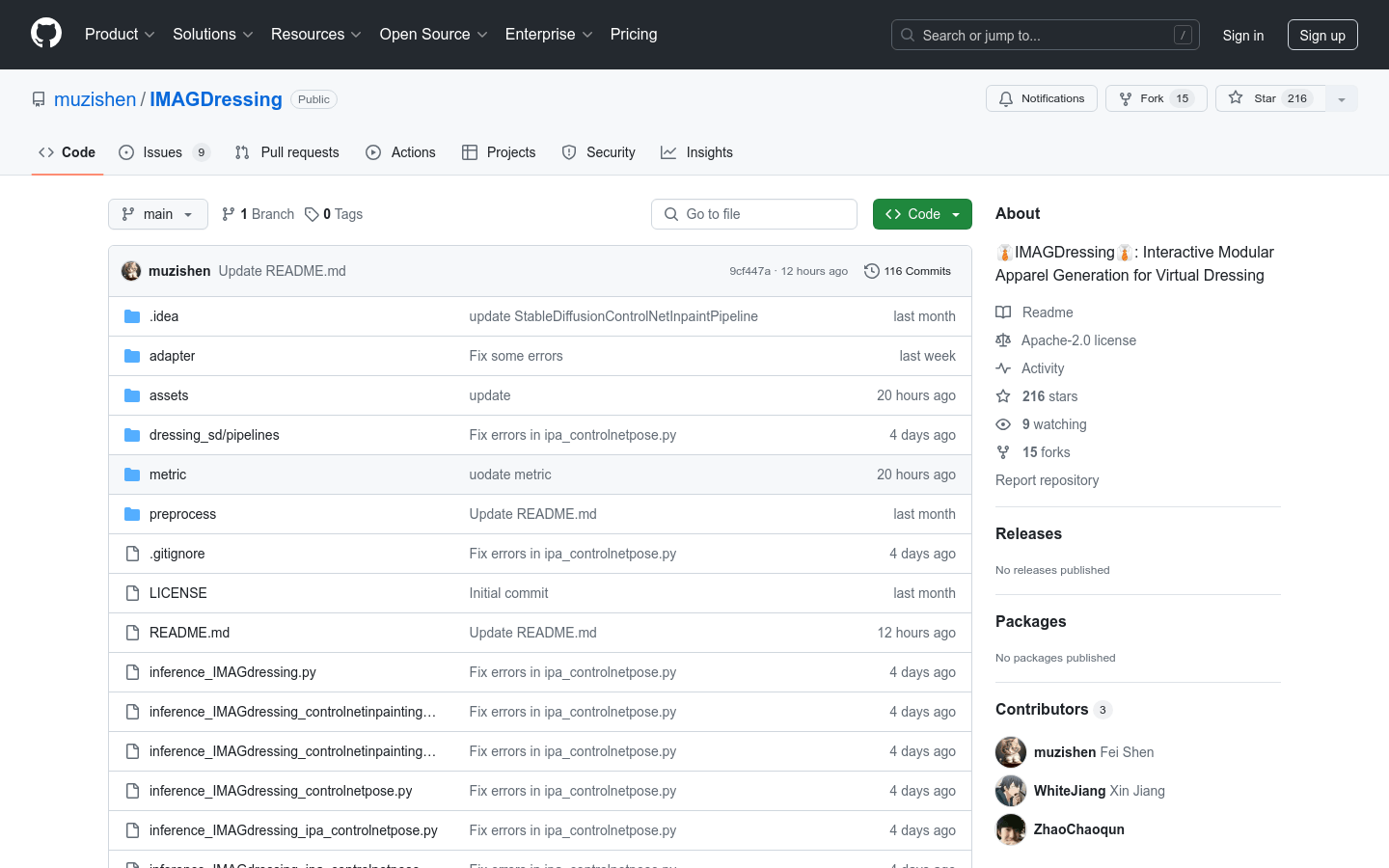

IMAGDressing是一個交互式模塊化服裝生成模型,旨在為虛擬試穿系統提供靈活和可控的定制化服務。該模型通過結合CLIP的語義特徵和VAE的紋理特徵,使用混合注意力模塊將這些特徵整合到去噪UNet中,確保用戶可以控制編輯。此外, IMAGDressing還提供了IGPair數據集,包含超過30萬對服裝和穿著圖像,建立了標準的數據組裝流程。該模型可以與ControlNet、IP-Adapter、T2I-Adapter和AnimateDiff等擴展插件結合使用,增強多樣性和可控性。

需求人群:

" IMAGDressing主要面向服裝設計師、虛擬試衣軟件開發者和研究人員。它通過提供逼真的服裝生成和靈活的定制功能,幫助設計師快速預覽設計效果,軟件開發者實現虛擬試衣功能,研究人員則可以利用其進行相關領域的研究和探索。"

使用場景示例:

服裝設計師使用IMAGDressing生成不同風格的服裝效果圖。

虛擬試衣軟件開發者利用IMAGDressing實現用戶在線試穿服裝的功能。

研究人員使用IMAGDressing進行服裝生成和虛擬試穿的相關研究。

產品特色:

簡單架構:生成逼真的服裝並支持用戶驅動的場景編輯。

靈活插件兼容性:與IP-Adapter、ControlNet、T2I-Adapter和AnimateDiff等擴展插件集成。

快速定制:無需額外LoRA訓練即可在幾秒內實現快速定制。

支持文本提示:根據不同場景支持文本提示。

支持指定區域的服裝更換(實驗性功能)。

支持與ControlNet和IP-Adapter結合使用。

提供IGPair數據集:包含超過30萬對服裝和穿著圖像。

使用教程:

1. 安裝Python環境(推薦使用Anaconda或Miniconda)。

2. 安裝PyTorch(版本需大於等於2.0.0)。

3. 安裝CUDA(版本為11.8)。

4. 克隆IMAGDressing的GitHub倉庫。

5. 安裝依賴庫:運行`pip install -r requirements.txt`。

6. 下載並安裝所需的模型文件,如humanparsing和openpose模型文件。

7. 運行IMAGDressing的推理代碼,進行服裝生成和虛擬試穿。

8. 根據需要,結合ControlNet、IP-Adapter等擴展插件,增強功能。