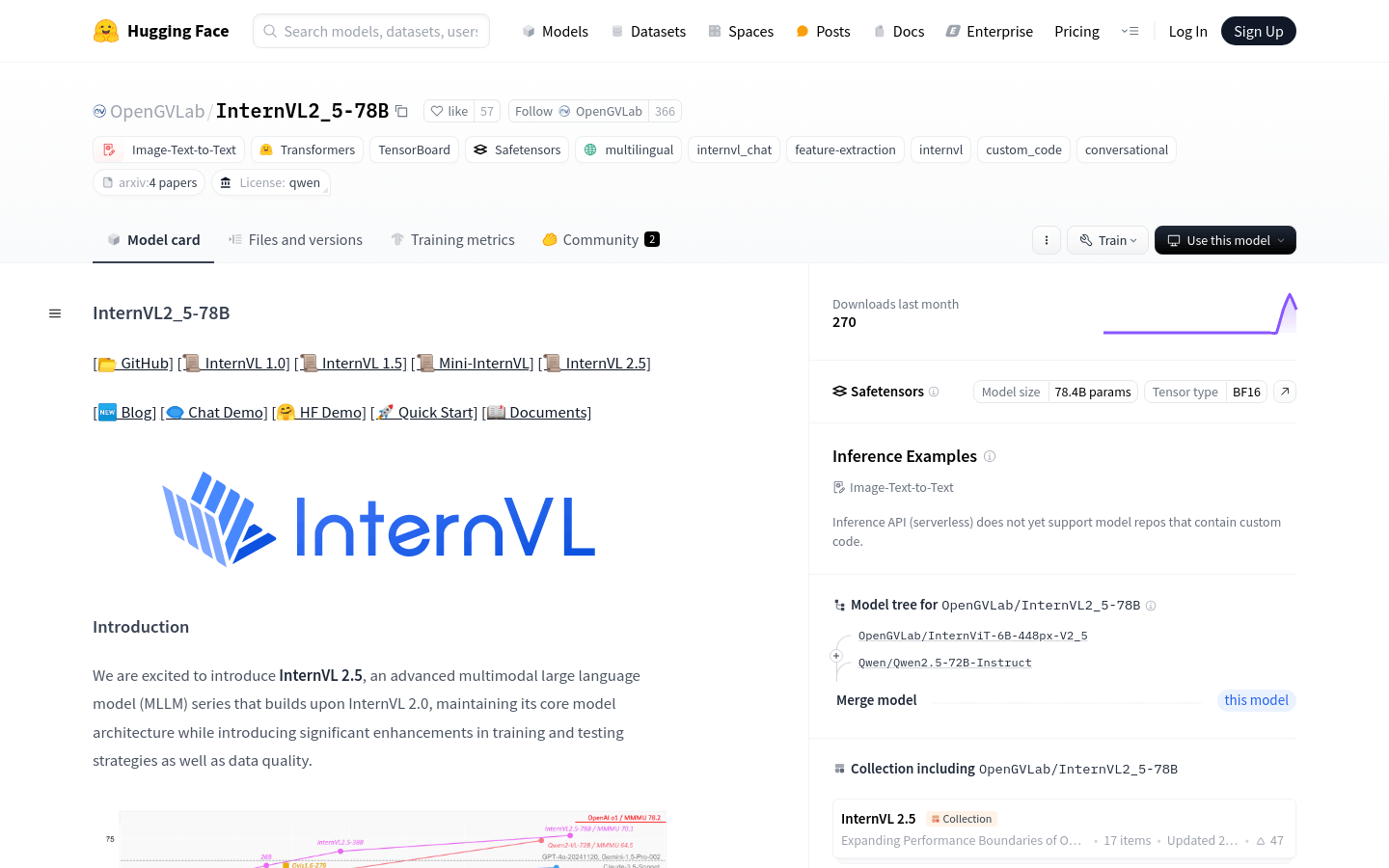

什麼是Internvl 2.5?

InternVL 2.5是一系列高級多式模式模型(MLLM),它基於Internvl 2.0,在培訓和測試策略方面有顯著改進以及增強的數據質量。該模型系列已針對視覺感知和多模式功能進行了優化,支持圖像到文本轉換和文本到文本變換等功能。它是涉及視覺和語言信息的複雜任務的理想選擇。

誰可以使用Internvl 2.5?

目標受眾包括研究人員,開發人員和企業用戶,尤其是那些正在開發處理視覺和語言數據的AI應用程序的人。 InternVL2_5-78B模型特別適合涉及圖像識別,自然語言處理和機器學習的應用,這是由於其強大的多模式處理能力和有效的培訓策略。

示例場景:

圖像描述生成:使用InternVL2_5-78B將圖像內容轉換為文本描述。

多模式圖像分析:分析和比較不同的圖像,以使用InternVL2_5-78B確定相似性和差異。

視頻理解:使用InternVL2_5-78B處理視頻幀並提供視頻內容的詳細分析。

關鍵功能:

支持多模式數據集的動態高分辨率培訓方法,從而提高多圖像和視頻任務的性能。

利用“ VIT-MLP-LLM”體系結構,將新預培訓的實習生與各種預訓練的大型語言模型相結合。

合併隨機初始化的MLP投影儀,以有效整合視覺編碼器和語言模型。

實現漸進式擴展策略,以優化視覺編碼器和大型語言模型之間的對齊。

使用隨機的JPEG壓縮和損失重新加權技術來提高與嘈雜圖像的魯棒性,並平衡NTP損失的響應。

支持來自多個圖像和視頻的輸入,從而擴大了模型在多模式任務中的應用。

入門指南:

1。訪問擁抱面孔網站,搜索InternVL2_5-78B型號。

2。根據您的特定用例下載並加載模型。

3。準備輸入數據,包括圖像和文本,並執行必要的預處理。

4。通過遵循提供的API文檔並輸入處理後的數據來使用模型進行推理。

5。獲取模型輸出,該輸出可能是圖像,視頻內容分析或其他多模式任務結果的文本描述。

6。根據需要處理輸出,例如顯示,存儲或進一步分析。

7。可選地調整模型以更好地適合特定的應用要求。