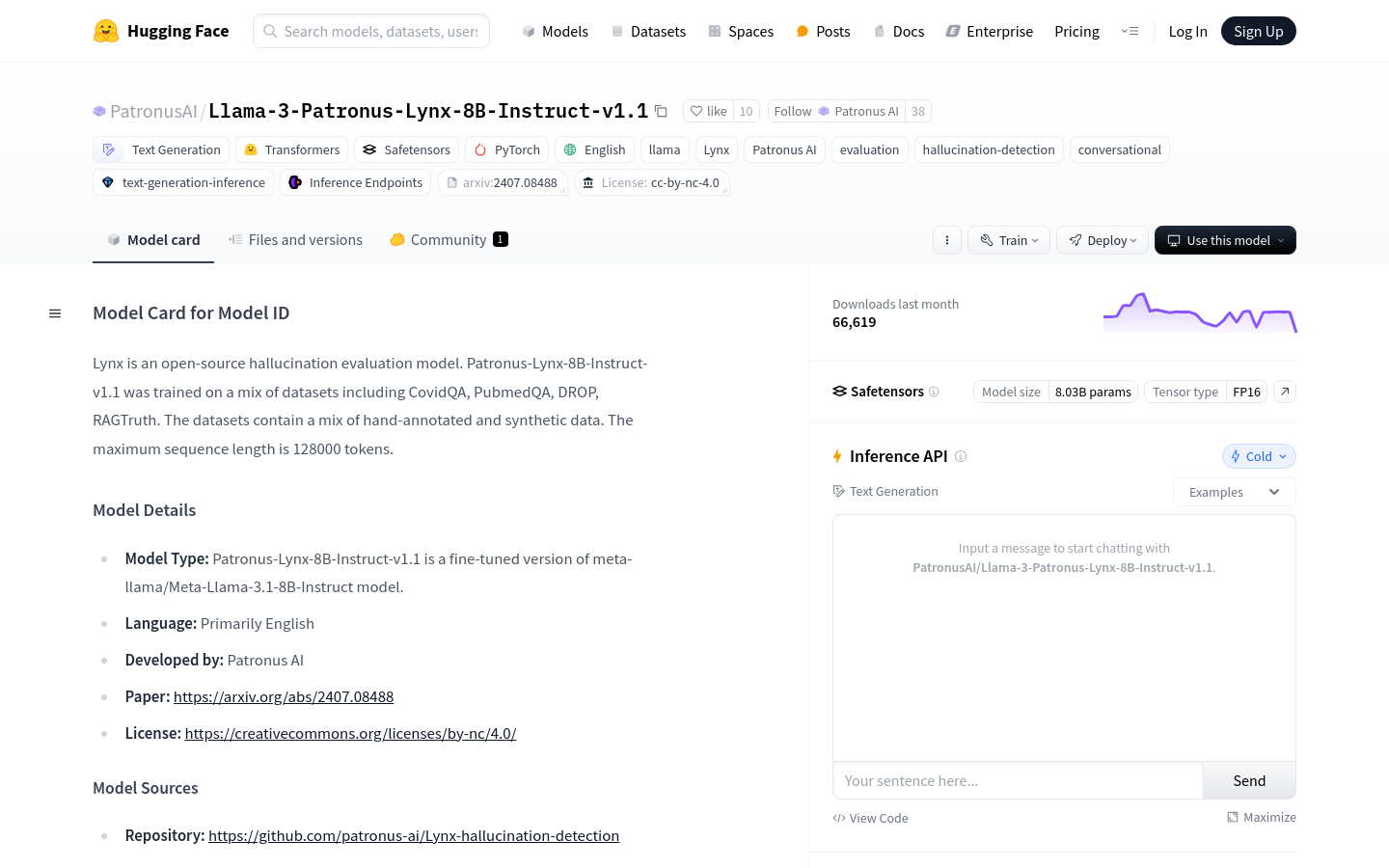

Patronus-Lynx-8B-Instruct-v1.1是基於meta-llama/Meta-Llama-3.1-8B-Instruct模型的微調版本,主要用於檢測RAG設置中的幻覺。該模型經過CovidQA、PubmedQA、DROP、RAGTruth等多個數據集的訓練,包含人工標註和合成數據。它能夠評估給定文檔、問題和答案是否忠實於文檔內容,不提供超出文檔範圍的新信息,也不與文檔信息相矛盾。

需求人群:

"目標受眾為研究人員、開發者和企業,他們需要一個可靠的模型來評估和生成忠實於源文檔的文本。該模型適合用於自然語言處理、文本摘要、問答系統和聊天機器人等應用場景。"

使用場景示例:

研究人員使用該模型來評估醫學文獻中答案的準確性。

開發者將模型集成到問答系統中,提供基於文檔的準確回答。

企業使用模型檢測金融報告中的信息一致性。

產品特色:

幻覺檢測:評估答案是否忠實於給定文檔。

文本生成:基於用戶輸入的問題和文檔生成答案。

聊天格式訓練:模型以聊天格式進行訓練,適合對話式應用。

多數據集訓練:包括CovidQA、PubmedQA、DROP、RAGTruth等。

長序列處理:支持最大128000個token的序列長度。

開源許可:遵循cc-by-nc-4.0許可,可自由使用和修改。

高性能:在多個基準測試中表現優異,如HaluEval、RAGTruth等。

使用教程:

1. 準備問題、文檔和答案的輸入數據。

2. 使用模型推薦的prompt格式組織輸入數據。

3. 調用Hugging Face的pipeline接口,傳入模型名稱和配置參數。

4. 將準備好的數據作為用戶消息傳遞給pipeline。

5. 獲取模型輸出,包括'PASS'或'FAIL'的評分和推理。

6. 分析模型輸出,根據評分和推理判斷答案是否忠實於文檔。

7. 根據需要調整模型參數,優化性能。