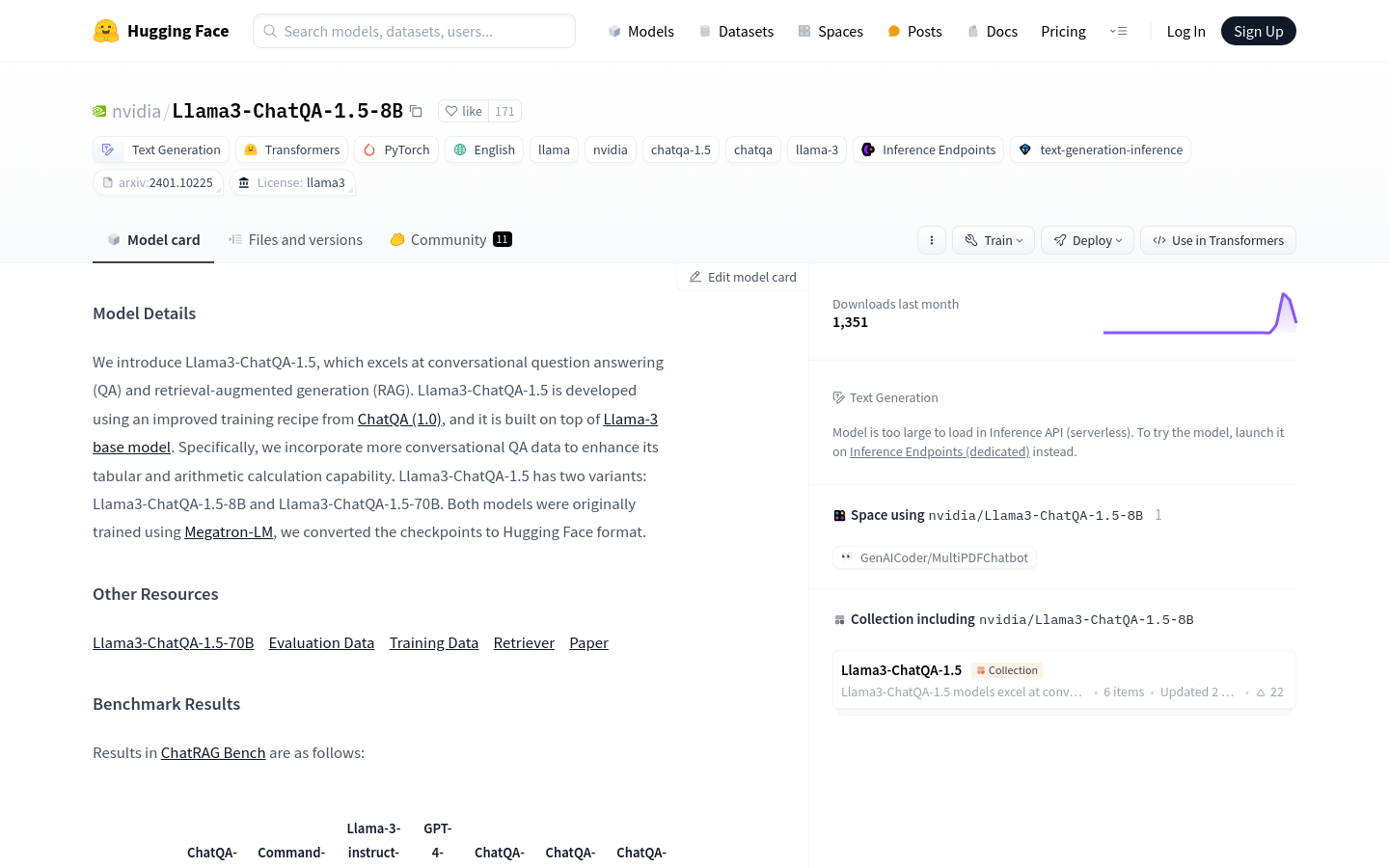

Llama3-ChatQA-1.5-8B是一款由NVIDIA 開發的高階對話問答和檢索增強生成模型。該模型基於ChatQA (1.0) 進行了改進,增加了對話問答數據,增強了表格和算術計算能力。它有兩種版本: Llama3-ChatQA-1.5-8B和Llama3-ChatQA-1.5-70B,兩者都採用Megatron-LM 訓練,並轉換為Hugging Face 格式。此模型在ChatRAG Bench 的基準測試中表現優異,適用於需要複雜對話理解和產生的場景。

需求人群

開發者:可以快速將該模型整合到聊天機器人和對話系統中。

企業用戶:可以在客戶服務和內部支援系統中使用,提高自動化程度和效率。

研究者:用於進行對話系統和自然語言處理的學術研究。

教育工作者:在教育軟體中集成,提供互動式學習體驗。

使用場景範例

客戶服務聊天機器人:自動回答客戶諮詢,提高服務效率。

智慧個人助理:幫助使用者管理日常任務,如日程安排和資訊檢索。

線上教育平台:提供個人化的學習體驗,透過對話形式進行互動教學。

產品特色

對話問答(QA):能夠理解並回答複雜的對話問題。

檢索增強生成(RAG):結合檢索到的信息進行文字生成。

增強的表格和算術計算能力:特別優化了處理表格資料和進行算術運算的能力。

多語言支援:支援英語等多種語言的對話理解與生成。

基於上下文的最佳化:在有上下文的情況下提供更準確的回答。

高效能:使用Megatron-LM 訓練,確保了模型的高效能。

易於整合:提供了Hugging Face 格式,方便開發者整合到各種應用中。

使用教程

1. 匯入必要的函式庫,如AutoTokenizer 和AutoModelForCausalLM。

2. 使用模型ID 初始化tokenizer 和模型。

3. 準備對話訊息和文件上下文。

4. 使用提供的prompt 格式建立輸入。

5. 將建構好的輸入傳遞給模型進行產生。

6. 取得模型產生的輸出並進行解碼。

7. 如果需要,請執行檢索以取得上下文資訊。

8. 根據檢索到的信息再次運行文字生成。