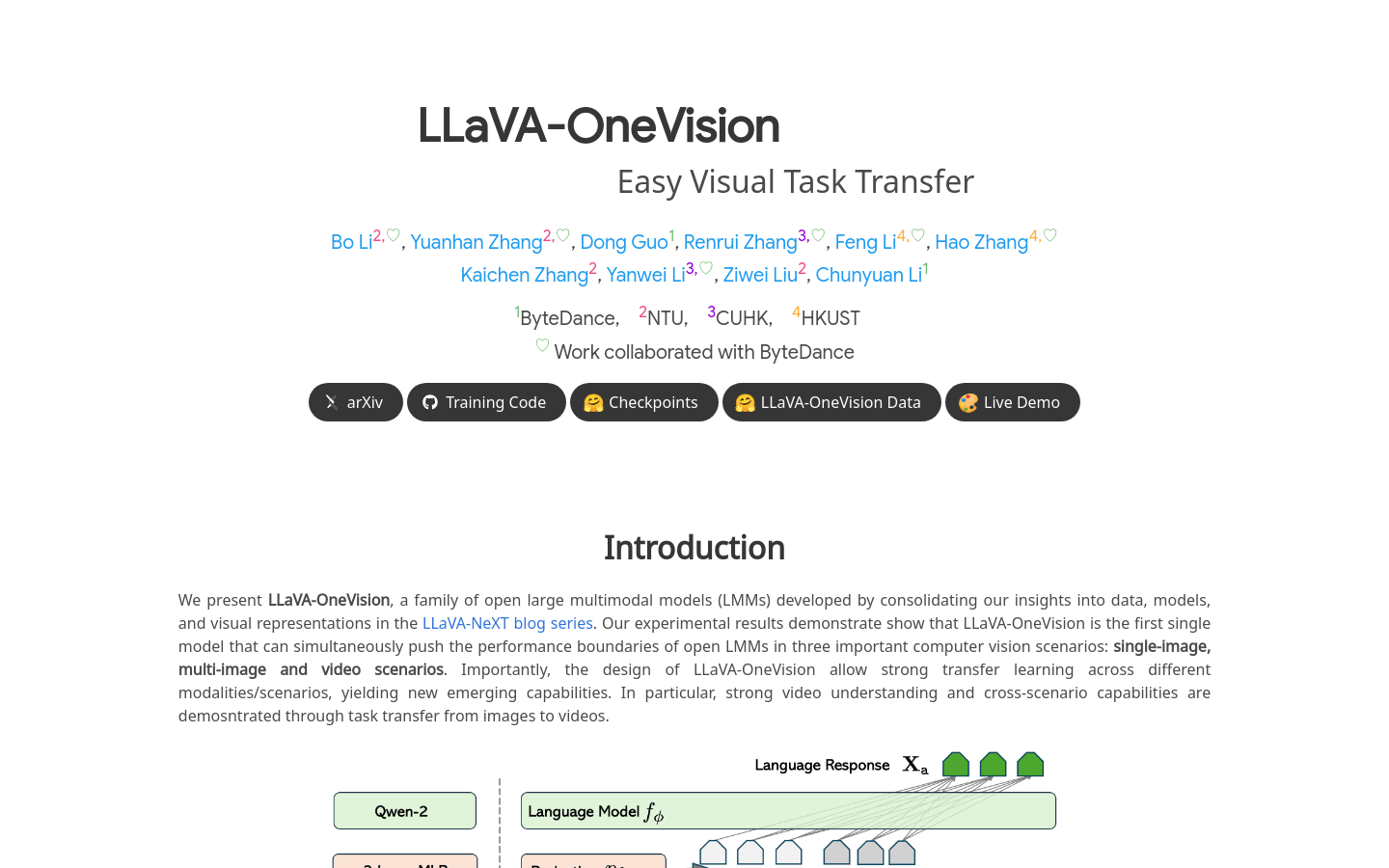

LLaVA-OneVision是一款由字節跳動公司與多所大學合作開發的多模態大型模型(LMMs),它在單圖像、多圖像和視頻場景中推動了開放大型多模態模型的性能邊界。該模型的設計允許在不同模態/場景之間進行強大的遷移學習,展現出新的綜合能力,特別是在視頻理解和跨場景能力方面,通過圖像到視頻的任務轉換進行了演示。

需求人群:

" LLaVA-OneVision的目標受眾是計算機視覺領域的研究人員和開發者,以及需要處理和分析大量視覺數據的企業。它適合那些尋求通過高級視覺識別和理解技術來提高產品或服務智能化水平的用戶。"

使用場景示例:

研究人員使用LLaVA-OneVision模型來提高自動駕駛車輛對周圍環境的理解能力。

開發者利用該模型在社交媒體平台上自動標記和描述用戶上傳的視頻內容。

企業採用LLaVA-OneVision來自動化分析監控視頻中的異常行為,提高安全監控的效率。

產品特色:

提供詳細的視頻內容中突出主題的描述

在圖像和視頻中識別相同的個體並理解其關係

將圖表和表格理解能力遷移到多圖像場景中,以連貫的方式解釋多張圖像

作為代理角色,識別iPhone上的多個屏幕截圖並與之交互,提供自動化任務的操作指令

展示優秀的標記提示能力,根據圖像中的數字標籤描述具體對象,突出其處理細粒度視覺內容的理解技能

基於靜態圖像生成詳細的視頻創作提示,將此能力從圖像到圖像的語言編輯生成中推廣到視頻

分析具有相同起始幀但不同結尾的視頻之間的差異

分析具有相似背景但不同前景對象的視頻之間的差異

在自動駕駛環境中分析和解釋多攝像機視頻素材

理解並詳細描述組合子視頻

使用教程:

訪問LLaVA-OneVision的開源頁面,了解模型的基本信息和使用條件。

下載訓練代碼和預訓練模型檢查點,根據需要選擇合適的模型規模。

探索訓練數據集,了解模型在單圖像和OneVision階段的訓練情況。

嘗試在線演示,親自體驗模型的功能和效果。

根據具體應用場景,調整模型參數,進行定制化的訓練和優化。