Magic 1-For-1是一個專注於高效視頻生成的模型,其核心功能是將文本和圖像快速轉換為視頻。該模型通過將文本到視頻的生成任務分解為文本到圖像和圖像到視頻兩個子任務,優化了內存使用並減少了推理延遲。其主要優點包括高效性、低延遲和可擴展性。該模型由北京大學DA-Group 團隊開發,旨在推動交互式基礎視頻生成領域的發展。目前該模型及相關代碼已開源,用戶可以免費使用,但需遵守開源許可協議。

需求人群:

"該模型適用於需要快速生成視頻內容的用戶,如視頻創作者、廣告製作人員、內容開發者等。它可以幫助用戶在短時間內生成高質量的視頻,節省時間和精力,提高創作效率。同時,其開源特性也適合研究人員和開發者進行進一步的開發和研究。"

使用場景示例:

視頻創作者可以使用該模型快速生成視頻素材,提高創作效率。

廣告製作人員可以利用該模型快速生成廣告視頻,節省製作成本。

研究人員可以基於該模型進行進一步的研究和開發,探索新的視頻生成技術。

產品特色:

高效的圖像到視頻生成,可在一分鐘內生成一分鐘的視頻。

支持文本到圖像和圖像到視頻的兩階段生成,優化內存使用和推理延遲。

提供量化功能,進一步優化模型性能。

支持單GPU 和多GPU 推理,靈活適應不同硬件環境。

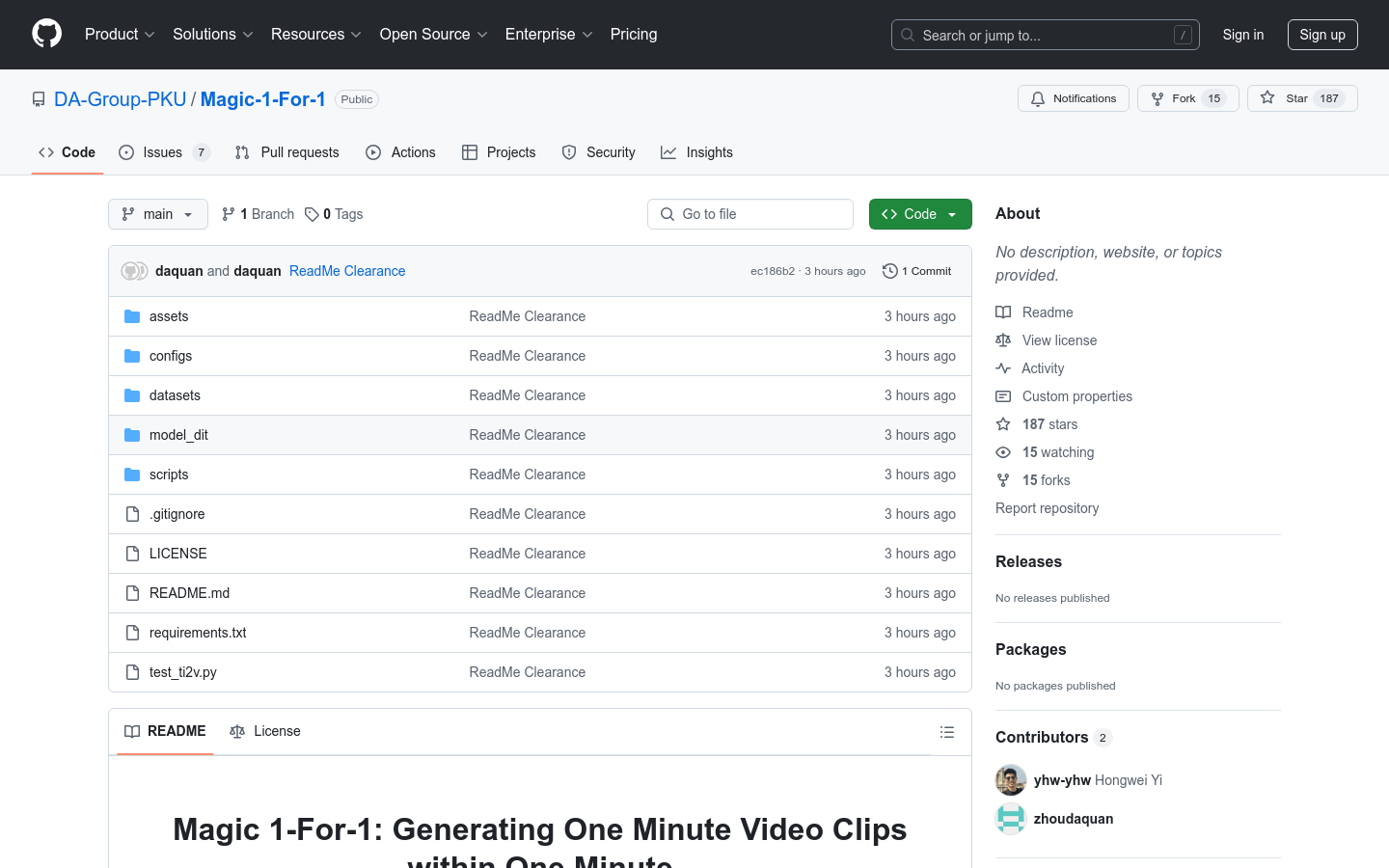

開源代碼和模型權重,方便用戶進行二次開發和研究。

提供詳細的使用文檔和腳本,方便用戶快速上手。

支持多種預訓練模型組件的下載和使用。

使用教程:

1. 安裝git-lfs,並使用conda 創建項目環境。

2. 安裝項目依賴,運行命令pip install -r requirements.txt。

3. 創建權重目錄pretrained_weights,並下載模型權重及相關組件。

4. 運行腳本python test_ti2v.py 或bash scripts/run_flashatt3.sh 進行推理。

5. 根據需要啟用量化功能或調整多GPU 配置。