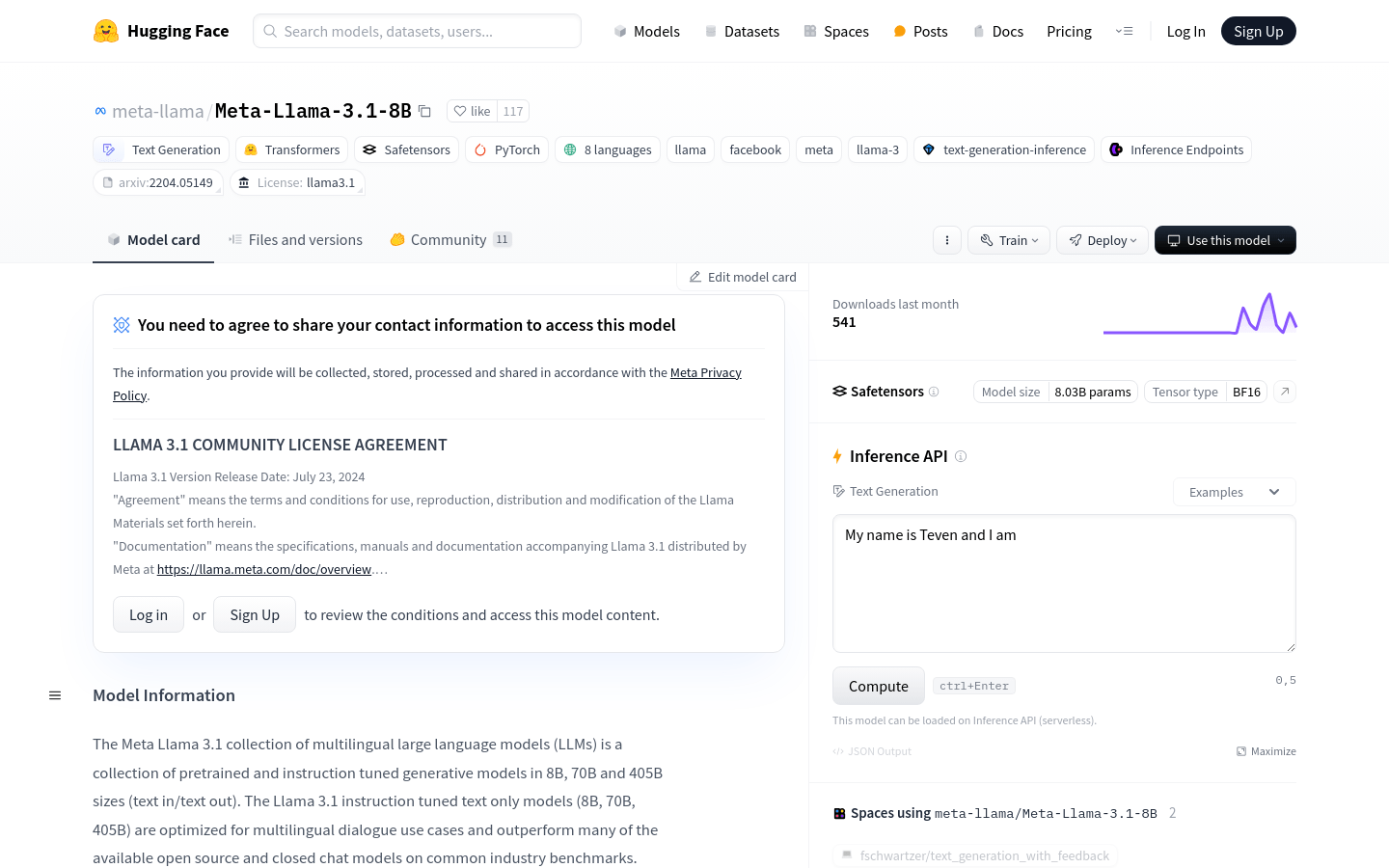

Meta Llama 3.1是一系列預訓練和指令調整的多語言大型語言模型(LLMs),包含8B、70B和405B大小的版本,支持8種語言,專為多語言對話用例優化,並在行業基準測試中表現優異。 Llama 3.1模型採用自回歸語言模型,使用優化的Transformer架構,並通過監督式微調(SFT)和強化學習結合人類反饋(RLHF)來提高模型的有用性和安全性。

需求人群:

"目標受眾為需要在多種語言環境下進行自然語言處理和對話系統開發的研究人員和開發者。該模型適合他們,因為它提供了多語言支持,能夠處理複雜的對話場景,並通過先進的訓練技術提高了模型的安全性和有用性。"

使用場景示例:

用於構建多語言聊天機器人,提供用戶諮詢和支持服務

集成到跨語言內容創作平台,輔助用戶生成符合目標語言文化的內容

作為多語言翻譯和語言理解的研究工具,推動自然語言處理領域的研究進展

產品特色:

支持8種語言的文本生成和對話能力

使用優化的Transformer架構,提高模型性能

通過監督式微調和強化學習結合人類反饋進行訓練,以符合人類偏好

支持多語言輸入和輸出,增強模型的多語言能力

提供靜態模型和經過指令調整的模型,以適應不同的自然語言生成任務

支持使用模型輸出來改進其他模型,包括合成數據生成和模型蒸餾

使用教程:

1. 安裝必要的庫和工具,如Transformers和PyTorch。

2. 使用pip命令更新Transformers庫到最新版本。

3. 導入Transformers庫和PyTorch庫,準備模型加載。

4. 通過指定模型ID加載Meta-Llama-3.1-8B模型。

5. 使用模型提供的pipeline或generate()函數進行文本生成或對話交互。

6. 根據需要調整模型參數,如設備映射和數據類型。

7. 調用模型生成文本或響應用戶輸入。