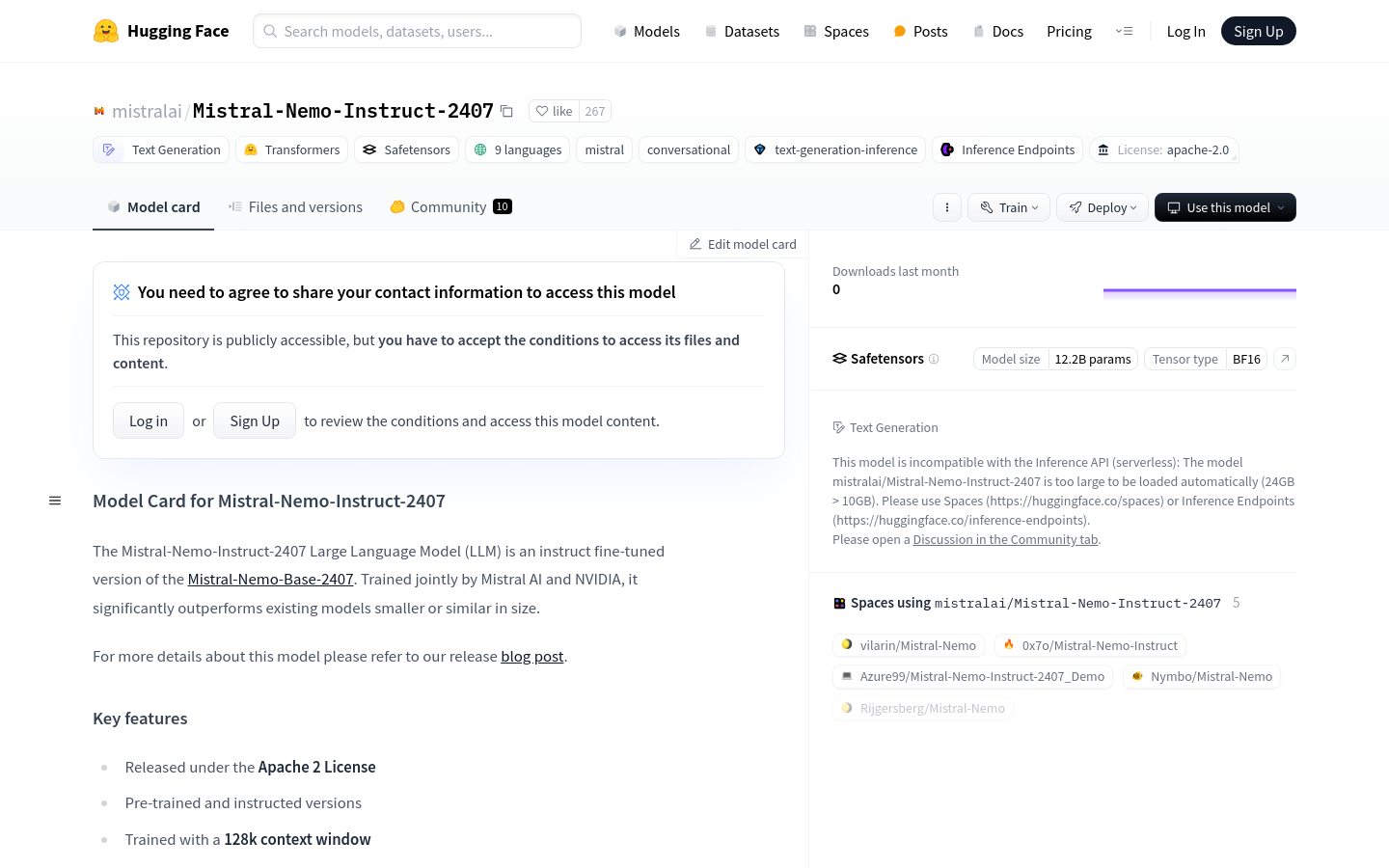

Mistral-Nemo-Instruct-2407

由Mistral AI和NVIDIA共同培訓的Mistral-Nemo-Instruct-2407模型在多語言和代碼數據方面擅長,提供了128K上下文窗口,並在各種基準測試中提供了出色的性能。

什麼是Mistral-Nemo-Instruct-2407 ?

Mistral-Nemo-Instruct-2407是Mistral AI和Nvidia開發的大型語言模型(LLM)。該模型是Mistral-Nemo-Base-2407的指導性微調版本。它經過多語言和代碼數據的培訓,大大優於類似或較小的模型。

關鍵功能:

支持對多語言和代碼數據的培訓

有一個128K上下文窗口

可以替換Mistral 7b

模型體系結構:

40層

5120尺寸

128個注意力頭

1436隱藏尺寸

每層32個注意力頭

8個鑰匙值注意力頭(GQA)

2^17詞彙大小(約128K)

旋轉嵌入(theta = 1m)

表現:

在Hellaswag,Winogrande和OpenBookQA等基準中優於其他模型

目標受眾:

需要處理大量文本和多語言數據的開發人員和研究人員

用法方案:

基於特定說明的文本生成

多語言環境中的機器翻譯

通過功能調用來檢索當前天氣信息

產品亮點:

經過多語言和代碼數據培訓

128K上下文窗口

強大的文本處理功能與其體系結構

各種基準的出色表現

入門指南:

1。安裝mistral_inference以確保與模型的兼容性

2。下載模型文件,包括params.json,consolidated.safetensors和tekken.json

3。使用Mistral-Chat CLI與模型相互作用

4。使用變壓器框架和管道功能生成文本

5。使用工具和功能類檢索當前的天氣信息

6。調整模型參數,例如溫度以優化輸出

7。有關詳細信息和使用限制,請參閱模型卡