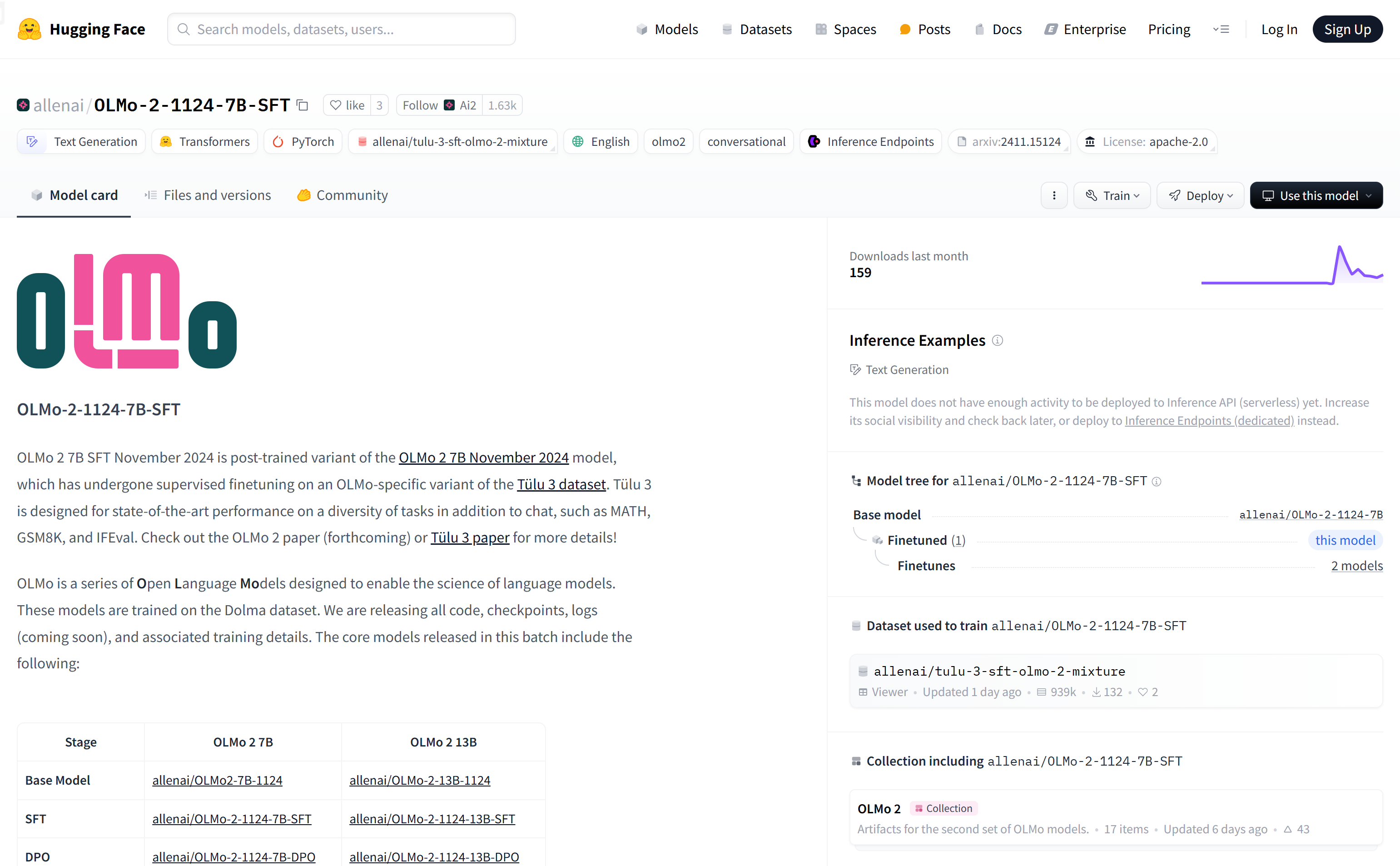

OLMo-2-1124-7B-SFT是由艾倫人工智能研究所(AI2)發布的一個英文文本生成模型,它是OLMo 2 7B模型的監督微調版本,專門針對Tülu 3數據集進行了優化。 Tülu 3數據集旨在提供多樣化任務的頂尖性能,包括聊天、數學問題解答、GSM8K、IFEval等。該模型的主要優點包括強大的文本生成能力、多樣性任務處理能力以及開源的代碼和訓練細節,使其成為研究和教育領域的有力工具。

需求人群:

"目標受眾為自然語言處理領域的研究人員、開發者以及對高性能文本生成有需求的教育工作者。該模型因其強大的生成能力和廣泛的應用場景,特別適合需要處理複雜語言任務和進行模型研究的用戶。"

使用場景示例:

案例一:研究人員使用OLMo-2-1124-7B-SFT模型進行聊天機器人的開發,以提高對話的自然度和準確性。

案例二:教育機構利用該模型生成教學材料,如數學問題的解答和解釋,以輔助教學。

案例三:開發者將模型集成到他們的應用程序中,以提供用戶生成內容的自動審核和生成建議。

產品特色:

• 基於大規模數據集訓練,提供高質量的文本生成能力

• 支持多種自然語言處理任務,包括聊天、數學問題解答等

• 開源代碼和訓練細節,便於研究和進一步開發

• 經過監督微調,提高了模型在特定任務上的性能

• 支持Hugging Face平台,易於加載和使用

• 適用於研究和教育,推動語言模型的科學發展

使用教程:

1. 訪問Hugging Face平台並蒐索OLMo-2-1124-7B-SFT模型。

2. 使用提供的代碼片段加載模型:`from transformers import AutoModelForCausalLM; olmo_model = AutoModelForCausalLM.from_pretrained("allenai/ OLMo-2-1124-7B-SFT ")`。

3. 根據需要設置系統提示(system prompt),定義模型的角色和功能。

4. 利用模型進行文本生成或其他自然語言處理任務。

5. 根據模型輸出調整參數,優化性能。

6. 將模型集成到更大的系統中,如聊天機器人或內容生成平台。

7. 遵循開源許可協議,合理使用模型,並在研究中引用相關論文。