OneGen

" OneGen :高效統一生成與檢索框架,降低部署成本,加速NLP任務推理。"

什么是 OneGen?

OneGen 是一个专为大型语言模型(LLMs)设计的创新框架,它能够在单次操作中同时完成生成和检索任务。通过将这两种任务整合到同一个上下文中,OneGen 显著提高了效率,降低了部署和推理成本,是自然语言处理领域的一项突破性技术。

谁适合使用 OneGen?

OneGen 主要面向自然语言处理领域的研究人员和开发者。如果你对大型语言模型的生成和检索任务感兴趣,或者希望优化模型训练和推理过程,减少资源消耗,OneGen 将是你的理想选择。

OneGen 的使用场景

实体链接:快速识别文本中的实体,提高信息处理的准确性。

单跳问答:直接生成准确的答案,提升问答系统的响应速度。

多跳问答:通过模型的推理过程,找到复杂问题的答案。

OneGen 的产品特色

统一处理生成和检索任务:简化操作流程,降低部署成本。

单次前向传递计算:避免重复计算,减少推理成本。

多功能支持:适用于实体链接、单跳问答和多跳问答等多种任务。

预训练模型:提供下载,方便用户快速上手。

灵活配置:支持从零开始训练模型,满足不同需求。

详细评估脚本:帮助用户准确评估模型性能。

如何使用 OneGen?

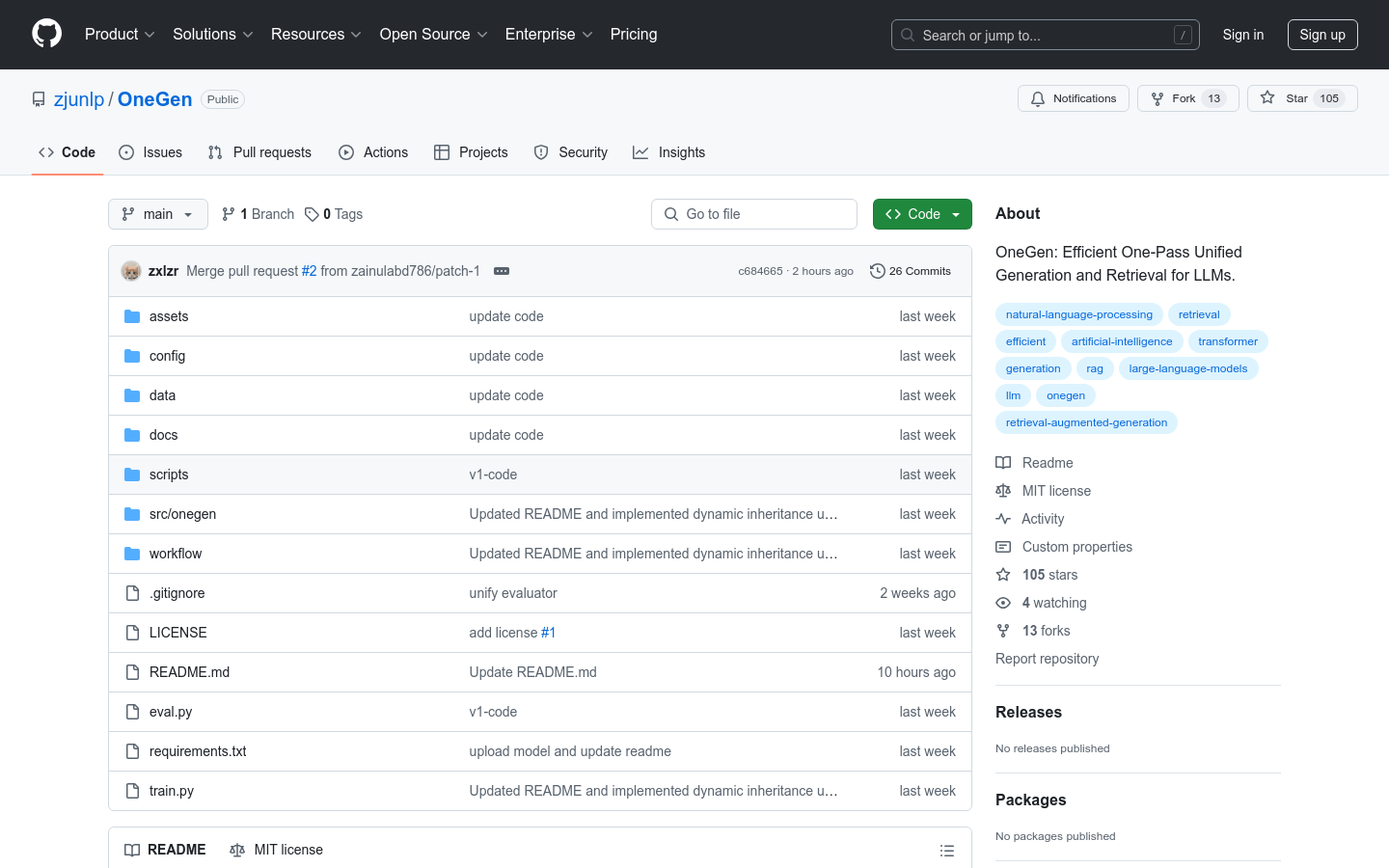

1. 克隆仓库:将 OneGen 仓库克隆到你的本地环境。

2. 创建虚拟环境:建立并激活 Python 虚拟环境。

3. 安装依赖:安装所有必要的依赖包。

4. 准备数据集:下载并解压数据集,为训练或推理做好准备。

5. 下载预训练模型(可选):根据需要下载预训练模型。

6. 配置模型:设置模型参数和路径。

7. 运行推理:执行推理脚本,进行模型预测。

8. 评估性能:使用评估脚本,评估模型的表现。

OneGen 通过这些步骤,为用户提供了一个高效、灵活且成本效益高的解决方案,帮助他们在自然语言处理领域取得更好的成果。