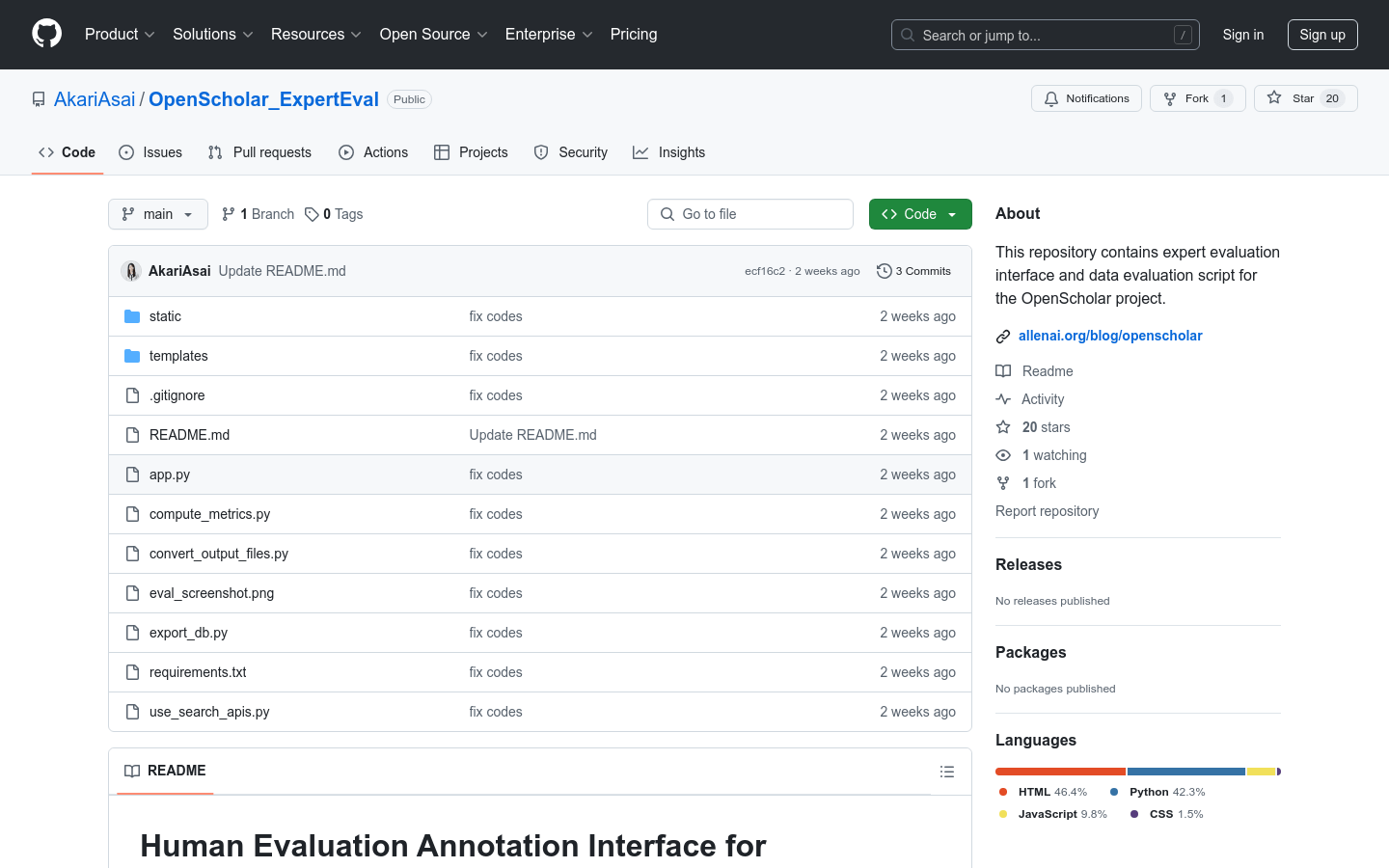

OpenScholar_ExpertEval是一個用於專家評估和數據評估的界面和腳本集合,旨在支持OpenScholar項目。該項目通過檢索增強型語言模型合成科學文獻,對模型生成的文本進行細緻的人工評估。產品背景基於AllenAI的研究項目,具有重要的學術和技術價值,能夠幫助研究人員和開發者更好地理解和改進語言模型。

需求人群:

"目標受眾為研究人員、開發者和教育工作者,特別是那些在自然語言處理和機器學習領域工作的專業人士。該產品適合他們,因為它提供了一個平台來評估和改進語言模型的性能,特別是在科學文獻合成方面。"

使用場景示例:

研究人員使用該工具來評估不同語言模型生成的科學文獻的準確性和可靠性。

教育工作者可以利用該工具來教授學生如何評估AI生成的內容。

開發者可以利用該工具來測試和改進他們自己的語言模型。

產品特色:

提供人工評估標註界面:用於專家對模型生成的文本進行評估。

支持RAG評估:能夠對檢索增強型生成模型進行評估。

細粒度評估:允許專家進行更細緻的評估。

數據準備:需要將評估實例放入指定文件夾,支持JSONL格式。

結果數據庫存儲:評估結果默認存儲在本地數據庫文件中。

結果導出:支持將評估結果導出為Excel文件。

評估指標計算:提供腳本計算評估指標和一致性。

界面分享:支持在雲服務上部署,以便分享評估界面。

使用教程:

1. 安裝環境:按照README中的指南創建並激活虛擬環境,並安裝依賴。

2. 準備數據:將評估實例放入`data`文件夾中,每個實例應包含提示和兩個模型的完成結果。

3. 運行應用:使用`python app.py`命令啟動評估界面。

4. 訪問界面:在瀏覽器中打開`http://localhost:5001`來訪問評估界面。

5. 評估結果:評估完成後,可以在`http://localhost:5001/summary`查看進度。

6. 結果導出:使用`python export_db.py`命令將評估結果導出為Excel文件。

7. 計算指標:使用`python compute_metrics.py`命令計算評估指標和一致性。