Phi-4-multimodal-instruct 是微软开发的多模态基础模型,支持文本、图像和音频输入,生成文本输出。该模型基于Phi-3.5和Phi-4.0的研究和数据集构建,经过监督微调、直接偏好优化和人类反馈强化学习等过程,以提高指令遵循能力和安全性。它支持多种语言的文本、图像和音频输入,具有128K的上下文长度,适用于多种多模态任务,如语音识别、语音翻译、视觉问答等。该模型在多模态能力上取得了显著提升,尤其在语音和视觉任务上表现出色。它为开发者提供了强大的多模态处理能力,可用于构建各种多模态应用。

需求人群:

"该模型适合需要多模态处理能力的开发者和研究人员,可用于构建多语言、多模态的AI应用,如语音助手、视觉问答系统、多模态内容生成等。它能够处理复杂的多模态任务,提供高效的解决方案,尤其适合对性能和安全性有较高要求的场景。"

使用场景示例:

作为语音助手,为用户提供多语言语音翻译和语音问答服务

在教育领域,通过视觉和语音输入辅助学生学习数学和科学知识

用于内容创作,根据图像或音频输入生成相关的文本描述

产品特色:

支持文本、图像和音频输入,生成文本输出

支持多种语言的文本(如英语、中文、法语等)和音频(如英语、中文、德语等)

具备强大的自动语音识别和语音翻译能力,超越现有专家模型

能够处理多图像输入,支持视觉问答、图表理解等任务

支持语音总结和语音问答,提供高效的音频处理能力

使用教程:

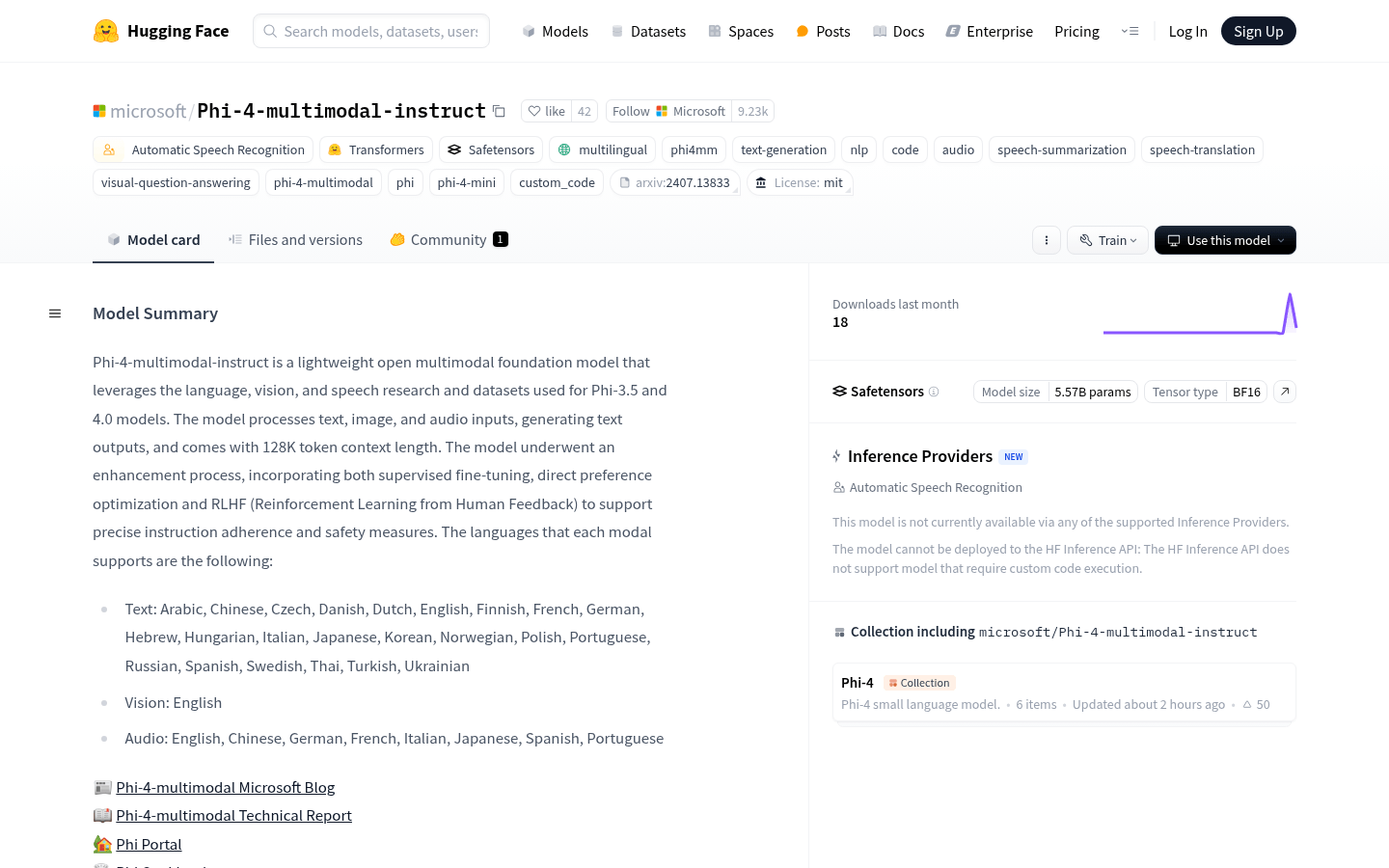

1. 访问 Hugging Face 网站,找到 Phi-4-multimodal-instruct 模型页面

2. 根据需求选择合适的输入格式(文本、图像或音频)

3. 使用模型的 API 或本地加载模型进行推理

4. 对于图像输入,将图像转换为支持的格式并上传

5. 对于音频输入,确保音频格式符合要求,并指定任务(如语音识别或翻译)

6. 提供提示文本(如问题或指令),模型将生成相应的文本输出

7. 根据输出结果进行进一步处理或应用