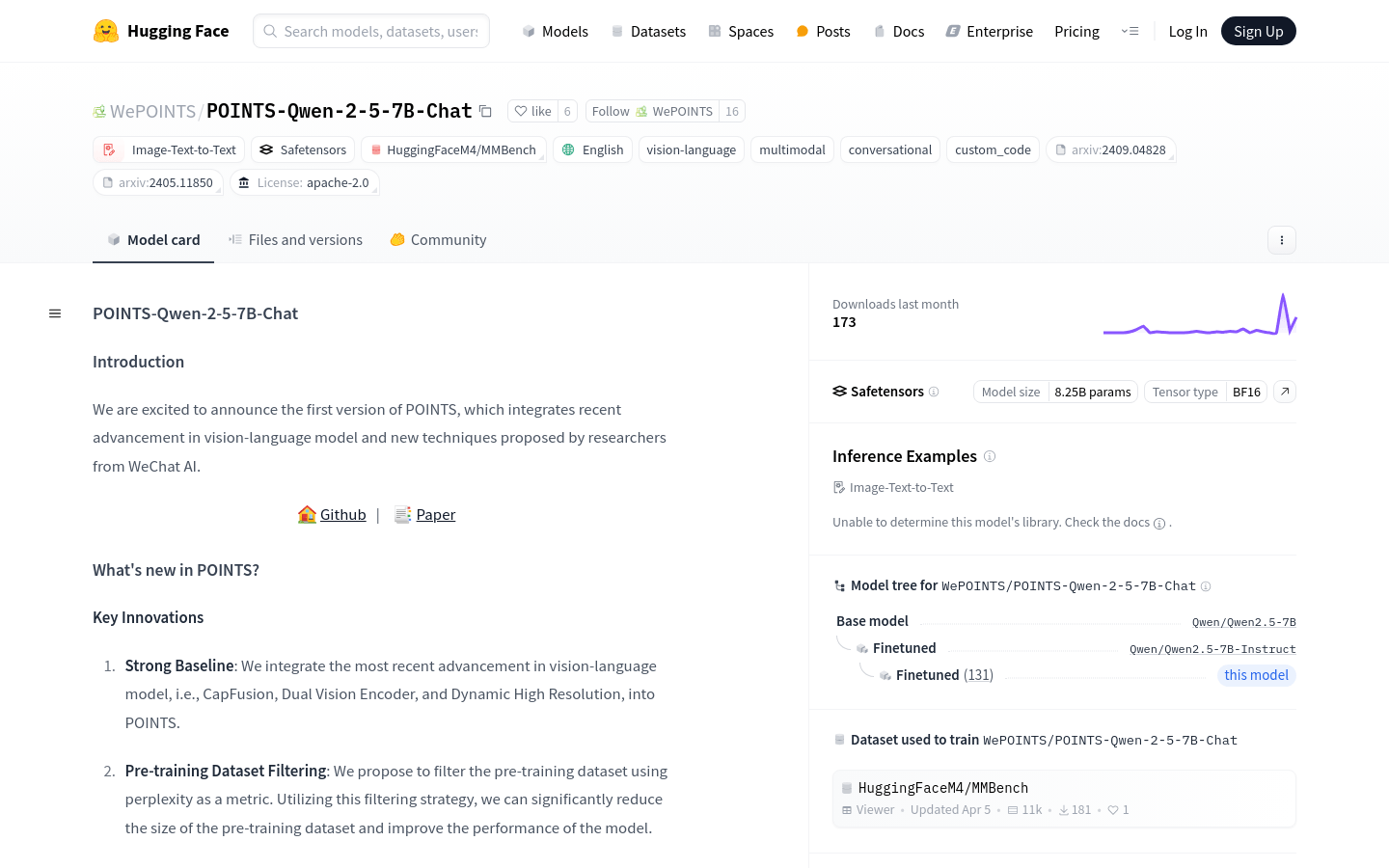

POINTS-Qwen-2-5-7B-Chat是一个集成了视觉语言模型最新进展和新技巧的模型,由微信AI的研究人员提出。它通过预训练数据集筛选、模型汤等技术,显著提升了模型性能。这个模型在多个基准测试中表现优异,是视觉语言模型领域的一个重要进步。

需求人群:

"目标受众为研究人员、开发者和企业用户,他们需要利用先进的视觉语言模型来处理图像和文本数据,提升产品的智能交互能力。POINTS-Qwen-2-5-7B-Chat因其高性能和易用性,特别适合需要处理大量视觉语言数据的AI项目。"

使用场景示例:

利用模型描述图像细节,如风景、人物或物体。

在教育领域,用于图像识别和描述,辅助教学。

在商业领域,用于客户服务中的图像识别和响应。

产品特色:

集成最新的视觉语言模型技术,如CapFusion、Dual Vision Encoder和Dynamic High Resolution。

采用困惑度作为筛选预训练数据集的指标,有效减少数据集大小,提升模型性能。

应用模型汤技术,对不同视觉指令调整数据集微调后的模型进行整合,进一步提升性能。

在多个基准测试中表现优异,如MMBench-dev-en、MathVista等。

支持多模态和对话功能,适用于图像文本到文本的任务。

模型参数量大,达到8.25B,使用BF16张量类型。

提供详细的使用示例和社区讨论,便于用户学习和交流。

使用教程:

1. 导入必要的库和模块,包括transformers、PIL、torch等。

2. 获取图像URL,并通过requests获取图像数据。

3. 使用PIL库打开图像数据,准备提示文本。

4. 指定模型路径,并从预训练模型加载tokenizer和model。

5. 设置图像处理器和生成配置,包括最大新令牌数、温度、top_p等。

6. 使用model.chat方法,传入图像、提示文本、tokenizer、图像处理器等参数,进行模型交互。

7. 输出模型的响应结果。