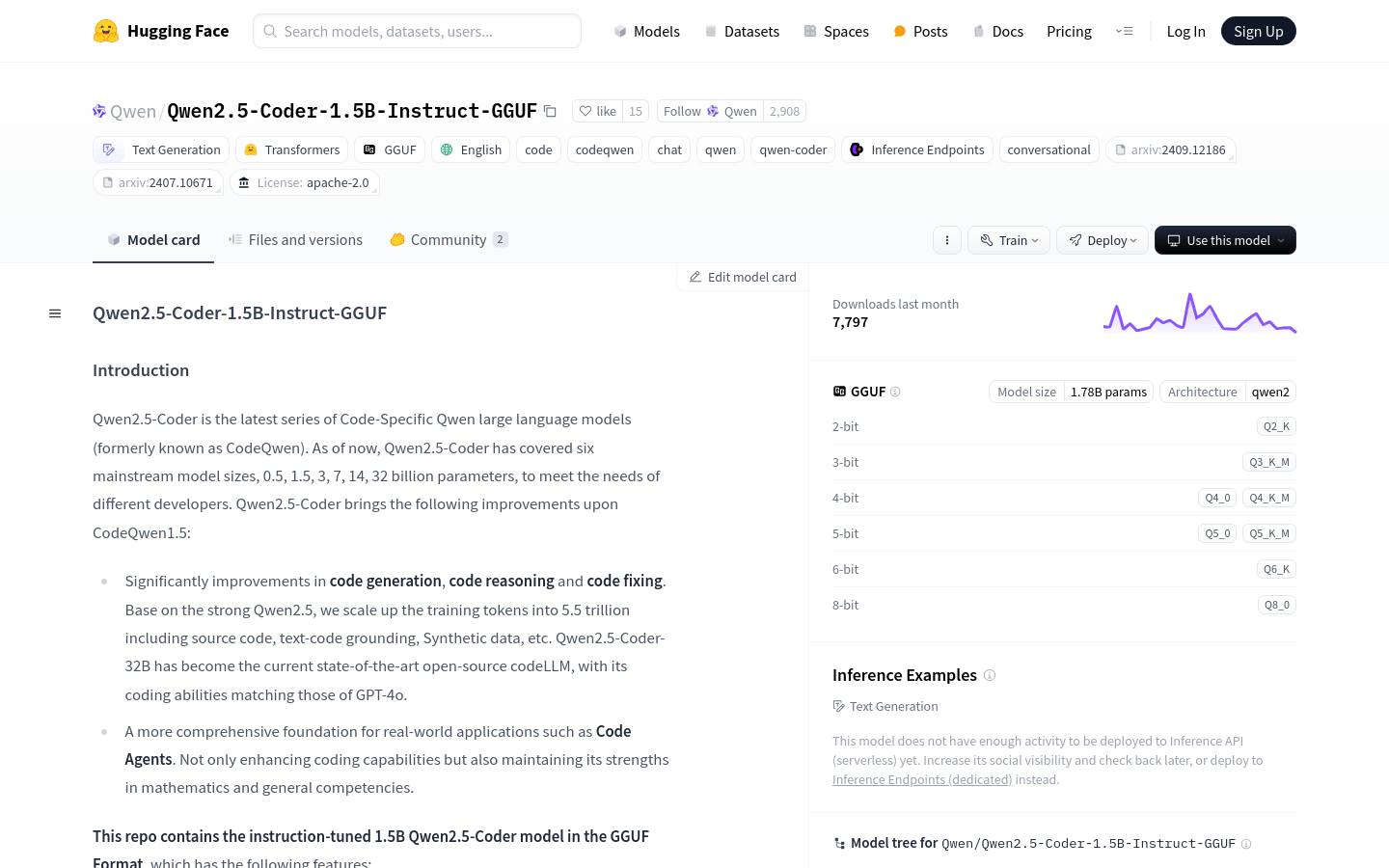

Qwen2.5-Coder是Qwen大型語言模型的最新系列,專為代碼生成、代碼推理和代碼修復而設計。基於強大的Qwen2.5,通過增加訓練令牌至5.5萬億,包括源代碼、文本代碼基礎、合成數據等,Qwen2.5-Coder-32B已成為當前最先進的開源代碼大型語言模型,其編碼能力與GPT-4o相匹配。此模型是1.5B參數的指令調優版本,採用GGUF格式,具有因果語言模型、預訓練和後訓練階段、transformers架構等特點。

需求人群:

"目標受眾為開發者和編程人員,特別是那些需要在項目中快速生成、理解和修復代碼的專業人士。Qwen2.5-Coder通過提供強大的代碼生成和推理能力,幫助開發者提高工作效率,減少編碼錯誤,加速開發流程。"

使用場景示例:

開發者使用Qwen2.5-Coder自動補全代碼,提高編碼效率。

在代碼審查過程中,利用Qwen2.5-Coder識別潛在的代碼缺陷和錯誤。

教育環境中,Qwen2.5-Coder作為教學工具,幫助學生理解和學習編程概念。

產品特色:

代碼生成:顯著提升代碼生成能力,包括源代碼生成、文本代碼基礎和合成數據。

代碼推理:增強模型對代碼邏輯和結構的理解能力。

代碼修復:提高模型識別和修復代碼中錯誤和缺陷的能力。

全面應用:適用於實際應用場景,如代碼代理,不僅增強編碼能力,還保持數學和通用能力。

模型參數:1.54B參數,其中非嵌入參數為1.31B,28層,12個注意力頭用於Q,2個用於KV。

上下文長度:支持完整的32,768個token,是目前支持長序列處理的模型之一。

量化:支持多種量化級別,如q2_K, q3_K_M, q4_0, q4_K_M, q5_0, q5_K_M, q6_K, q8_0。

使用教程:

1. 安裝huggingface_hub和llama.cpp,以便下載和運行模型。

2. 使用huggingface-cli下載所需的GGUF文件。

3. 根據官方指南安裝llama.cpp,並確保跟隨最新版本。

4. 使用llama-cli啟動模型,並通過指定的命令行參數進行配置。

5. 在聊天模式下運行模型,以實現類似聊天機器人的交互體驗。

6. 根據需要調整參數,如GPU內存和吞吐量,以適應不同的使用場景。