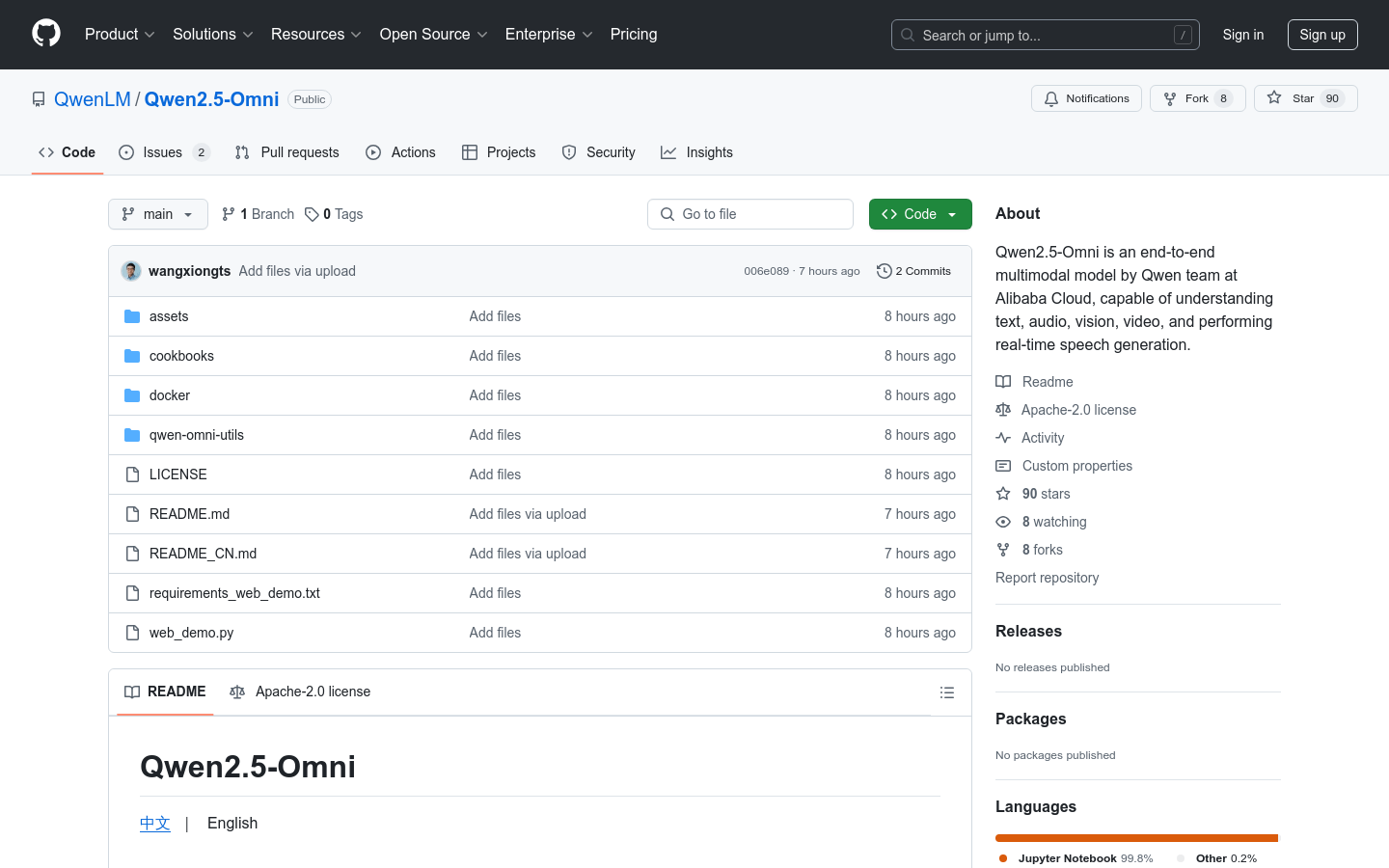

Qwen2.5-Omni是阿里云通義千問團隊推出的新一代端到端多模態旗艦模型。該模型專為全方位多模態感知設計,能夠無縫處理文本、圖像、音頻和視頻等多種輸入形式,並通過實時流式響應同時生成文本與自然語音合成輸出。其創新的Thinker-Talker 架構和TMRoPE 位置編碼技術,使其在多模態任務中表現出色,特別是在音頻、視頻和圖像理解方面。該模型在多個基準測試中超越了類似規模的單模態模型,展現了強大的性能和廣泛的應用潛力。目前, Qwen2.5-Omni已在Hugging Face、ModelScope、DashScope 和GitHub 上開源開放,為開發者提供了豐富的使用場景和開發支持。

需求人群:

"該模型適合開發者、研究人員、企業和任何需要處理多模態數據的用戶。它能夠幫助開發者快速構建多模態應用,如智能客服、虛擬助手、內容創作工具等,同時也為研究人員提供了強大的工具來探索多模態交互和人工智能的前沿領域。"

使用場景示例:

在智能客服場景中, Qwen2.5-Omni可以實時理解客戶通過語音或文字提出的問題,並以自然語音和文本的形式給出準確回答。

在教育領域,該模型可以用於開發互動式學習工具,通過語音講解和圖像展示相結合的方式,幫助學生更好地理解知識。

在內容創作方面, Qwen2.5-Omni可以根據輸入的文本或圖像生成相關的視頻內容,為創作者提供創意靈感和素材。

產品特色:

全能創新架構:採用Thinker-Talker 架構,Thinker 模塊負責處理多模態輸入並生成高層語義表徵及對應文本內容,Talker 模塊則以流式方式接收Thinker 輸出的語義表徵與文本,流暢合成離散語音單元,實現多模態輸入與語音輸出的無縫銜接。

實時音視頻交互:支持完全實時交互,能夠處理分塊輸入並即時輸出結果,適用於實時對話、視頻會議等需要即時反饋的場景。

自然流暢的語音生成:在語音生成的自然性和穩定性方面表現出色,超越了許多現有的流式和非流式替代方案,能夠生成高質量的自然語音。

全模態性能優勢:在同等規模的單模態模型進行基準測試時,展現出卓越的性能,特別是在音頻和視頻理解方面,優於類似大小的Qwen2-Audio 和Qwen2.5-VL-7B 等模型。

卓越的端到端語音指令跟隨能力:在端到端語音指令跟隨方面表現出與文本輸入處理相媲美的效果,在通用知識理解和數學推理等基準測試中表現優異,能夠準確理解和執行語音指令。

使用教程:

訪問Qwen Chat或Hugging Face等平台,選擇Qwen2.5-Omni模型。

在平台上創建一個新的會話或項目,輸入需要處理的文本、上傳圖像、音頻或視頻文件。

根據需求選擇模型的輸出方式,如文本生成、語音合成等,並設置相關參數(如語音類型、輸出格式等)。

點擊運行或生成按鈕,模型將實時處理輸入數據並生成結果。

查看生成的文本、語音或視頻結果,並根據需要進行進一步的編輯或使用。