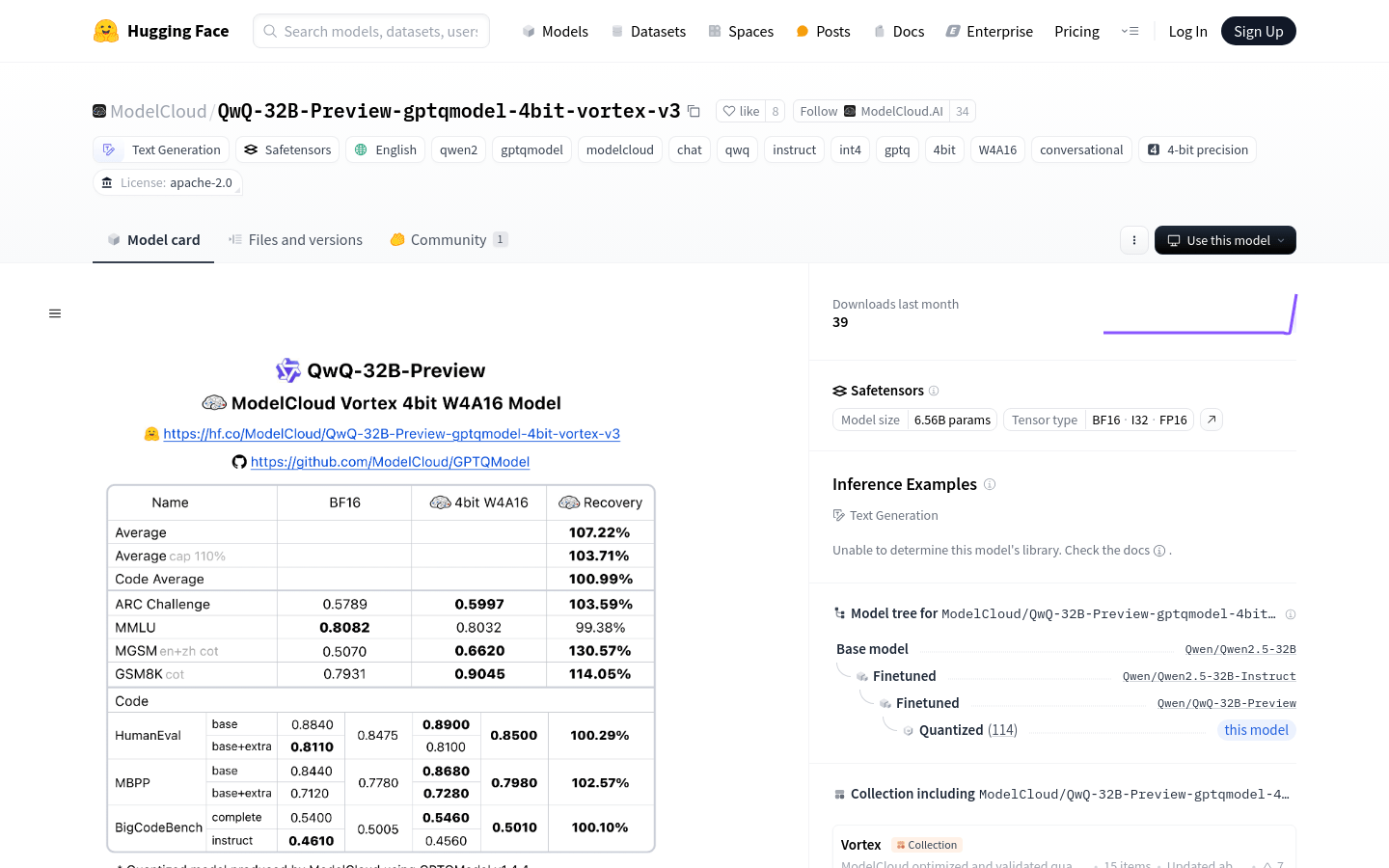

QwQ-32B-Preview-gptqmodel-4bit-vortex-v3

QwQ-32B-Preview-gptqmodel 4bit vortex v3 提供先進的 4 位元量化功能,可實現高效的大型語言模型部署,從而增強效能並降低計算成本。

产品介绍

这是一个基于Qwen2.5-32B的4位量化语言模型,利用GPTQ技术实现高效推理和低资源消耗。它在保持高性能的同时,显著降低了存储和计算需求,非常适合资源有限的环境。该模型主要用于需要高性能语言生成的应用,例如智能客服,编程辅助和内容创作。开源许可和灵活的部署方式使其在商业和研究领域拥有广泛的应用前景。

目标用户

该产品适合需要高性能语言生成的开发者和企业,尤其是在资源消耗敏感的场景,例如智能客服,编程辅助工具和内容创作平台。高效的量化技术和灵活的部署方式使其成为理想选择。

使用场景示例

智能客服系统:快速生成自然语言回复,提升客户满意度

开发者工具:生成代码片段或优化建议,提高编程效率

内容创作平台:生成创意文本,例如故事,文章或广告文案

产品特色

支持4位量化,显著降低模型存储和计算需求

基于GPTQ技术,实现高效推理和低延迟响应

支持多语言文本生成,适用范围广

提供灵活的API接口,方便开发者集成和部署

开源许可,允许自由使用和二次开发

支持多种推理框架,例如PyTorch和Safetensors

提供详细的模型卡和使用示例,易于上手

支持多平台部署,包括云端和本地服务器

使用教程

1 下载模型文件和依赖库,访问Hugging Face页面

2 使用AutoTokenizer加载模型的分词器

3 加载GPTQModel模型,指定模型路径

4 构建输入文本,使用分词器转换为模型输入格式

5 调用模型的generate方法,生成文本输出

6 使用分词器解码输出结果,获取最终生成的文本

7 根据需求进一步处理或应用生成的文本