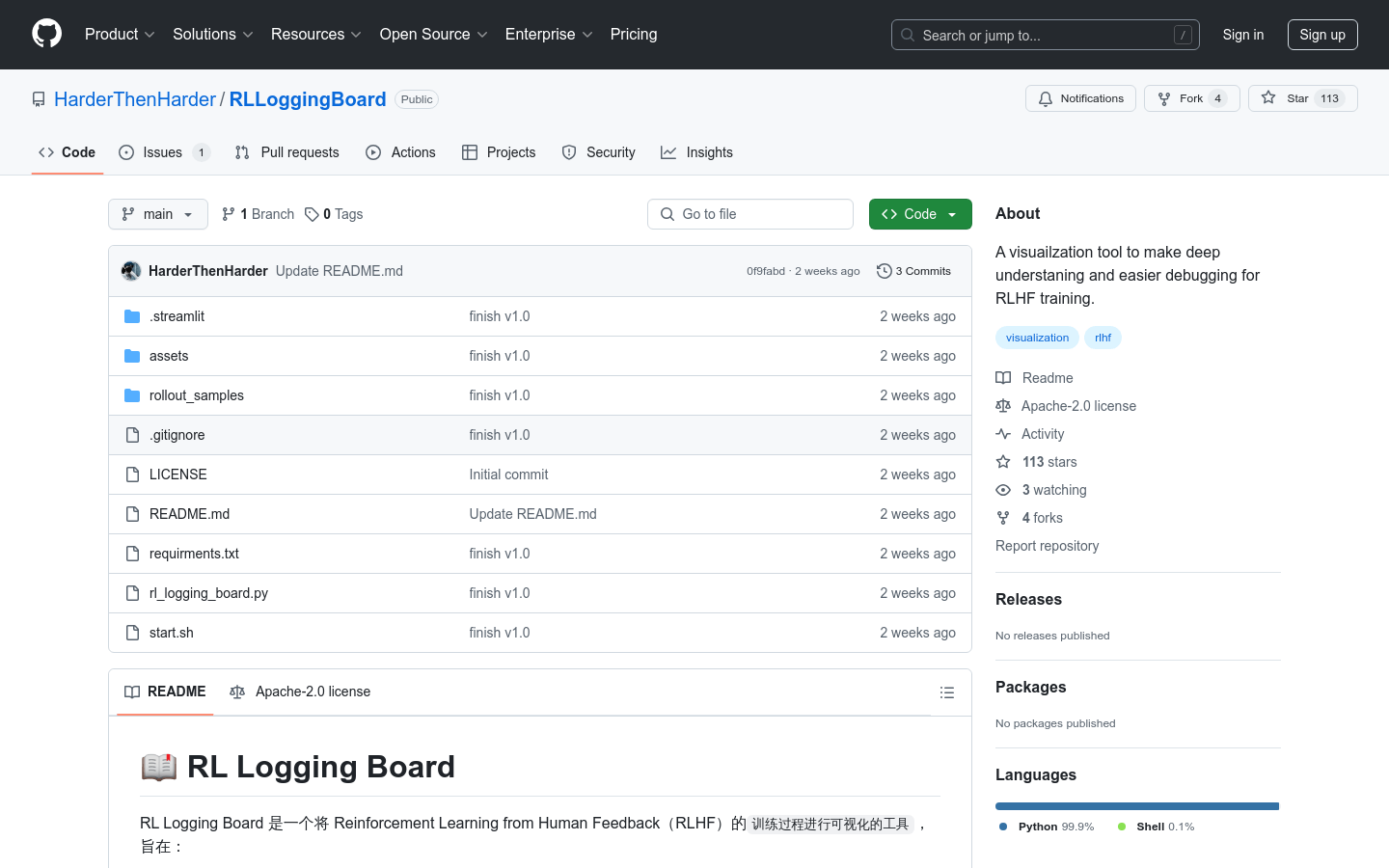

RLLoggingBoard :強化學習人體回饋訓練過程視覺化工具

介紹

RLLoggingBoard是一款專注於強化學習人類回饋(RLHF)訓練過程視覺化的工具。它透過細粒度的指標監控,幫助研究人員和開發者更直觀地理解訓練過程,快速定位問題,並優化訓練效果。該工具支援多種視覺化模組,包括獎勵曲線、反應排序和token 等級指標等,旨在輔助現有的訓練框架,提升訓練效率和效果。

目標用戶

該產品適合從事強化學習研究與開發的專業人員,尤其是需要對RLHF 訓練過程進行深度監控和調試的開發者。它幫助他們快速定位問題,優化訓練策略,提升模型表現。

使用場景範例

押韻任務:透過視覺化工具分析模型產生的詩句是否符合押韻要求,優化訓練過程。

對話生成任務:監控模型產生的對話質量,透過獎勵分佈分析模型的收斂性。

文字產生任務:透過token 層級指標監控,發現並解決模型生成文字中的異常token 問題。

產品特色

獎勵區域視覺化:展示訓練曲線、得分分佈及與參考模型的獎勵差異。

反應區域視覺化:依獎勵、KL 散度等指標排序,分析每個樣本的特徵。

Token 等級監控:展示每個token 的獎勵、價值、機率等細粒度指標。

支援多種訓練框架:與訓練框架解耦,可適應任何保存所需指標的框架。

資料格式靈活:支援.jsonl 檔案格式,方便與現有訓練流程整合。

可選的參考模型比較:支援保存參考模型的指標,進行RL 模型與參考模型的比較分析。

直觀發現潛在問題:透過視覺化手段快速定位訓練中的異常樣本和問題。

支援多種視覺化模組:提供豐富的視覺化功能,滿足不同監控需求。

使用教程

1. 在訓練框架中將所需的指標資料保存到.jsonl 檔案中。

2. 將資料檔案儲存到指定的目錄下。

3. 安裝工具所需的依賴套件(執行pip install -r requirements.txt)。

4. 運行啟動腳本(bash start.sh)。

5. 透過瀏覽器存取視覺化介面,選擇資料資料夾進行分析。

6. 使用視覺化模組查看獎勵曲線、回應排序和token 等級指標等。

7. 根據視覺化結果分析訓練過程中的問題,並優化訓練策略。

8. 持續監控訓練過程,確保模型效能符合預期。