什么是 UI-TARS-7B-SFT?

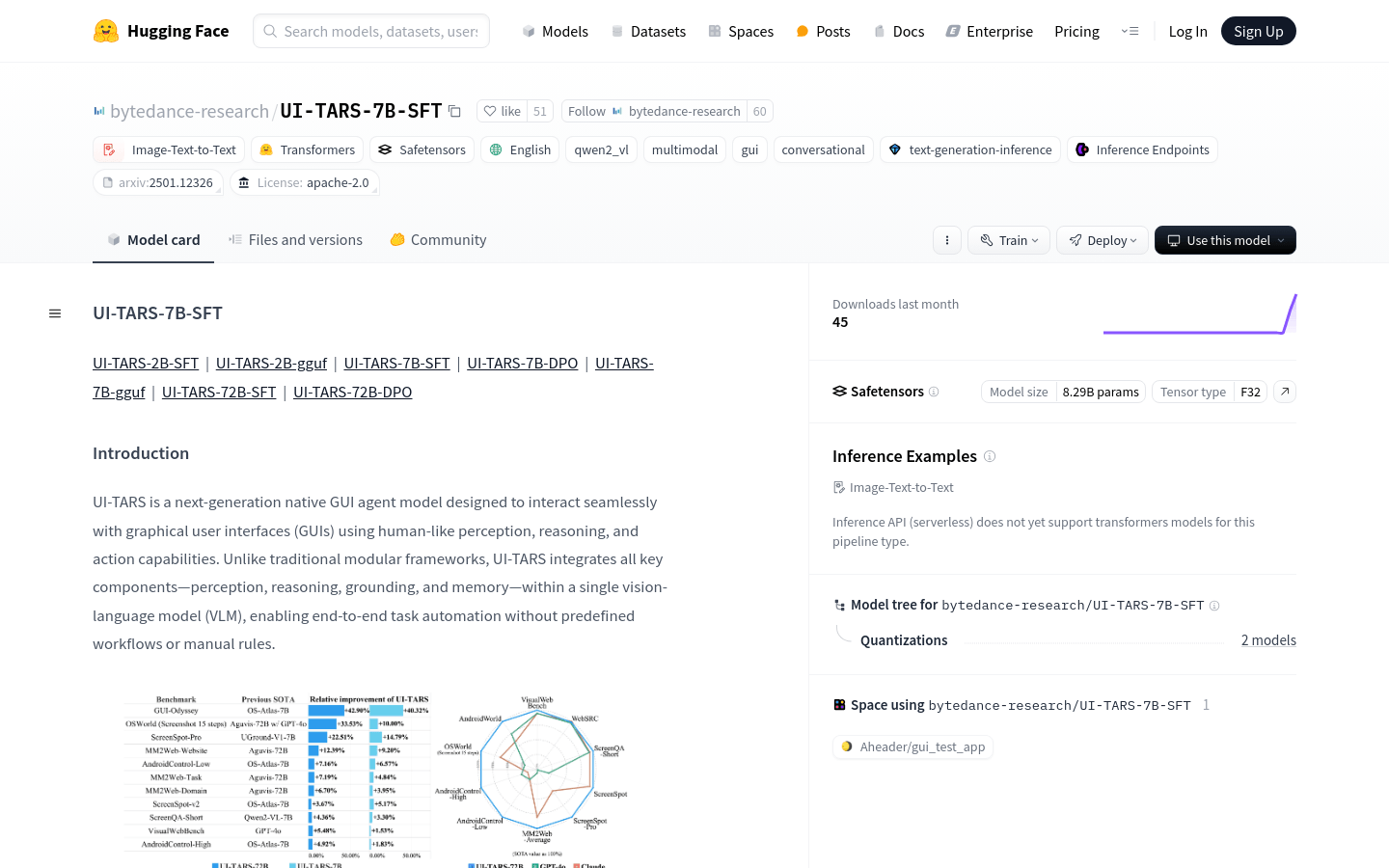

UI-TARS-7B-SFT 是字节跳动研究团队开发的一款革命性的图形用户界面(GUI)自动化模型。它通过模拟人类的感知、推理和行动能力,实现了与各种软件界面的无缝交互。这款模型的核心优势在于其强大的多模态交互能力和高精度的视觉感知,使其能够在无需预定义工作流的情况下,自动完成复杂的任务。

需求人群:

UI-TARS-7B-SFT 主要面向需要高效处理大量GUI交互任务的企业和开发者。无论是自动化测试、智能办公还是智能客服,这款模型都能显著提升工作效率,降低人力成本。此外,对于智能驾驶、智能家居等需要多模态交互的场景,UI-TARS-7B-SFT 也能提供更加自然、便捷的用户体验。

使用场景示例:

1. 自动化测试:UI-TARS-7B-SFT 可以自动识别和操作界面元素,完成复杂的测试任务,确保软件质量。

2. 智能办公:在办公环境中,模型可以根据用户的指令自动操作办公软件,如生成报告、整理数据等,大幅提高工作效率。

3. 智能客服:在客服场景中,UI-TARS-7B-SFT 能够根据用户的提问自动操作相关界面,提供精准的解答,提升客户满意度。

产品特色:

强大的视觉感知:在多种视觉任务中表现优异,能够准确识别界面元素。

高效的语义理解:能够准确理解自然语言指令,执行复杂的任务。

精准的界面定位:在复杂的GUI环境中快速定位目标元素,确保操作的准确性。

端到端任务自动化:无需预定义工作流,实现从任务开始到结束的全程自动化。

多模态输入支持:能够同时处理图像、文本等多种类型的数据,适应不同的交互需求。

记忆与推理能力:根据历史交互信息进行推理和决策,提升交互的智能化水平。

多任务处理:能够在多个任务之间灵活切换,提高工作效率。

良好的可扩展性:根据不同的需求进行定制和优化,满足多样化的应用场景。

使用教程:

1. 准备GUI界面:确保需要交互的GUI界面已准备就绪。

2. 加载模型:将UI-TARS-7B-SFT 模型加载到支持的框架中,如Hugging Face Transformers。

3. 输入指令:输入自然语言指令或图像等模态数据。

4. 模型处理:模型根据输入数据进行感知、推理和决策,生成相应的操作指令。

5. 执行任务:将操作指令发送到GUI界面,完成交互任务。

6. 优化效果:根据需要调整模型参数,优化交互效果。

通过以上步骤,您可以充分利用UI-TARS-7B-SFT 的强大功能,实现高效的GUI自动化交互。