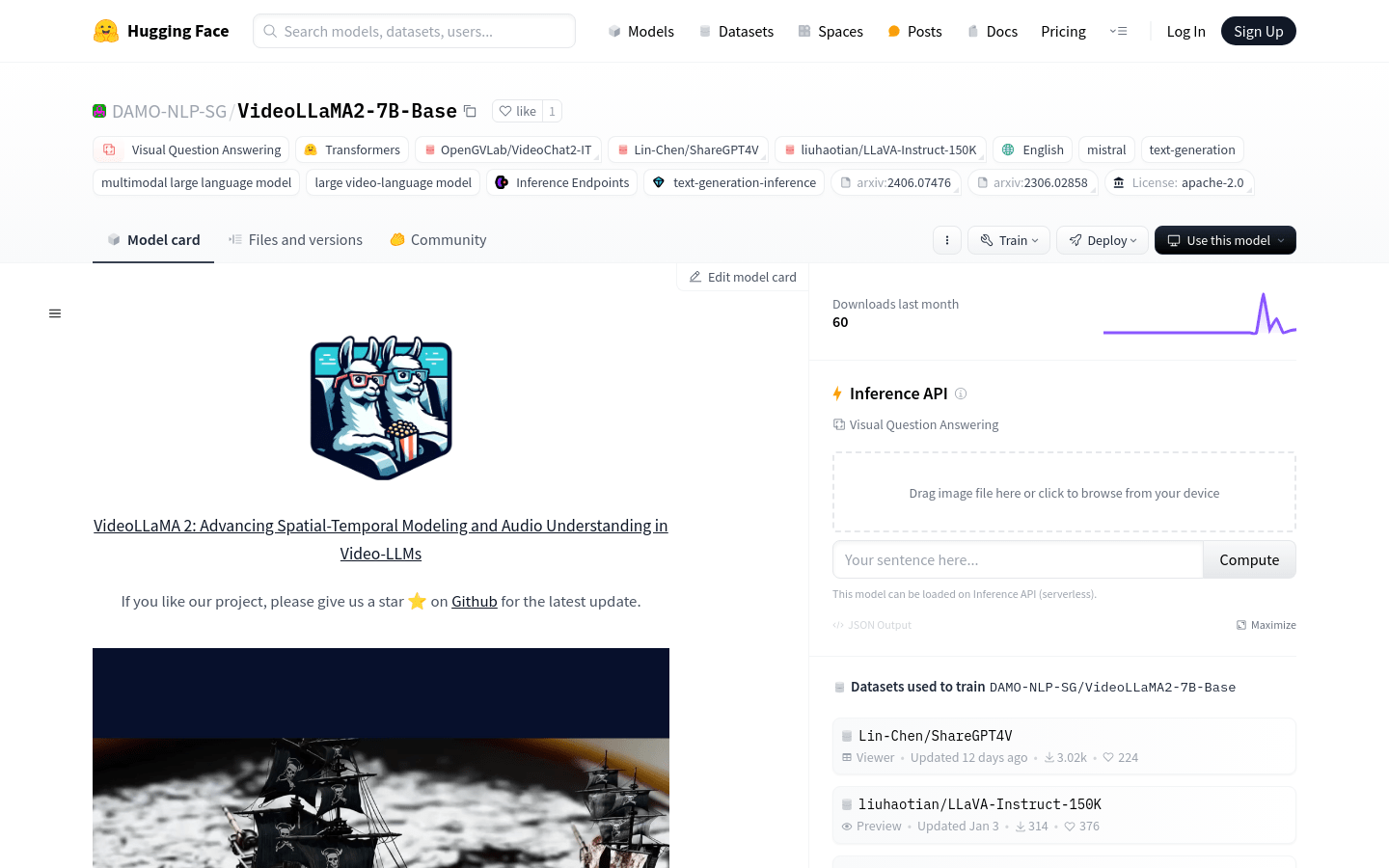

VideoLLaMA2-7B-Base

VideoLLaMA2-7B-Base analyzes and generates video content, supporting researchers, creators, and developers in visual問答, 字幕生成, and 多模態處理.

什麼是VideoLLaMA2-7B-Base ?

VideoLLaMA2-7B-Base是Damo-NLP-SG開發的大型視頻語言模型,專注於理解和生成視頻內容。它使用先進的時空建模和音頻理解功能在視覺詢問回答和視頻字幕生成中發揮出色。

誰可以使用此模型?

該模型非常適合分析視頻內容的研究人員,希望自動化視頻字幕的創作者以及將視頻分析工具集成到其應用程序中的開發人員。

示例場景:

研究人員可以分析社交媒體視頻以研究公共情感。

視頻創建者可以自動為教學視頻生成字幕以提高可訪問性。

開發人員可以通過將此模型集成到其應用程序中來提供自動化的視頻摘要服務。

關鍵功能:

視覺問題回答:了解視頻內容和答案相關的問題。

視頻標題生成:自動為視頻生成描述性字幕。

多模式處理:一起分析文本和視覺信息。

時空建模:優化對視頻空間和時間特徵的理解。

音頻理解:增強模型在視頻中解釋音頻的能力。

模型推理:提供快速輸出生成的推理接口。

代碼支持:提供培訓,評估和推理的代碼,以促進進一步的發展。

入門指南:

1。訪問擁抱面部模型庫頁面,然後選擇VideoLLaMA2-7B-Base模型。

2。閱讀模型文檔以了解輸入和輸出格式以及使用限制。

3。下載或克隆模型的代碼存儲庫,以進行本地部署或進一步開發。

4。安裝必要的依賴項並如代碼存儲庫中所述設置環境。

5。運行模型的推理代碼,輸入視頻文件和相關問題,並獲取模型輸出。

6。分析模型輸出並調整參數或根據需要進行進一步的開發。