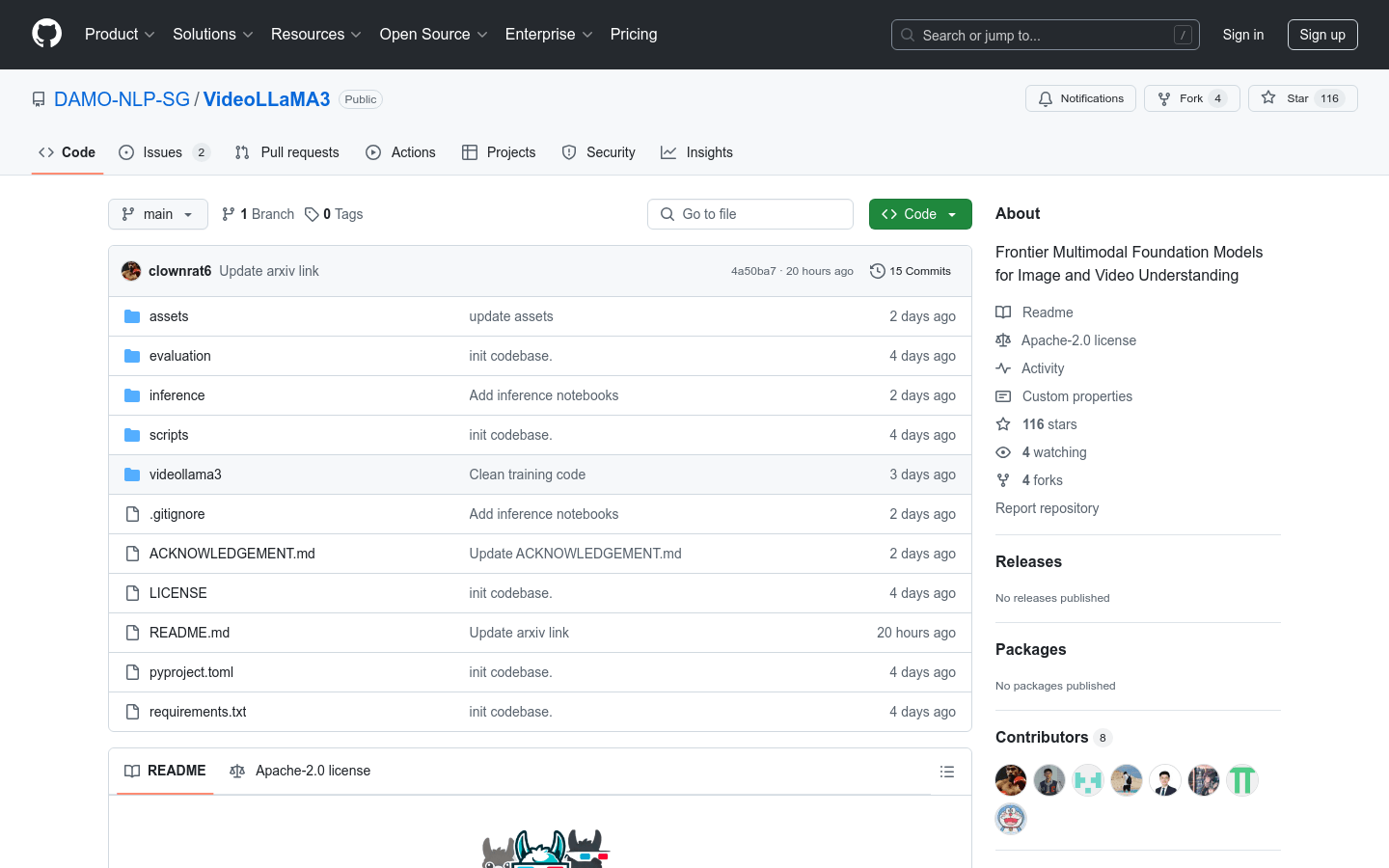

VideoLLaMA3

VideoLLaMA3 , a powerful multimodal model by DAMO-NLP-SG, excels in video and image understanding, offering natural language descriptions and accurate visual問答無法生成答案,請稍後重試~

什麼是VideoLLaMA3 ?

VideoLLaMA3是由Damo-NLP-SG團隊開發的尖端多模式基礎模型。它著重於圖像和視頻理解,將基於QWEN2.5體系結構的高級視覺編碼器與強大的語言生成功能相結合。由於其有效的時空建模,強大的多模式融合能力以及在大型數據集中進行了優化的培訓,該模型在復雜的視覺和語言任務中脫穎而出。

誰可以從VideoLLaMA3中受益?

需要深入視頻理解的研究人員,開發人員和企業可以從該模型中受益。它強大的多模式理解可幫助用戶更有效地處理複雜的視覺和語言任務,從而提高生產力和用戶體驗。

示例場景:

視頻內容分析:用戶可以上傳視頻並接收詳細的自然語言描述,從而幫助他們快速理解內容。

視覺問題回答:用戶可以詢問與視頻或圖像有關的問題,並獲得準確的答案。

多模式應用程序:將視頻和文本數據結合起來,用於內容生成或分類任務可提高性能和準確性。

關鍵功能:

支持多模式輸入,包括視頻和圖像,生成自然語言描述。

提供多種預訓練的模型,例如2B和7B參數版本。

優化用於使用高級時間建模的長視頻序列進行了優化。

支持多語言生成,用於跨語言視頻理解任務。

提供完整的推理代碼和在線演示,以便於設置。

支持本地部署和雲推斷以適合各種用例。

包括詳細的性能評估和基準測試結果,以幫助選擇正確的模型版本。

入門指南:

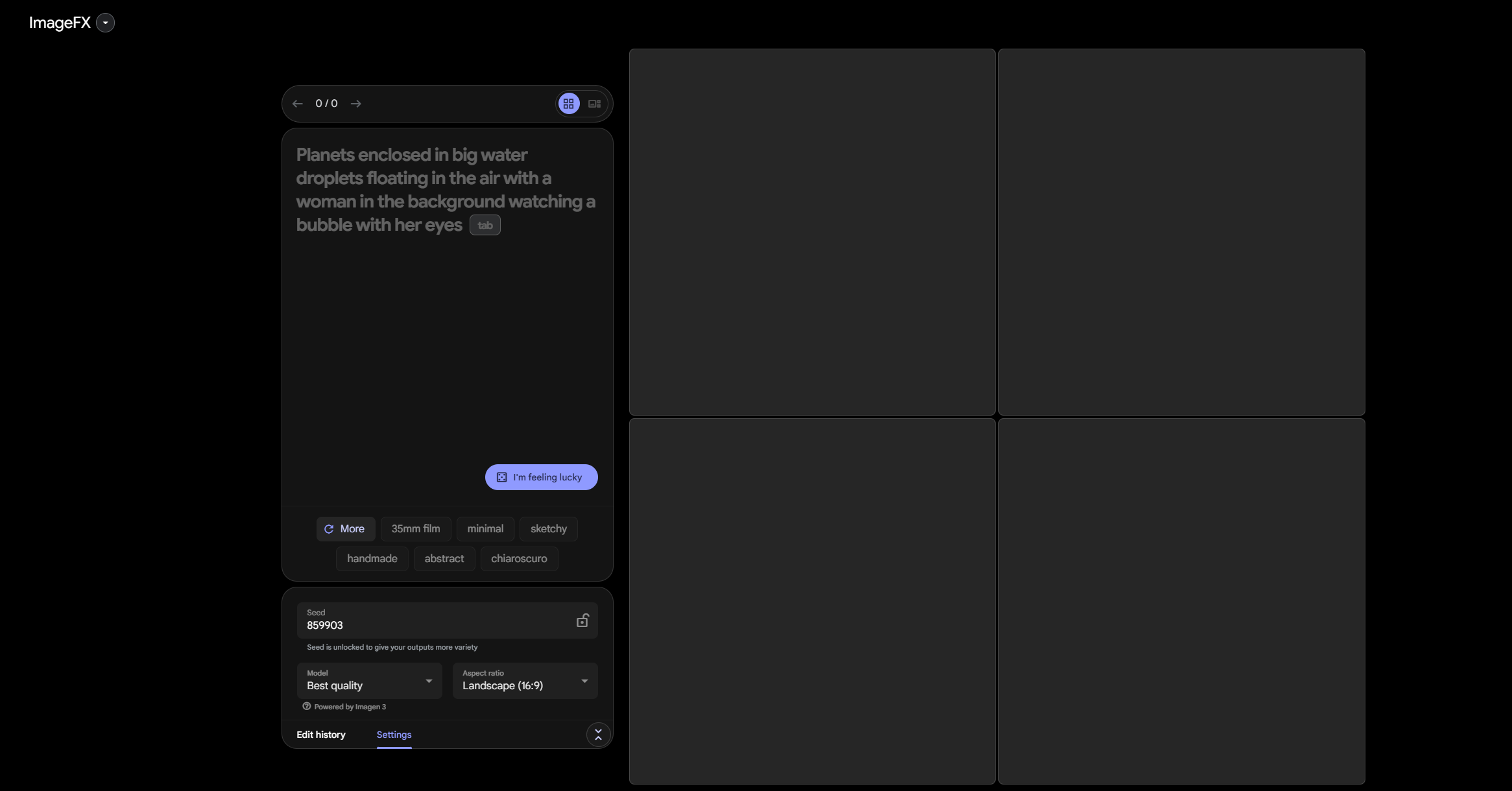

1。安裝必要的依賴項,例如Pytorch和Transformers。

2。克隆VideoLLaMA3 github存儲庫並安裝項目依賴項。

3。下載預訓練的型號權重,選擇2B或7B版本之間。

4。使用提供的推理代碼或在線演示來測試視頻或圖像數據。

5。調整模型參數或針對特定應用需求進行微調。

6。在本地或云中部署該模型以進行現實世界應用程序。